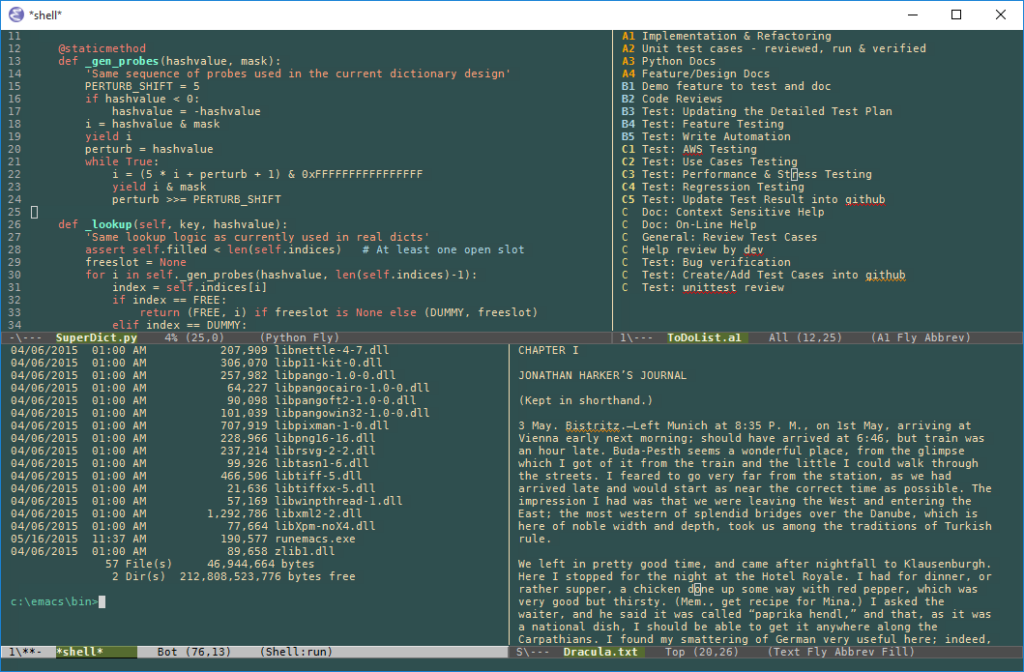

Richard Stallman non ha bisogno di presentazioni, ma di un aggiornamento software forse sì. Classe 1953, programmatore, informatico e attivista statunitense, è noto per essere uno dei principali esponenti del movimento del software libero. La sua carriera iniziò al laboratorio di intelligenza artificiale del MIT, dove sviluppò l’editor di testi Emacs nel 1975. Poi, nel settembre 1983, lanciò il progetto GNU con l’obiettivo di creare un sistema operativo completamente libero da copyright, e da allora ha insistito ossessivamente sul fatto che Linux a meno che non si parli esclusivamente del kernel – debba essere chiamato GNU/Linux. Una crociata quasi religiosa, che ancora oggi lo porta a rimarcare questa differenza con una passione degna di miglior causa.

A febbraio 2025, durante una lectio magistralis tenuta al Politecnico di Torino, Stallman ha detto la sua sull’intelligenza artificiale, ribadendo concetti che aveva già espresso in passato, come un vecchio vinile che salta sullo stesso solco.

Per Stallman, l’Intelligenza Artificiale è un Pappagallo (e non un Complimento)

Con il suo noto “tocco diplomatico” e la sua straordinaria delicatezza verbale, Stallman ha dichiarato che l’intelligenza artificiale generativa, così come la conosciamo oggi, non è altro che una macchina di fandonie. “Non comprendendo il significato di ciò che dice, si limita a ripetere frasi, come un pappagallo, con tutto il rispetto per i volatili”, ha detto, con quella verve che lo contraddistingue da decenni.

Secondo il paladino del software libero, i modelli linguistici possono produrre testi coerenti, ma non hanno alcuna consapevolezza o conoscenza reale. Sono strumenti privi di verità, in grado di generare solo disinformazione e errori. “I modelli linguistici non sanno nulla: giocano con le frasi, generano testi, senza capirne il significato,” ha insistito Stallman, apparentemente ignaro dei recenti sviluppi nell’elaborazione del linguaggio naturale.

Secondo lui, l’intelligenza artificiale non sta cambiando nulla. Nessuna rivoluzione tecnologica in corso, nessuna trasformazione epocale. Una posizione che sembra ignorare volutamente l’intero ecosistema dell’AI generativa.

Certo, bisogna ammettere che il termine “intelligenza artificiale” viene spesso usato con leggerezza e che paragonare le elaborazioni delle macchine ai processi cognitivi umani è un’esagerazione. Nessuno sano di mente affermerebbe il contrario. Tuttavia, l’innovazione non sta nel replicare la mente umana, ma nel creare strumenti che amplificano le capacità umane, producendo contenuti, analizzando dati e risolvendo problemi con un’efficacia senza precedenti.

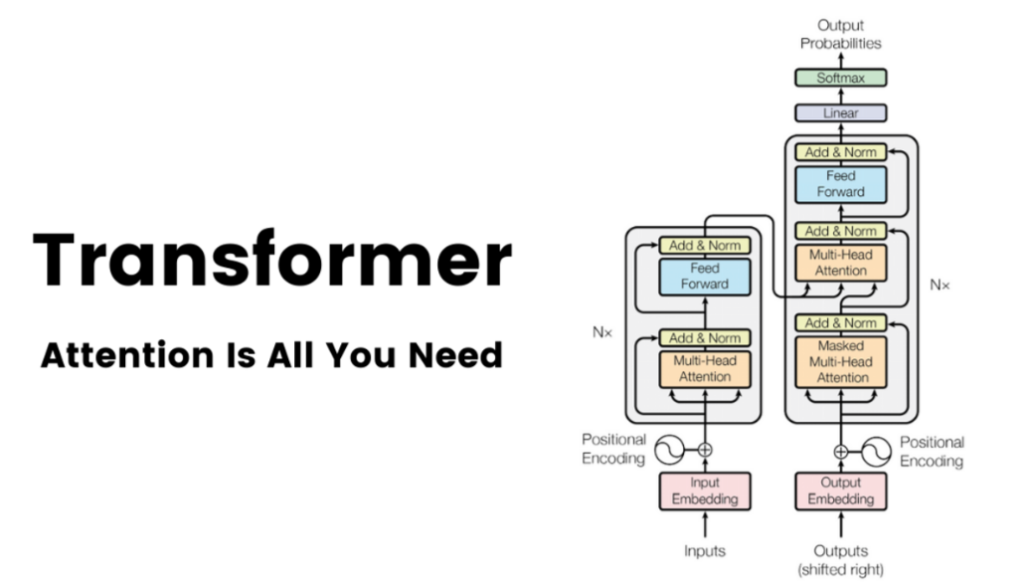

La vera rivoluzione è iniziata con lo studio “Attention Is All You Need” (2017), che ha introdotto i Transformer e il meccanismo di self-attention. Da allora, i modelli generativi hanno fatto passi da gigante, imparando a contestualizzare e a pesare le parole in modo dinamico. Ma per Stallman, tutto questo è fumo negli occhi, un gioco di prestigio che non merita attenzione.

Sostenere oggi che non ci sia alcuna rivoluzione in atto significa ignorare deliberatamente i progressi di modelli come ChatGPT, Claude, Gemini, e le piattaforme multimodali che integrano testo, immagini, audio e video. Questi strumenti non stanno solo evolvendo tecnologicamente, ma stanno ridefinendo interi settori: dall’educazione alla ricerca, dal marketing all’assistenza sanitaria.

Stallman sembra vivere in una realtà parallela, un universo statico dove tutto è rimasto fermo agli anni ’80, quando il vero nemico erano le licenze proprietarie e il software libero era l’unica via per la redenzione digitale. Oggi, il mondo è molto più complesso e l’intelligenza artificiale è parte integrante dell’evoluzione tecnologica.

Il punto su cui Stallman continua a battere è che i modelli generativi non “comprendono” il significato delle parole. E su questo ha perfettamente ragione, ma sta anche scoprendo l’acqua calda. Nessuno pretende che una macchina “capisca” come un essere umano. Tuttavia, ciò non toglie che questi modelli siano straordinariamente efficaci nel produrre output utili e coerenti.

Il fenomeno delle “allucinazioni” (errori o affermazioni false) è certamente un problema, ma le ultime versioni di questi modelli hanno significativamente ridotto l’impatto di questi errori grazie a tecniche avanzate di reinforcement learning e reasoning. Ad esempio, l’approccio “Chain of Thought” (CoT) consente ai modelli di scomporre i problemi complessi in passaggi logici, migliorando notevolmente l’accuratezza delle risposte, specialmente in ambito matematico e scientifico.

Stallman continua a combattere una guerra personale contro l’intelligenza artificiale, un po’ come Don Chisciotte contro i mulini a vento. Nella sua visione dogmatica, l’AI è semplicemente uno strumento di disinformazione, un pappagallo stocastico incapace di pensare.

Ma chi oggi utilizza i modelli generativi sa bene che il vero valore non è nella “comprensione” delle macchine, ma nella capacità di elaborare, sintetizzare e collegare informazioni a velocità e scala impensabili per un essere umano. È qui che risiede la rivoluzione che Stallman si rifiuta di vedere.

Se c’è un terreno su cui Stallman potrebbe ancora fare la differenza è quello della democratizzazione dell’AI. Invece di combattere una guerra persa contro l’innovazione, potrebbe concentrarsi su una battaglia più nobile: garantire che i modelli generativi siano aperti, trasparenti e accessibili a tutti.

I progetti open-source come GPT-Neo e LLaMA dimostrano che l’AI non deve necessariamente essere monopolio di pochi colossi tecnologici. Eppure, di questo Stallman non ha parlato. Ha preferito ridurre l’intera discussione a un’arida filippica contro un progresso che non vuole accettare.

Richard, se vuoi difendere la libertà digitale, inizia col riconoscere la realtà: l’intelligenza artificiale sta cambiando il mondo, e combatterla non serve a fermarla. Semmai, serve a renderti irrilevante.