La conferenza di Giorgio Parisi: Conferenza istituzionale – “Le radici fisiche della moderna intelligenza artificiale”, presso l’ Accademia dei Lincei, ci ha guidato attraverso un affascinante viaggio nella storia dell’intelligenza artificiale, svelandoci le radici fisiche e biologiche che ne hanno permesso lo sviluppo.

Dalle scoperte neuroscientifiche fondamentali ai modelli matematici e fisici, ogni passo di questo percorso ha contribuito a plasmare l’IA che conosciamo oggi. Comprendere queste radici è essenziale per affrontare le sfide e le opportunità che l’IA ci presenta nel futuro, consentendoci di sviluppare tecnologie sempre più intelligenti, efficienti e al servizio dell’umanità.

Un Eredità di Conoscenza per il Futuro dell’IA

Nell’era odierna, l’Intelligenza Artificiale (IA) permea ogni aspetto della nostra vita, trasformando radicalmente il modo in cui lavoriamo, comunichiamo e interagiamo con il mondo. Tuttavia, dietro gli algoritmi complessi e le reti neurali sofisticate si celano radici profonde che affondano nel terreno fertile della biologia, della neuroscienza e della fisica. In questa esplorazione, ispirata alla conferenza di Giorgio Parisi, intraprenderemo un viaggio storico per riscoprire le origini fisiche dell’IA moderna, ripercorrendo le tappe fondamentali che hanno portato allo sviluppo di questa tecnologia rivoluzionaria.

Le Scoperte Neuroscientifiche: I Mattoni Fondamentali

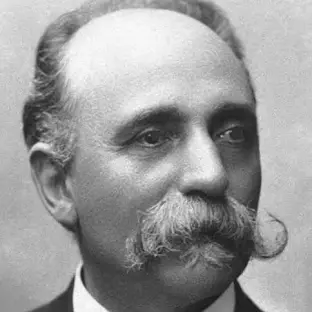

Camillo Golgi e la Rivoluzionaria Reazione Nera: Nel lontano 1873, lo scienziato italiano Camillo Golgi realizzò una scoperta epocale che avrebbe cambiato per sempre il corso della neuroscienza. Golgi sviluppò una tecnica di colorazione, battezzata “reazione nera”, in grado di tingere in modo vivido e dettagliato i singoli neuroni. Questa tecnica permise agli scienziati di osservare per la prima volta la struttura intricata e complessa delle cellule nervose, aprendo nuove frontiere nello studio del cervello.

Santiago Ramón y Cajal e la Teoria del Neurone: Ispirato dal lavoro pionieristico di Golgi, Santiago Ramón y Cajal, considerato il padre della neuroscienza moderna, utilizzò la reazione nera per approfondire lo studio del cervello. Ramón y Cajal formulò la teoria del neurone, un concetto rivoluzionario che postulava che i neuroni sono cellule individuali e distinte, e non una rete continua e indifferenziata come si credeva all’epoca. I suoi meticolosi disegni dei neuroni e delle loro connessioni sinaptiche, realizzati con una precisione sorprendente, rimangono ancora oggi una fonte di ispirazione per i neuroscienziati di tutto il mondo.

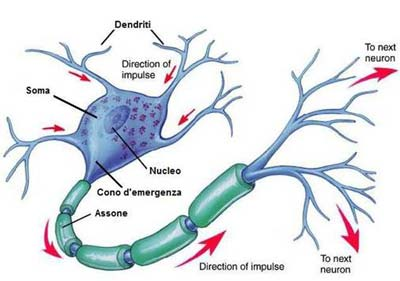

La Struttura e la Funzione del Neurone: Un’Architettura Sofisticata: Un neurone, l’unità fondamentale del sistema nervoso, è costituito da diverse componenti chiave. Il corpo cellulare (soma) contiene il nucleo e gli organelli cellulari. I dendriti, ramificazioni che si estendono dal soma, ricevono segnali da altri neuroni. L’assone, un lungo prolungamento che parte dal soma, trasmette il segnale elettrico ad altri neuroni attraverso le sinapsi.

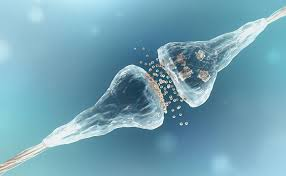

Le Sinapsi: Il Segreto della Comunicazione Neuronale: Le sinapsi, le giunzioni tra i neuroni, svolgono un ruolo cruciale nella trasmissione dell’informazione. Quando un segnale elettrico raggiunge la sinapsi, vengono rilasciati neurotrasmettitori, sostanze chimiche che attraversano lo spazio sinaptico e si legano ai recettori presenti sulla membrana del neurone ricevente, innescando un nuovo segnale elettrico. L’efficacia delle sinapsi non è statica, ma può variare in base all’attività neuronale, un fenomeno noto come plasticità sinaptica, che è alla base dell’apprendimento e della memoria.

La Regola di Hebb: L’Apprendimento Inciso nelle Sinapsi

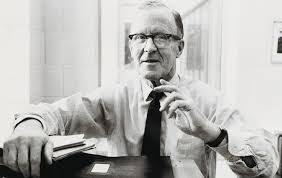

Nel 1949, il neuropsicologo Donald Hebb propose una teoria rivoluzionaria sull’apprendimento, che divenne nota come “regola di Hebb”. Hebb postulò che quando un neurone eccita ripetutamente un altro neurone, la connessione sinaptica tra i due si rafforza. In altre parole, i neuroni che “si attivano insieme, si connettono insieme”. Questa regola, apparentemente semplice, ha fornito un meccanismo plausibile per spiegare come il cervello apprende e memorizza le informazioni. Eric Kandel, premio Nobel per la Medicina nel 2000, ha poi fornito prove sperimentali a sostegno della regola di Hebb, aprendo nuove prospettive sulla comprensione dei processi di apprendimento e memoria.

Dai Neuroni Biologici ai Neuroni Formali: L’Astrazione Matematica

McCulloch e Pitts e il Neurone Formale: Negli anni ’40, i matematici Warren McCulloch e Walter Pitts svilupparono un modello semplificato del neurone biologico, il “neurone formale”. Questo modello, basato su principi logici e matematici, riceve input binari (attivo o non attivo) e si attiva se la somma degli input supera una determinata soglia. Il neurone formale rappresentava un’astrazione del neurone biologico, ridotto alla sua essenza funzionale.

La Cibernetica e il Percettrone: Negli anni ’50, Norbert Wiener e Rosenblatt fondarono la cibernetica, una disciplina interdisciplinare che studia i sistemi di controllo e comunicazione negli animali e nelle macchine. Nel 1959, Rosenblatt inventò il percettrone, una macchina in grado di riconoscere le lettere dell’alfabeto. Il New York Times salutò il percettrone come “l’embrione di un calcolatore elettronico capace di camminare, parlare e scrivere”, prefigurando le potenzialità dell’IA.

La Memoria Associativa e il Modello di Hopfield: Un Nuovo Paradigma per la Memoria

Il Problema della Memoria nei Computer Tradizionali: I computer tradizionali utilizzano una memoria indirizzabile, in cui le informazioni sono memorizzate in locazioni specifiche e accessibili tramite un indirizzo univoco. Tuttavia, il cervello umano sembra utilizzare un meccanismo di memoria diverso, noto come memoria associativa. Invece di cercare informazioni in specifici “cassetti”, il cervello recupera informazioni complete a partire da frammenti parziali, un po’ come quando riconosciamo una persona dal suo volto o dal suono della sua voce.

Il Modello di Hopfield: Una Rete Neurale per la Memoria Associativa: Negli anni ’80, il fisico John Hopfield sviluppò un modello di rete neurale in grado di implementare una memoria associativa. In questo modello, ogni neurone può essere attivo o inibito, e la rete evolve verso uno stato di equilibrio che rappresenta una memoria specifica. Il modello di Hopfield ha dimostrato come una rete di neuroni formali possa imitare le capacità di memoria associativa del cervello umano.

L’evento