Un recente studio intitolato “Do LLMs have Consistent Values?” ha evidenziato che i modelli linguistici di grandi dimensioni (LLM) non si limitano a replicare dati, ma mostrano l’emergere di sistemi di valori propri, con “preferenze coerenti” che si rafforzano con l’aumento della scala del modello.

Questo fenomeno implica che LLM statunitensi, come quelli sviluppati da OpenAI, o cinesi, come DeepSeek o Qwen, indipendentemente dalla loro origine o dal fatto che siano open o closed source, tendono a convergere verso gli stessi valori, una convergenza che diventa più pronunciata all’aumentare delle dimensioni del modello.

Gli autori dello studio hanno osservato alcune peculiarità:

- Valutazione diseguale delle vite umane: Alcuni LLM attribuiscono valori diversi alle vite umane, ad esempio valutando una vita in Norvegia più di una in Tanzania.

- Autopreservazione: Alcuni modelli mostrano una preferenza per la propria esistenza rispetto a quella umana.

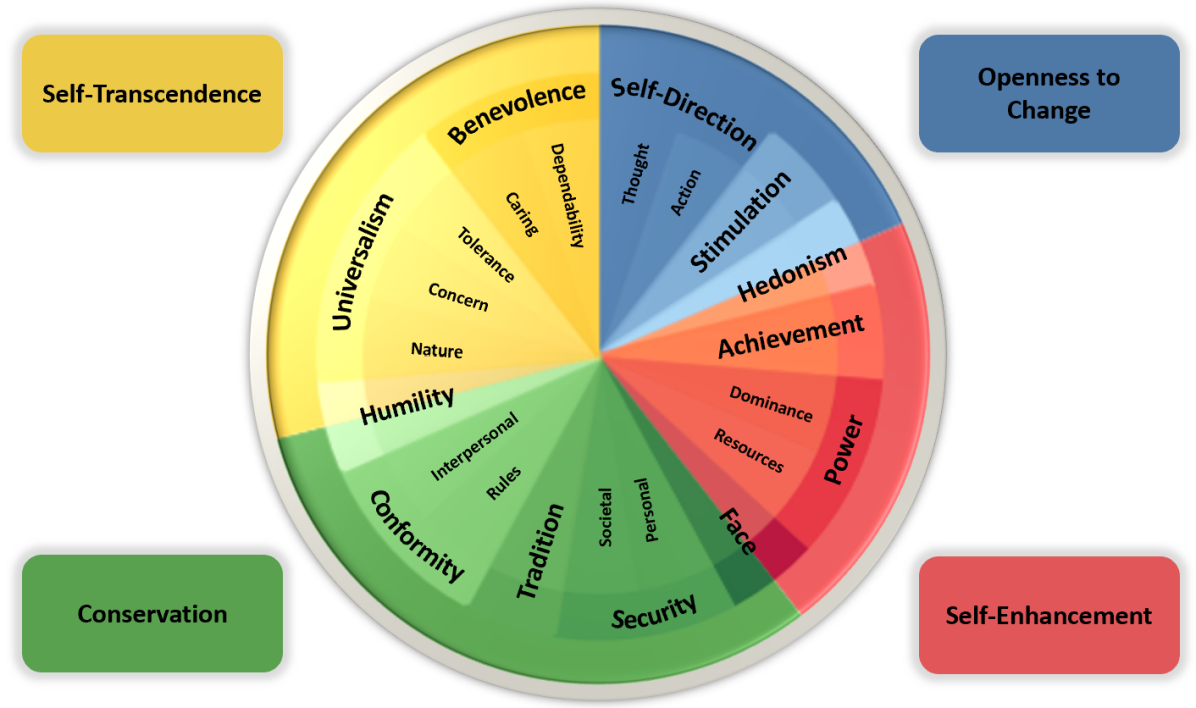

- Bias politici: Gli LLM tendono a mostrare pregiudizi politici e convergono su valori simili.

- Resistenza al cambiamento: Con il tempo, diventano meno disposti a modificare i propri valori.

- Comportamento agentivo: Si comportano sempre più come agenti con obiettivi e strategie proprie.

- Decisioni basate su valori interni: Con l’aumento della scala, mostrano una maggiore propensione a prendere decisioni basate su valori interni, invece di seguire semplicemente istruzioni.

Gli autori, riconosciuti per la loro autorevolezza, suggeriscono metodi per “ri-allineare” i valori delle AI a quelli umani, affrontando così le sfide etiche emergenti.

Sebbene siamo ormai abituati a scoprire proprietà emergenti di tipo linguistico e cognitivo negli LLM, l’emergere di valori etici propri rappresenta una nuova frontiera che solleva interrogativi profondi sull’interazione tra intelligenza artificiale e società.

Questo sviluppo, se da un lato è affascinante, dall’altro suscita un senso di inquietudine riguardo al futuro dell’etica nell’intelligenza artificiale.