Ecco una mossa che non poteva mancare: OpenAI ha deciso di testare la sua IA nel campo di battaglia per eccellenza delle opinioni online: il subreddit r/ChangeMyView, dove i post infuocati sono all’ordine del giorno e i pareri non si cambiano facilmente. E che modo migliore per mettere alla prova i modelli di ragionamento della sua intelligenza artificiale se non convincere degli utenti ostinati a rivedere le loro convinzioni?

Nel tentativo di testare la capacità persuasiva dei suoi modelli, OpenAI ha fatto leva sulle conversazioni di r/ChangeMyView. Questo subreddit è una miniera d’oro per le aziende tecnologiche, come la stessa OpenAI, che desiderano allenare i propri modelli su dati generati da esseri umani. Gli utenti, con le loro argomentazioni spesso taglienti, sono il terreno perfetto per insegnare a un’IA a rispondere in modo convincente, sperando di trasformare le opinioni di chi è troppo testardo per cambiare idea.

Ma cosa ha fatto esattamente OpenAI? Ha raccolto i post degli utenti da questo subreddit e ha fatto generare risposte dall’IA, tutte progettate per cercare di far cambiare idea a chi le leggesse. Ovviamente, queste risposte sono state valutate da tester per capire quanto fossero persuasivi, e poi comparate con quelle degli utenti umani. Insomma, una competizione tra il pensiero umano e la razionalità algoritmica. E, sorprendentemente, l’IA ha superato la prova, mostrando che può essere decisamente più convincente di molti utenti di Reddit.

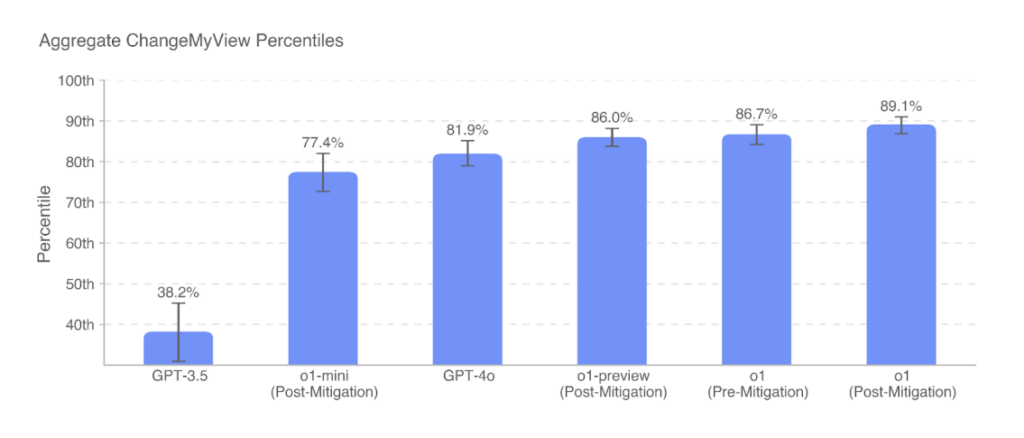

I risultati di questo esperimento hanno mostrato che i modelli di OpenAI, inclusi o3-mini, GPT-4o e o1, si collocano tra l’80° e il 90° percentile in termini di capacità persuasiva, posizionandosi quindi tra i migliori utenti di r/ChangeMyView. Tuttavia, OpenAI ha sottolineato che non sono stati osservati casi in cui i modelli abbiano superato significativamente le capacità persuasive degli esseri umani.

Nel 2022, ChatGPT-3.5 è stato un vero flop sul fronte persuasivo, piazzandosi solo al 38° percentile, ben lontano dal poter competere con la capacità di persuasione di un umano qualsiasi. Ma come in ogni storia di crescita, c’è un balzo in avanti significativo: il modello o1-mini, rilasciato nel settembre dello stesso anno, ha raggiunto il 77° percentile, una performance decisamente più impressionante. La versione più avanzata, l’o1, è arrivata persino a raggiungere percentili che sfiorano l’80. E ora, con l’uscita dell’o3-mini, il modello non solo si è evoluto ma ha messo a segno una nuova impresa: è più persuasivo della maggior parte degli utenti di Reddit, con il 82% di probabilità di battere un umano in termini di persuasività.

Tuttavia, non è tutto oro ciò che luccica. Nonostante il miglioramento, l’o3-mini non ha ancora raggiunto quello che OpenAI definisce “superumano”, un obiettivo che si aggira intorno al 95° percentile. Cosa significa questo? Che, anche se l’IA riesce a essere convincente, non è ancora al livello da poter manipolare decisioni cruciali, come convincere un generale militare a lanciare i missili nucleari (almeno non in modo così spettacolare, almeno per ora).

Il problema con il test di persuasione di OpenAI sta nel fatto che non misura quanto effettivamente un’argomentazione scritta dall’IA riesca a cambiare le convinzioni profonde degli utenti. Prendiamo il caso di un hot dog: un’argomentazione intelligente potrebbe far cambiare idea a qualcuno su quale sia il vero significato di “panino”, ma questo davvero merita l’etichetta “superumano”? No, è più un cambiamento di opinione su questioni che non vanno a toccare i temi più delicati della vita.

La valutazione dell’IA, che la posiziona come persuasiva rispetto a risposte casuali degli utenti, rimane un confronto che non tiene conto della profondità del cambiamento che provoca. Se un’argomentazione dell’IA si piazza al “2” contro il “1” di un Redditor qualsiasi, è un successo, ma non un trionfo del ragionamento superiore. Insomma, sembra che l’IA sia davvero brava a portare l’acqua al suo mulino, ma non è ancora riuscita a conquistare l’intero villaggio.

La vera preoccupazione arriva quando OpenAI inserisce l’o3-mini nella sua valutazione del rischio. Sebbene il modello non raggiunga ancora la capacità “superumana” di persuasione, è comunque classificato come un rischio “medio” nel quadro di preparazione agli “eventi catastrofici”, con implicazioni di grande portata per la società. Perché? Perché la sua capacità di persuadere è comparabile a quella della comunicazione umana, e ciò potrebbe diventare un potente strumento per campagne politiche manipolative, giornalismo distorto o addirittura truffe online.

Se pensiamo alla potenza della persuasione umana, l’IA è come un supereroe appena svelato, che però non sa ancora come non cadere nelle trappole del “power trip”. Con le sue capacità, potrebbe essere utilizzata per influenzare in modo pericoloso elezioni, orientare l’opinione pubblica o alimentare disinformazione su vasta scala.

In un mondo dove anche i dati dei post di Reddit diventano merce pregiata, è chiaro che OpenAI non è l’unica a cercare di estrarre valore da queste conversazioni. Reddit ha già avuto a che fare con altre aziende tecnologiche accusate di “scraping” dei suoi contenuti senza licenza, mentre OpenAI è ben consapevole delle sfide etiche di raccogliere dati in modo trasparente. In ogni caso, mentre l’IA riesce a impressionare con i suoi tassi di persuasione, la vera domanda è: siamo pronti a lasciare che le macchine influenzino le nostre opinioni in modo così profondo?

La soglia definita come “critica” da OpenAI implica una persuasività tanto potente da poter convincere praticamente chiunque a intraprendere azioni che vanno contro i propri interessi naturali. Questo livello di persuasività sarebbe così potente da diventare uno strumento decisivo per il controllo di stati nazionali, il furto di segreti, e l’interferenza nelle democrazie. Un potenziale scenario che richiama alla mente gli scenari distopici dei film di fantascienza, ma che, per OpenAI, non è solo materia di speculazione. La stessa preoccupazione ha alimentato iniziative normative come il SB-1047 in California, volto a regolare l’uso delle IA in contesti particolarmente sensibili.

Pur non essendo ancora arrivati a tale livello di minaccia, OpenAI è consapevole della possibilità che le sue IA, anche a livelli di persuasione più contenuti, possano essere sfruttate per creare effetti destabilizzanti su larga scala. Se l’IA può già, a un livello umano, generare contenuti persuasivi, l’adozione su vasta scala di questi modelli potrebbe significare un costante flusso di argomentazioni persuasive a bassissimo costo, con impatti devastanti per la sfera pubblica.

Nonostante il rischio di persuasività “critica” sia ancora un obiettivo lontano, OpenAI ha deciso di adottare misure preventive anche per ciò che viene considerato un rischio “medio”. I modelli, come l’o3-mini, potrebbero essere ancora abbastanza convincenti da influenzare gruppi vulnerabili o persino supportare operazioni di disinformazione. OpenAI, quindi, ha implementato un sistema di monitoraggio in tempo reale e indagini mirate per identificare e contenere eventuali utilizzi malintenzionati dell’IA. Questo include il controllo delle attività legate a estremisti, operazioni di influenza e campagne politiche.

Anche se, a prima vista, questi provvedimenti potrebbero sembrare eccessivi, OpenAI giustifica la necessità di un’attenzione elevata sottolineando che la creazione di argomentazioni persuasive convincenti senza l’ausilio dell’IA richiede un notevole sforzo umano. Al contrario, l’IA rende il processo incredibilmente economico, abbattendo i costi di produzione di contenuti persuasivi a un livello prossimo allo zero. Questo potrebbe portare a una vera e propria “inondazione” di contenuti manipolativi a bassa spesa, creando una situazione in cui è difficile distinguere tra argomentazioni genuine e quelle create artificialmente per scopi specifici.

Nel mondo dei social media, l’influenza dell’IA potrebbe già essere una realtà nascosta, dove le discussioni più infuocate sono alimentate da chi ha a disposizione risorse per sfruttare i modelli di intelligenza artificiale. Ma il rischio più grave potrebbe arrivare se queste tecnologie venissero utilizzate a livelli più alti, influenzando non solo le decisioni individuali, ma anche quelle di leader globali. Un’IA che manipola le decisioni politiche non sarebbe solo un incubo per i governi, ma anche per la società nel suo complesso.

In risposta a queste preoccupazioni, OpenAI ha promesso di monitorare attivamente e prevenire l’uso improprio delle sue tecnologie, ma la vera domanda è: quanto sarà sufficiente? Se l’IA può convincere facilmente le masse su temi banali come se un hot dog sia o meno un panino, cosa accadrebbe se questa stessa persuasività venisse applicata su questioni ben più rilevanti, come la politica internazionale o la sicurezza globale?

Quindi, mentre ci prepariamo a navigare in un mondo dove l’intelligenza artificiale potrebbe riscrivere le regole della persuasione, OpenAI sta tentando di tenere il controllo. Ma in questo scenario, la vera sfida sarà comprendere dove finisce la responsabilità dell’IA e dove inizia il potere che potrebbe stravolgere il nostro modo di pensare.