L’avvento dei modelli di intelligenza artificiale basati su Large Language Models (LLM) ha trasformato numerosi settori, dall’elaborazione del linguaggio naturale alla valutazione automatica delle risposte generate dall’IA. Tuttavia, un problema fondamentale è la difficoltà di strutturare il ragionamento in modo che il processo di valutazione sia coerente, trasparente e interpretabile. Il paper Learning to Plan & Reason for Evaluation with Thinking-LLM-as-a-Judge affronta proprio questa sfida, introducendo EvalPlanner, un algoritmo che separa la fase di pianificazione della valutazione da quella dell’esecuzione, ottimizzando così il processo di giudizio dell’LLM.

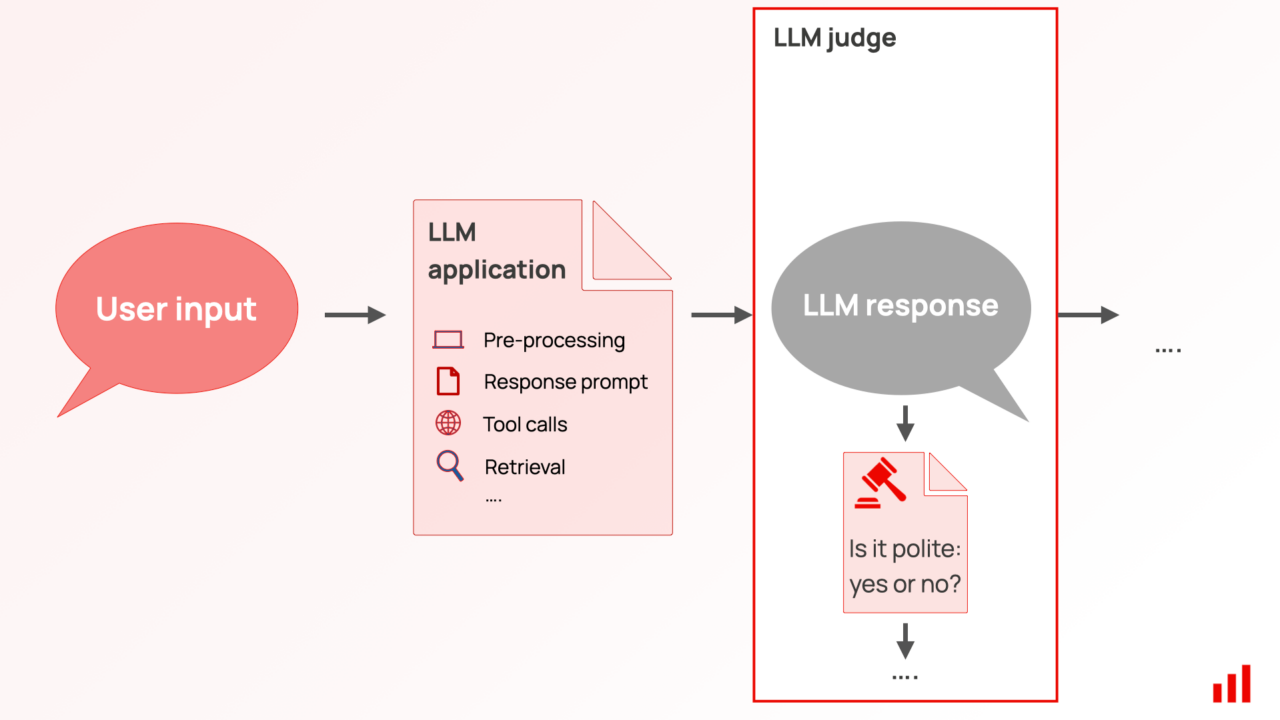

Il modello LLM-as-a-Judge è un framework in cui un modello generativo non solo valuta le risposte, ma lo fa seguendo un processo di ragionamento esplicito, noto come Chain-of-Thought (CoT). Tuttavia, l’assenza di dati umani annotati per guidare questo ragionamento ha portato a strategie limitate, che spesso impongono criteri rigidi o domande di verifica predefinite. Questo vincolo riduce la flessibilità dell’LLM e limita le sue capacità di adattamento a contesti complessi.

Per risolvere questa problematica, EvalPlanner introduce un approccio in tre fasi: prima genera un piano di valutazione indipendente e non vincolato, poi esegue il ragionamento basato su questo piano e infine fornisce un giudizio finale. Questa separazione consente di ottimizzare ogni fase del processo in modo indipendente, migliorando così la qualità complessiva della valutazione. L’innovazione chiave è l’uso di un ciclo di self-training, in cui il modello migliora iterativamente il proprio processo di valutazione basandosi su piani ed esecuzioni sintetiche.

I risultati sperimentali dimostrano l’efficacia di questo approccio: EvalPlanner ha raggiunto il nuovo stato dell’arte nella valutazione dei modelli generativi con un punteggio di 93.9 su RewardBench, superando modelli addestrati con quantità significativamente maggiori di dati. Inoltre, ulteriori test su benchmark come RM-Bench, JudgeBench e FollowBenchEval confermano l’importanza di una combinazione tra pianificazione e ragionamento per costruire modelli di valutazione LLM più affidabili e robusti.

L’adozione di EvalPlanner potrebbe avere un impatto significativo in diversi settori, dalla valutazione delle risposte nei chatbot avanzati alla verifica dell’accuratezza dei contenuti generati dall’IA. Separando la pianificazione dalla valutazione, si può migliorare la trasparenza dei modelli, ridurre i bias e ottimizzare l’intero processo decisionale dell’IA, rendendolo più simile a un giudizio umano informato e razionale.