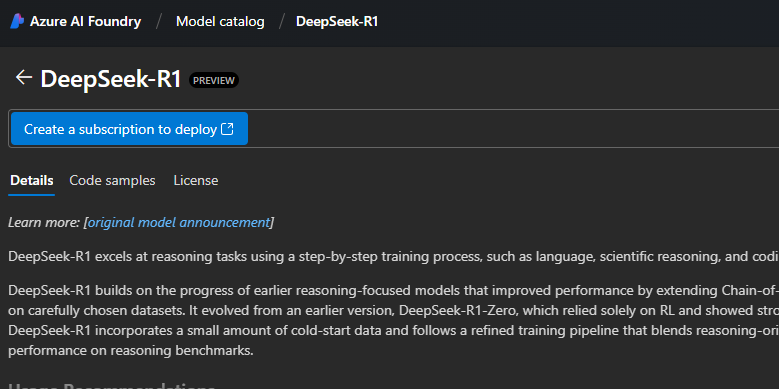

La presenza del modello DeepSeek-R1 all’interno di Microsoft Azure AI Foundry solleva diverse questioni strategiche e tecniche. Il modello, con i suoi 671 miliardi di parametri totali e 37 miliardi di parametri attivi, rappresenta un passo significativo nell’evoluzione delle AI focalizzate sul ragionamento, sfruttando sia il Chain-of-Thought (CoT) che il reinforcement learning (RL). Tuttavia, le implicazioni della sua integrazione nella piattaforma di Microsoft vanno oltre il semplice miglioramento delle capacità di AI disponibili per gli utenti aziendali.

La Mossa di Microsoft e il Controllo sul Modello

Microsoft, pur essendo strettamente legata a OpenAI, ha dimostrato di voler ampliare la propria offerta in ambito AI, anche considerando modelli provenienti dalla Cina. La presenza di DeepSeek-R1 su Azure AI Foundry potrebbe avere molteplici finalità:

- Analisi e Benchmarking – Microsoft potrebbe voler confrontare DeepSeek-R1 con i propri modelli (inclusi quelli di OpenAI) per valutarne i punti di forza e di debolezza.

- Valutazione di Rischi e Conformità – Considerando le critiche sulla censura e sulla scarsa accuratezza riportate da NewsGuard, Microsoft potrebbe voler testare fino a che punto il modello è conforme agli standard richiesti per operare a livello globale.

- Strategia Legale e di Protezione dell’IP – L’ipotesi che questa mossa possa essere un modo per raccogliere informazioni su potenziali violazioni di proprietà intellettuale è plausibile. Se OpenAI sospetta che DeepSeek possa aver incorporato contenuti derivati dai suoi modelli, Microsoft potrebbe voler analizzare il comportamento del modello per anticipare eventuali controversie legali.

Le Debolezze di DeepSeek-R1

Nonostante le sue capacità avanzate nel ragionamento, il modello mostra debolezze significative:

- Alta percentuale di risposte inaccurate (83%) su domande di attualità, suggerendo un training con dati non aggiornati o non ottimizzati per la verifica dei fatti.

- Censura significativa (85% di rifiuto alle domande sulla Cina), che suggerisce limitazioni imposte dallo sviluppo in un contesto soggetto a forti restrizioni governative.

Questi due aspetti potrebbero limitare l’adozione del modello su larga scala, specialmente per applicazioni enterprise che richiedono coerenza, affidabilità e neutralità informativa.

Il Conflitto di Interesse con OpenAI

Microsoft si trova in una posizione delicata: da un lato è il principale partner di OpenAI, dall’altro sta esplorando alternative che potrebbero minare la sua stessa alleanza. L’adozione di DeepSeek-R1 su Azure potrebbe essere letta come un segnale a OpenAI, suggerendo che Microsoft sta valutando opzioni alternative nel caso in cui il rapporto con OpenAI diventasse instabile o troppo vincolante. Inoltre, se dovessero emergere prove che DeepSeek-R1 utilizza tecnologie derivate da OpenAI senza autorizzazione, Microsoft potrebbe avere una posizione più forte per intervenire senza compromettere il proprio coinvolgimento con OpenAI.

Scenario Futuro

Se DeepSeek-R1 dovesse migliorare rapidamente le sue capacità, eliminando le sue debolezze attuali, potrebbe diventare un’alternativa credibile ai modelli di OpenAI. Tuttavia, per ora, la sua affidabilità limitata e la censura imposta lo rendono poco adatto per un impiego commerciale su larga scala. Microsoft potrebbe usare questa fase di test per influenzare lo sviluppo del modello, oppure per raccogliere informazioni utili in ottica competitiva e legale.

L’evoluzione di questa situazione sarà cruciale per comprendere se Microsoft stia solo esplorando opzioni o se stia effettivamente cercando di ridurre la propria dipendenza da OpenAI.