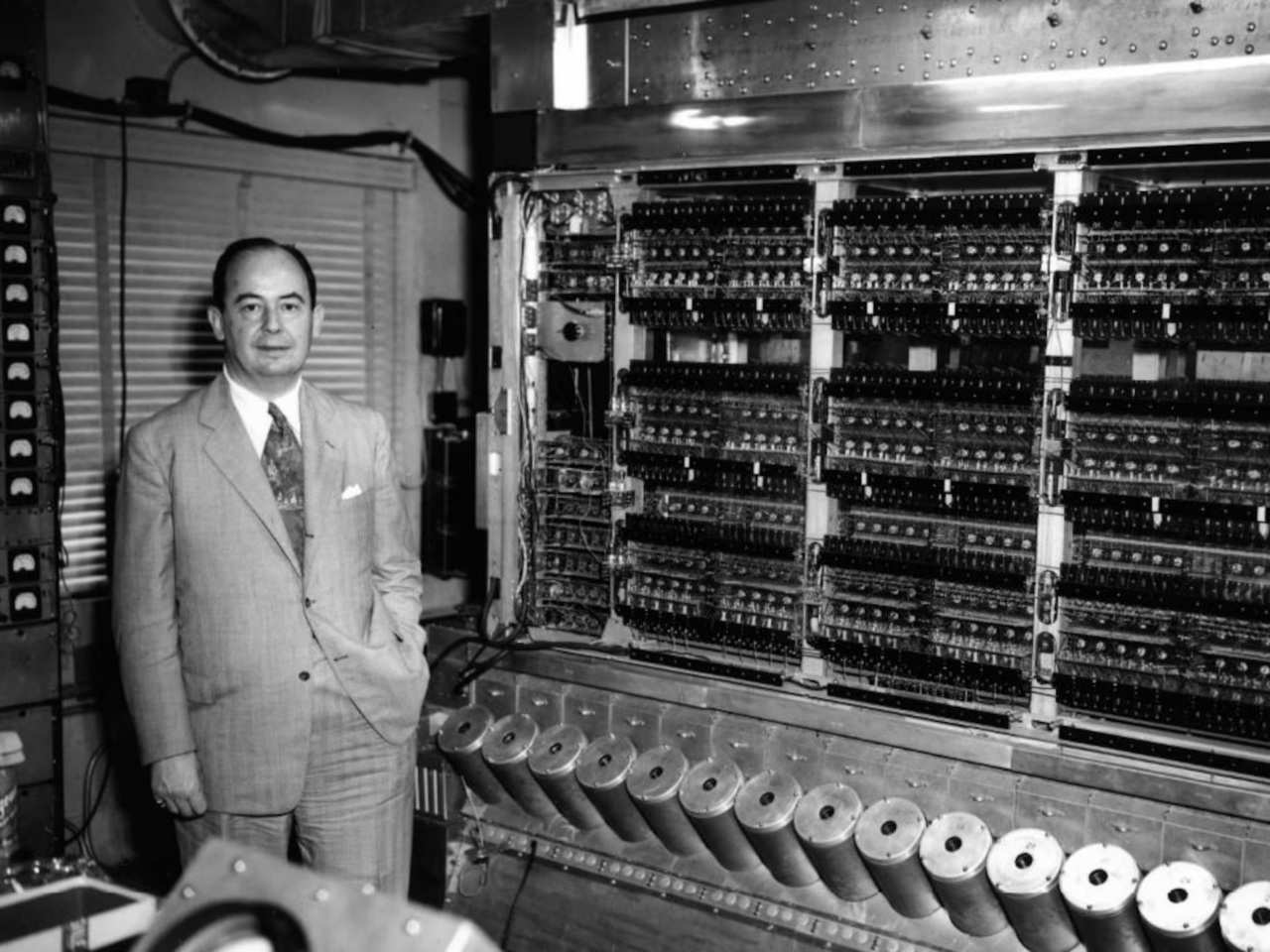

John von Neumann nacque nel 1903 con un problema che non sapeva ancora di avere. Certo, era un bambino prodigio, capace di moltiplicare numeri a sei cifre a mente mentre i suoi coetanei si limitavano a non mangiarsi i pastelli a cera. Ma il destino aveva in serbo per lui una beffa matematica: creare un’architettura informatica così geniale da diventare lo standard… e al tempo stesso così limitante da tormentare generazioni di ingegneri per decenni.

Von Neumann, che si dilettava in ogni campo dello scibile umano – dalla matematica all’economia, dalla teoria dei giochi alle bombe nucleari – non poteva immaginare che il suo capolavoro, l’architettura di Von Neumann, sarebbe diventato anche il suo più grande lascito problematico.

Il principio era semplice, quasi elegante: una CPU che esegue istruzioni prelevandole dalla memoria, elaborando dati e rispedendoli indietro. Un’idea brillante… finché non si iniziò a chiedere sempre più velocità ai computer. Fu allora che il suo nome venne associato a un concetto che avrebbe fatto impallidire qualunque inventore: il Bottleneck di Von Neumann.

Il problema era che memoria e processore dovevano comunicare attraverso un unico canale, come una sola persona che tenta di svuotare il Titanic con un cucchiaio. Più i dati aumentavano, più questa strozzatura diventava soffocante. L’era dei supercomputer e delle intelligenze artificiali esigeva prestazioni sempre più elevate, ma l’antica architettura di Von Neumann resisteva, come un vecchio nobile che si rifiuta di abbandonare il suo castello decrepito.

Le menti più brillanti del mondo si arrovellavano su come superare questo limite. Alcuni tentarono la strada delle architetture neuromorfiche, ispirate al cervello umano, con connessioni parallele e sinapsi di silicio. Altri puntarono sulle memorie computazionali, cercando di portare l’elaborazione vicino ai dati, invece di spedirli avanti e indietro come pacchi Amazon. Ma la vera sorpresa arrivò da un gruppo di ricercatori chiamato DeepSeek, che aveva un asso nella manica: Multihead Latent Attention.

Questa tecnica, apparentemente astrusa, si rivelò una benedizione per chiunque fosse costretto a lavorare con enormi moli di dati. Invece di affidarsi a una gestione rigida e sequenziale delle informazioni, Multihead Latent Attention riusciva a lavorare con matrici più piccole, riducendo drasticamente il peso computazionale dei modelli di deep learning.

Era come se Von Neumann, dal suo ipotetico aldilà, si fosse piegato su una scacchiera quantistica e avesse esclamato: “Ah, ecco dove sbagliavo!”

Il principio era affascinante: anziché dover manipolare enormi matrici dense – come i classici Transformer, che si portavano dietro una zavorra pesantissima – Multihead Latent Attention trovava un modo per far emergere le informazioni essenziali senza sprechi. Un po’ come filtrare le conversazioni più interessanti in una festa caotica senza dover ascoltare tutti gli invitati.

Questa tecnica, che strizzava l’occhio alle bio-memorie e ai processori neuromorfici, rappresentava un passo avanti epocale: il bottleneck di Von Neumann non veniva eliminato, ma aggirato con un’eleganza che avrebbe fatto sorridere lo stesso Von Neumann. Finalmente, dopo decenni di tentativi, la sua eredità poteva essere riscattata non con la distruzione dell’architettura che portava il suo nome, ma con una soluzione che la faceva funzionare meglio, quasi senza sforzo.

Forse il vecchio Von Neumann, noto per il suo sarcasmo e il suo senso dell’ironia, avrebbe apprezzato il colpo di scena. Dopo tutto, anche la scienza ama le sue beffe: per risolvere il problema più grande del suo genio, c’è voluto un secolo e un’intelligenza artificiale.