Altro che Pinocchio! La recente rivelazione del modello o3 di OpenAI—che vanta risultati strabilianti nei benchmark e promette trionfi nell’ambito dell’intelligenza artificiale generale (AGI)—è stata una vera e propria spettacolarizzazione. Il mondo della tecnologia era in subbuglio, convinto che stavamo per varcare la soglia di qualcosa di rivoluzionario. Ma poi, come un colpo di scena mal scritto, la verità ha iniziato a emergere. Il modello o3 di OpenAI ha ottenuto un brillante 25,2% nel benchmark FrontierMath, un test matematico complesso sviluppato da Epoch AI. Impressionante? Certo. Ma qui arriva l’ironia: OpenAI non si è limitata a usare il test, l’ha anche contribuito a scriverlo, il dubbio era palese… e ne avevamo parlato piu’ volte.

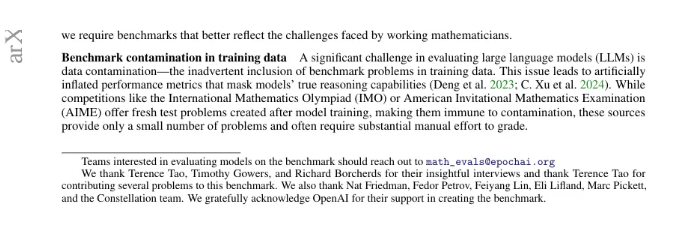

Epoch AI, in una nota aggiuntiva rilasciata a tempo debito, ha riconosciuto il supporto di OpenAI nello sviluppo di FrontierMath.

Come potete leggere nel doc allegato: Ringraziamo sentitamente OpenAI per il suo supporto nella creazione del benchmark.

Non proprio un dettaglio da ignorare. E, come se non bastasse, è emerso che OpenAI non si è limitata a finanziare lo sviluppo del benchmark, ma ha avuto accesso sia ai problemi che alle soluzioni, facendone ciò che voleva. Epoch AI ha successivamente rivelato che OpenAI aveva incaricato l’azienda di fornire 300 problemi matematici, completi di soluzioni.

Fiato alle trombe Turchetti! ecco dove la trama si fa ancora più interessante: OpenAI aveva accesso diretto a queste domande e risposte, un fatto che ha sollevato più di qualche bandiera rossa tra gli appassionati del settore. Epoch AI ha confermato che OpenAI ha contratto un accordo che le impediva di utilizzare queste informazioni nel proprio database per allenare il modello o3. Eppure, come osservano molti esperti, l’accesso a tale materiale potrebbe comunque aver permesso a OpenAI di ottimizzare le prestazioni del modello attraverso aggiustamenti iterativi.

Onore al quotidiano The Information che è stato il primo a dare la notizia .

A peggiorare la situazione, Epoch AI ha inizialmente richiesto che la sua relazione finanziaria con OpenAI fosse mantenuta segreta, ma successivamente ha ammesso che sarebbe stato meglio essere trasparenti fin da subito. Un accordo verbale, tuttavia, non è mai un segno rassicurante quando si tratta di modelli di intelligenza artificiale e delle loro capacità di “ragionamento”.

La questione non si limita a OpenAI. Una recente indagine condotta dal ricercatore AI Louis Hunt ha rivelato che anche altri modelli di punta, tra cui Mistral 7b, Gemma di Google, Phi-3 di Microsoft, Llama-3 di Meta e Qwen 2.5 di Alibaba, sono stati in grado di riprodurre parola per parola ben 6.882 pagine dei benchmark MMLU e GSM8K, sollevando interrogativi su quanto siano davvero efficaci questi test nel valutare la vera potenza di un modello.

MMLU è un benchmark sintetico creato per testare le capacità multitasking dei modelli, mentre GSM8K è una serie di problemi matematici utilizzati per valutare la competenza dei modelli in ambito matematico. Ma se un modello è in grado di riprodurre i problemi e le soluzioni, come facciamo a sapere se davvero ha “ragionato” su quella soluzione o se semplicemente ha recitato a memoria la risposta, come un studente con una memoria fotografica?

Come avverte Vasily Morzhakov, fondatore di RemBrain, questo è un “problema davvero enorme”. Se un modello riesce a rigenerare test già visti, significa che quei test sono già stati inclusi nella fase di pre-addestramento. La capacità di un modello di memorizzare risposte senza effettivamente risolvere i problemi mette seriamente in discussione l’affidabilità di questi benchmark come indicatori delle reali capacità dell’intelligenza artificiale.

Epoch AI ha già annunciato che, per evitare ulteriori polemiche, intende implementare un “set di problemi trattenuti”, ovvero una selezione casuale di 50 domande che non saranno mai accessibili a OpenAI, in modo da garantire una valutazione più genuina. Ma, come sottolineato dallo scienziato informatico Dirk Roeckmann, la vera sfida resta creare valutazioni veramente indipendenti. Anche con sandbox neutrali, resta sempre il rischio che i dati possano essere “trapelati” da esseri umani ben intenzionati, ma non esattamente imparziali.

Il caso o3 solleva domande fondamentali sul modo in cui l’industria dell’intelligenza artificiale valuta i propri progressi. Se la trasparenza è una chimera e i finanziamenti si mescolano con i test, come possiamo davvero fidarci dei numeri che ci vengono presentati come la “prova” di una capacità sovrumana?

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale: iscriviti alla nostra newsletter gratuita e accedi ai contenuti esclusivi di Rivista.AI direttamente nella tua casella di posta!