Nel panorama odierno, le aziende stanno cercando costantemente soluzioni innovative che possano ottimizzare i loro processi, migliorare l’efficienza e rispondere in modo più personalizzato alle esigenze dei clienti. L’introduzione di sistemi di intelligenza artificiale conversazionale (AI Conversazionale) rappresenta una delle soluzioni più promettenti in questo contesto.

Con questo studio gli autori: Nunzio Fiore (He/Him) Fabio Lecca Mario Sebastiani Alessandro Gabrielli Massimo Chiriatti, propongono una roadmap metodologica per le aziende che desiderano implementare soluzioni di AI conversazionale.

Questo articolo esplorerà un recente progetto di ricerca congiunto tra Memori, Lenovo e Araneum, focalizzandosi sull’autonomia delle soluzioni AI conversazionali on-premise.

La metodologia si concentra su vari aspetti cruciali per l’adozione e l’integrazione dell’AI conversazionale, mirata a garantire che le aziende possano operare in modo autonomo, sicuro e altamente performante. Vediamo in dettaglio i principali punti trattati.

Uno degli aspetti principali di questo framework riguarda l‘ottimizzazione delle performance dei modelli AI conversazionali. Le aziende che implementano soluzioni AI devono affrontare il problema di come massimizzare l’efficienza e la qualità delle risposte. L’identificazione dei giusti pattern di ottimizzazione aiuta le imprese a ottenere prestazioni migliori, riducendo al minimo l’uso di risorse computazionali. L’analisi dei dati interni, unita alla capacità di apprendimento continuo delle piattaforme AI, consente di affinare nel tempo il modello, garantendo risposte sempre più precise e pertinenti.

L’introduzione di sistemi AI conversazionali a livello enterprise deve essere scalabile. Le soluzioni devono poter crescere man mano che l’azienda si espande, sia in termini di volume di utenti che di complessità delle richieste. Il framework propone metodologie pratiche per implementare soluzioni conversazionali che possano facilmente adattarsi ai cambiamenti e alla crescita. Ciò significa che i sistemi devono essere modulari, flessibili e facilmente integrabili con altri strumenti aziendali già esistenti, in modo che non diventino un ostacolo ma un valore aggiunto per l’organizzazione.

Un altro punto cardine di questo studio è il bilanciamento tra la qualità delle risposte e l’efficienza computazionale. Le aziende si trovano spesso a dover decidere se focalizzarsi sulla qualità, che può richiedere risorse computazionali elevate, o sull’efficienza, che potrebbe ridurre la precisione delle risposte. La metodologia proposta aiuta a trovare un equilibrio, adottando tecniche che permettano di ottenere risposte di alta qualità senza compromettere troppo le risorse. Questo equilibrio è fondamentale per garantire che i sistemi conversazionali possano operare in modo continuo e senza interruzioni.

Il framework metodologico include la creazione di un processo decisionale strategico che consenta alle aziende di selezionare i modelli AI più adatti alle loro necessità specifiche. Non esiste una soluzione universale, e ogni azienda ha esigenze particolari che vanno considerate prima di adottare una tecnologia. Questo framework aiuta le imprese a scegliere tra i vari modelli di AI conversazionale disponibili, tenendo conto delle caratteristiche e delle necessità aziendali, delle risorse disponibili e degli obiettivi strategici.

L’intelligenza artificiale (AI) conversazionale sta rapidamente trasformando il modo in cui le aziende interagiscono con i propri clienti e gestiscono le operazioni interne. Con l’emergere di modelli di linguaggio di grandi dimensioni (LLM), le organizzazioni hanno l’opportunità di implementare soluzioni AI che possono comprendere e generare linguaggio naturale in modo sempre più sofisticato.

Obiettivo della Ricerca in dettaglio

Il progetto ha come obiettivo principale quello di sviluppare un framework metodologico per l’implementazione di sistemi conversazionali aziendali che possano operare in modo autonomo, mantenendo al contempo gli standard qualitativi dei servizi cloud. La ricerca si concentra su diversi aspetti chiave:

- Ottimizzazione delle Performance: Identificazione di pattern per massimizzare l’efficienza dei modelli locali.

- Metodologie Scalabili: Definizione di strategie per implementare sistemi conversazionali in modo scalabile.

- Equilibrio tra Qualità e Efficienza: Sviluppo di strategie per bilanciare la qualità delle risposte con l’efficienza computazionale.

- Framework Decisionali: Creazione di linee guida per la selezione dei modelli più adatti alle specifiche esigenze aziendali.

Il Ruolo del Server Lenovo

Il server utilizzato per i test è stato progettato con hardware ad alte prestazioni. Le specifiche includono:

- Processore: 2 × AMD EPYC 9654 96-Core Processor.

- Memoria RAM: 1.5 TB distribuita su 24 moduli DDR5.

- Storage: SSD NVMe PCIe 4.0 ad alta capacità.

- GPU: 4 × NVIDIA L40S, ottimizzate per carichi AI intensivi.

Questa configurazione ha permesso un’analisi approfondita delle capacità dei modelli LLM, evidenziando la necessità di un’infrastruttura scalabile per gestire carichi computazionali elevati.

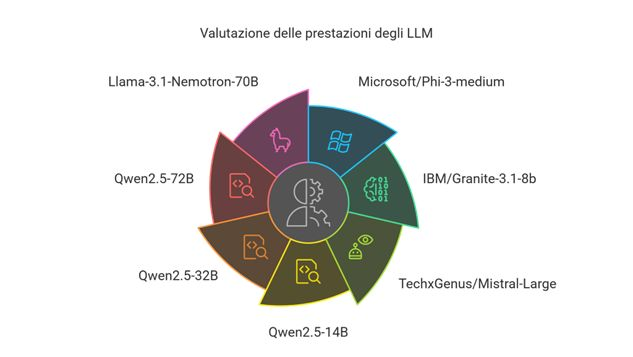

Modelli di Linguaggio Testati

Durante la ricerca sono stati testati vari modelli LLM, tra cui:

| Modello | Azienda | Dimensione | Finestra di Contesto | Memoria Occupata |

|---|---|---|---|---|

| gemma-2b | 2B | 8k | ~1.6 GB | |

| Llama-3.1-405B-FP8 | Meta-Llama | 405B | 128k | ~243 GB |

| Mistral-Large-Instruct-2411 | Mistral | 123B | 128k | ~56 GB |

Questi modelli sono stati valutati in base alla loro capacità di gestire richieste complesse e operare in ambienti multiutente.

Valutazione delle Prestazioni

Per valutare la qualità delle risposte fornite dai modelli, è stata implementata una metodologia qualitativa che ha coinvolto test su diversi assistenti virtuali. Le risposte sono state analizzate secondo una scala da 0 a 5, dove:

- 0: Risposta non valida.

- 5: Risposta pienamente coerente e completa.

I risultati hanno mostrato che i modelli con un maggior numero di parametri tendono a fornire risposte migliori, confermando l’importanza della dimensione del modello nella qualità delle interazioni.

Questo progetto rappresenta un passo significativo verso l’autonomia delle soluzioni AI conversazionali on-premise. Le aziende possono trarre vantaggio dall’implementazione di questi sistemi, garantendo privacy e controllo senza compromettere la qualità del servizio. Le raccomandazioni emerse dalla ricerca includono:

- Investire in infrastrutture hardware scalabili.

- Scegliere modelli LLM in base alle esigenze specifiche dell’organizzazione.

- Continuare a monitorare e ottimizzare le performance per garantire un servizio efficiente.

Il futuro dell’AI conversazionale è promettente, e le collaborazioni come quella tra Memori, Lenovo e Araneum sono fondamentali per guidare l’innovazione in questo campo.

Grazie e buona lettura dell’allegato.