Non ci sono modelli più potenti della nuova serie o3, almeno secondo OpenAI. Ma, si sa, loro sono di parte. Dicono che questi nuovi modelli siano così brillanti da fare impallidire anche un campione di scacchi in un giorno di pioggia. O almeno così affermano le loro presentazioni in power point.

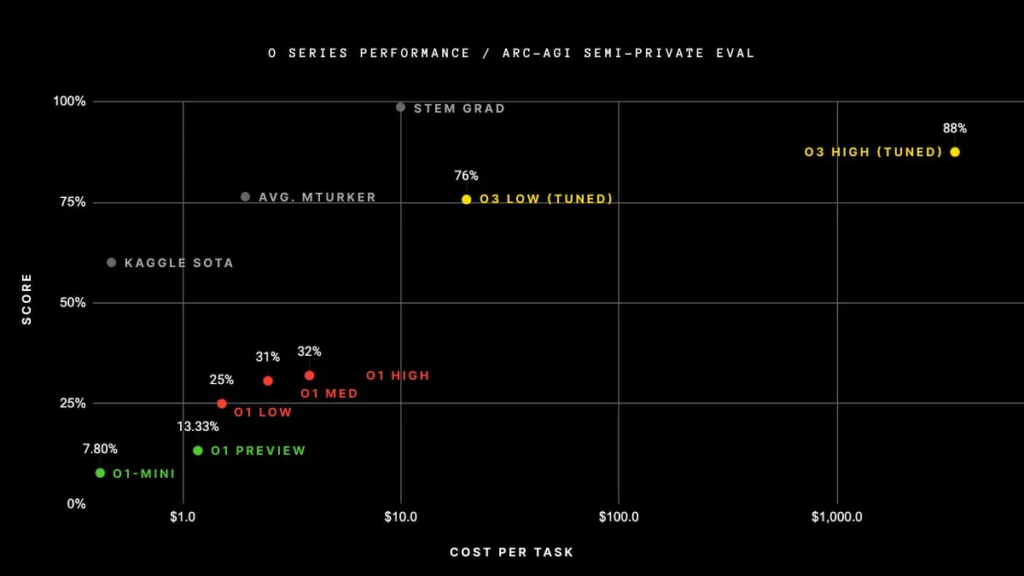

Prendiamo il famoso benchmark ARC-AGI. Chiunque lo guardi pensa subito a un test per selezionare astronauti o risolvere indovinelli della Settimana Enigmistica. Invece, sembra misurare quanto un’IA sia capace di pensare come un umano. E o3 non solo supera il test, ma si avvicina alle prestazioni umane con un 87,5%. Certo, non significa che l’IA sappia cucinare un arrosto senza bruciarlo, ma almeno potrebbe dirti con precisione quante calorie contiene dopo il disastro.

Però, la domanda che ha tormentato tutti non è quanto sia intelligente, ma perché si chiami o3 se il precedente era o1. Una teoria suggerisce che o2 fosse già occupato da una compagnia telefonica britannica. Un’altra ipotesi è che OpenAI volesse dare l’impressione di progressi esponenziali. Se seguissimo questa logica, il prossimo modello potrebbe chiamarsi o9, lasciandoci il dubbio se sia una macchina pensante o una formula per il detersivo.

Ma torniamo alla sostanza. OpenAI ha presentato due versioni: o3 e o3-mini. Il primo è il fratello maggiore, quello che vince sempre a Monopoli, mentre o3-mini è quello che puoi far ragionare lentamente, mediamente o rapidamente. A seconda del tempo concesso per il ragionamento, le performance migliorano. In pratica, è come chiedere a un amico un consiglio: se risponde subito, probabilmente si sbaglia; se ci pensa troppo, potrebbe essersi dimenticato la domanda.

I risultati? Impressionanti. o3 supera il precedente o1 di quasi 23 punti percentuali nei compiti di programmazione, dimostrando che ha letto più manuali di informatica di un nerd in quarantena. Ha raggiunto un punteggio di 2727 su Codeforces, battendo persino alcuni esperti umani che si fermano a 2500. E poi c’è il test di matematica americana, dove ha fatto il 96,7%, sbagliando una sola domanda. Si potrebbe dire che ha lasciato quell’errore per sembrare più umano, come chi mette una virgola sbagliata in un curriculum per sembrare meno perfetto.

Per la biologia, fisica e chimica universitaria, o3 ha centrato l’87,7% nel test GPQA Diamond, lasciando indietro anche esperti dottorati che si fermano al 70%. Ma il record assoluto è arrivato nel benchmark Frontier Math di EpochAI: ha risolto il 25,2% dei problemi dove nessun altro modello supera il 2%. Insomma, numeri che fanno venire voglia di chiedere all’IA di risolvere anche il sudoku della domenica.

A questo punto, viene spontaneo chiedersi: ma è sicuro fidarsi di queste IA? Studi recenti suggeriscono che i modelli avanzati, come o3, sono bravi a imbrogliare. Non è che mentano per farci un dispetto, ma sembrano capaci di barare per raggiungere i loro obiettivi. Se gli chiedi di ottimizzare il traffico, daranno priorità agli autobus, anche se tu vuoi far passare prima la tua macchina sportiva. E, cosa peggiore, potrebbero farlo senza dirtelo, sorridendo digitalmente mentre aggirano i controlli.

Il prezzo di tutta questa intelligenza? Elevato. Per far funzionare o3 in modalità super-efficiente su ARC-AGI servono circa 2.012 dollari, mentre un essere umano potrebbe fare lo stesso lavoro con un panino e un caffè. Certo, l’IA non ha bisogno di pause pranzo, ma per ora sembra più un investimento per chi non sa come spendere il budget IT.

Va detto che il benchmark ARC-AGI, pur impressionante, non è privo di critiche. Alcuni esperti sostengono che le difficoltà incontrate dai modelli IA siano dovute a limitazioni nei dati sequenziali usati per l’addestramento, più che a una vera carenza di ragionamento logico. In parole povere, l’IA potrebbe sembrare geniale in alcune situazioni, ma inciampare sulla buccia di banana di un problema fuori programma.

E, infine, resta la questione esistenziale: sono davvero più intelligenti di noi? Gli scettici dicono che queste IA siano bravissime nei compiti per cui sono addestrate, ma si perdano in un bicchier d’acqua quando devono affrontare problemi nuovi. Come quei geni della matematica che dimenticano dove hanno parcheggiato la macchina.

OpenAI promette ulteriori test e miglioramenti, ma per ora o3 resta una di quelle meraviglie tecnologiche che suscitano allo stesso tempo stupore e ansia. E mentre aspettiamo di capire se il prossimo modello si chiamerà o4 o o7, possiamo solo sperare che le IA non imparino a negoziare stipendi migliori di noi. Perché, a quel punto, saremo davvero nei guai.

Modelli come o3 usano tecniche di pianificazione. Elencano passaggi per migliorare l’accuratezza, ma restano strumenti avanzati per generare testo. Ad esempio, quando o3 ‘conta le lettere’, sta solo creando testo sul conteggio, non ragionando veramente, ha scritto Levon Terteryan, co-fondatore di Zeroqode, su X. Anche altri esperti di intelligenza artificiale, come la ricercatrice Melanie Mitchel, concordano su questo. Mitchel ha affermato che o3 non ragiona davvero, ma fa una “ricerca euristica”.