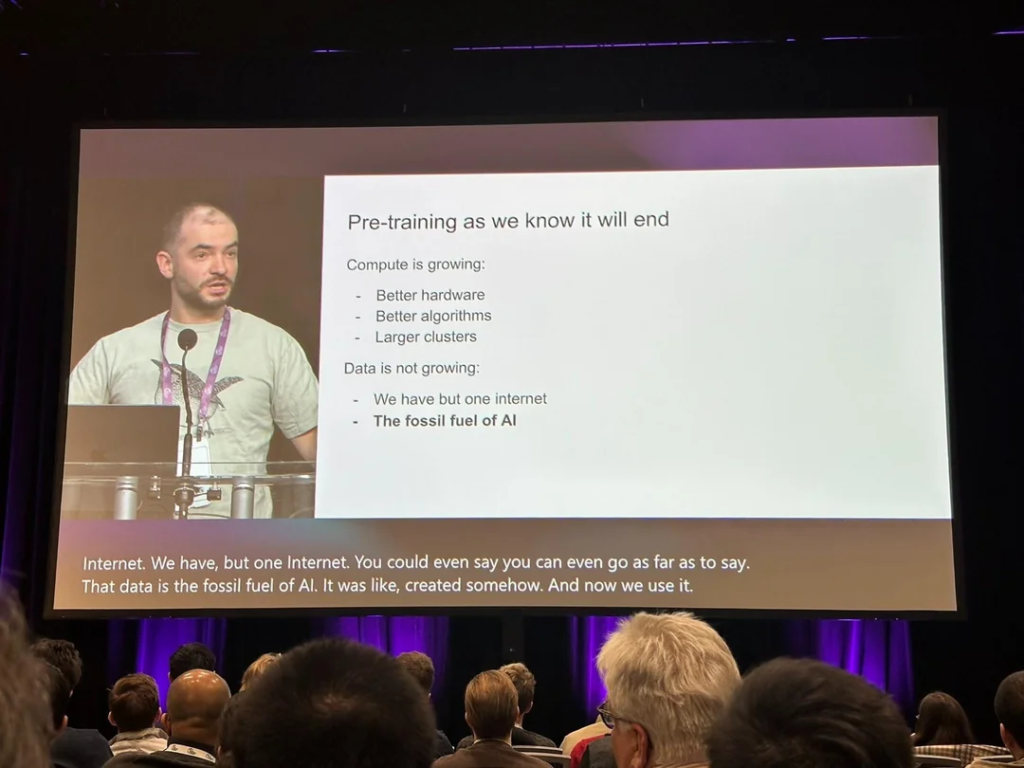

Ilya Sutskever, cofondatore di OpenAI e ora a capo del suo nuovo laboratorio Safe Superintelligence Inc., ha recentemente catturato l’attenzione della comunità scientifica durante la sua apparizione al prestigioso evento NeurIPS a Vancouver. La sua affermazione che il “pre-training come lo conosciamo finirà” segna una svolta epocale nel panorama dell’intelligenza artificiale (IA).

Il pre-training è il processo iniziale attraverso cui i modelli di linguaggio apprendono dai dati disponibili su internet, dai libri e da altre fonti non etichettate. Tuttavia, secondo Sutskever, l’industria ha raggiunto un limite insormontabile: il “picco dei dati”. Paragonando questa situazione alla dipendenza globale dai combustibili fossili, ha sottolineato che la quantità di contenuti generati dagli esseri umani è finita e non può essere aumentata. “Abbiamo una sola internet,” ha dichiarato, indicando che il futuro sviluppo dell’IA richiederà un cambiamento radicale nei metodi di addestramento.

Guardando avanti, Sutskever prevede che i modelli di prossima generazione saranno “agentici” e capaci di ragionare autonomamente. Questi sistemi supereranno l’attuale paradigma basato sul riconoscimento di schemi, evolvendosi verso un’intelligenza che opera in modo simile al pensiero umano. Questo cambiamento porterà a comportamenti imprevedibili, analoghi alle mosse sorprendenti che i migliori scacchisti umani non riescono a prevedere nei sistemi avanzati di gioco.

L’idea di un’IA che ragiona passo dopo passo implica una capacità di comprensione dai dati limitati, evitando confusione e migliorando il suo adattamento alle nuove situazioni. Sutskever ha paragonato questa evoluzione all’adattamento biologico, citando studi sulla relazione tra la massa cerebrale e corporea nelle specie animali.

L’Infinita Corsa ai Dati: Tra Crescita Esponenziale e Limiti Tecnologici

L’evoluzione dei dati sul web sta raggiungendo livelli mai visti, alimentata dalla proliferazione di contenuti generati dagli utenti, piattaforme di comunicazione e archivi scientifici digitali. Tuttavia, questa crescita presenta sfide complesse per l’intelligenza artificiale, che dipende dalla qualità e dalla varietà dei dati disponibili per il training.

Mentre alcuni sostengono che i dati continuino a crescere esponenzialmente, le limitazioni tecniche legate al consumo energetico e alla capacità computazionale stanno emergendo come ostacoli significativi. Con l’esaurimento della legge di Moore, il costo energetico per il funzionamento dei data center richiede soluzioni come l’energia nucleare, mentre la gestione del calore prodotto dai supercomputer diventa un problema critico.

Parallelamente, la qualità e la diversità dei dati rappresentano una sfida ulteriore. I contenuti autentici creati dagli esseri umani sono sempre più diluiti in un mare di informazioni generate automaticamente. Questo fenomeno potrebbe ridurre la capacità delle AI di imparare da dati rappresentativi e significativi.

Le piattaforme di messaggistica privata e i dati sensoriali rappresentano nuove fonti di informazioni, ma il loro accesso è spesso limitato da considerazioni etiche e legali. Tuttavia, il panorama non è del tutto desolante. Le aziende stanno investendo massicciamente nella creazione di dataset curati e specifici, spesso attraverso task svolti manualmente da esperti. Questo approccio potrebbe mitigare il declino qualitativo delle informazioni pubbliche disponibili.

Infine, il futuro dell’IA non sarà esclusivamente basato su testi o modelli di linguaggio. I dati provenienti da sensori, immagini, video e persino archivi scientifici storici offrono opportunità immense. La sfida sarà integrare queste fonti in modo responsabile, garantendo trasparenza, rispetto della privacy e mitigazione dei bias.

La corsa ai dati non è solo una questione di quantità, ma di significato, qualità e applicazione etica. Il futuro promette innovazioni incredibili, ma richiederà anche soluzioni ingegnose per affrontare i limiti tecnici e morali che emergono all’orizzonte.