Amazon Web Services ha avviato la sua annuale conferenza re:Invent con una serie di annunci destinati a consolidare la sua posizione di leader nell’AI e nel cloud computing. L’obiettivo è chiaro: spostare l’ago della bilancia tecnologica, consolidando l’adozione dell’intelligenza artificiale e aprendo nuove frontiere per i clienti aziendali e sviluppatori.

AWS ha messo in evidenza i suoi progressi nella generative AI, con servizi come Bedrock, che semplifica l’adozione dell’intelligenza artificiale nelle aziende. Bedrock è cresciuto rapidamente grazie alla capacità di integrare diversi modelli di intelligenza artificiale attraverso un’unica API, permettendo alle imprese di scegliere i modelli più adatti ai loro bisogni. Con oltre 326 funzionalità AI lanciate dal 2023, AWS sta puntando su un approccio full-stack, che copre infrastruttura, middleware e applicazioni intelligenti.

Prodotti come Amazon Q, destinati all’automazione aziendale, e la piattaforma AWS App Studio, progettata per sviluppare applicazioni AI con un approccio low-code, dimostrano l’impegno dell’azienda nel rendere l’AI accessibile e utile a tutti i livelli aziendali.

Una spinta verso l’efficienza e la scalabilità

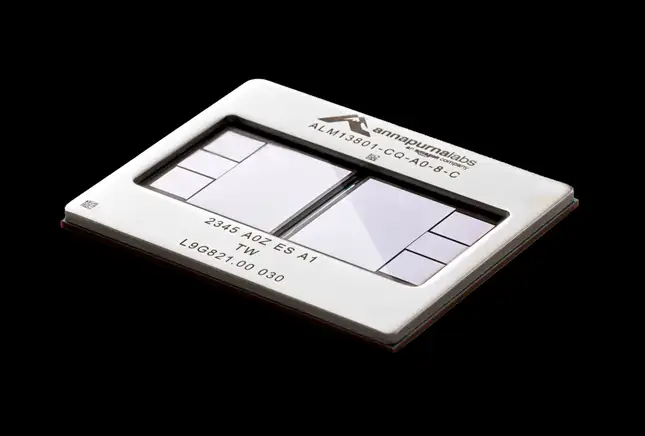

Amazon ha svelato il chip Trainium3, la nuova generazione di processori dedicati al machine learning, progettati per superare i limiti delle prestazioni e della scalabilità nell’intelligenza artificiale. In parallelo, l’azienda ha annunciato la costruzione di Trainium2 UltraCluster, un’infrastruttura su larga scala sviluppata in collaborazione con Anthropic, uno dei leader emergenti nel campo dell’AI avanzata.

Trainium3: Prestazioni e Efficienza per il Deep Learning

Il Trainium3 rappresenta un salto evolutivo rispetto alla precedente generazione, offrendo una potenza computazionale significativamente maggiore e un’efficienza energetica ottimizzata. Questo chip è progettato per gestire modelli di machine learning di dimensioni crescenti, come quelli utilizzati nei transformer e nei modelli generativi, che richiedono enormi risorse computazionali.

Caratteristiche principali del Trainium3:

- Incremento delle prestazioni: Maggiore velocità nell’addestramento e nell’inferenza rispetto al Trainium2.

- Efficienza energetica: Consumi ridotti grazie a innovazioni nell’architettura.

- Scalabilità: Ottimizzato per lavorare in cluster massivi, consentendo di gestire modelli AI di ultima generazione.

Trainium2 UltraCluster: L’Infrastruttura per l’AI su Larga Scala

Trainium2 UltraCluster rappresenta l’evoluzione delle infrastrutture di calcolo ad alta densità, costruite specificamente per supportare modelli AI avanzati. La collaborazione con Anthropic dimostra l’intenzione di Amazon di posizionarsi al centro dell’ecosistema AI globale.

Punti salienti dell’UltraCluster:

- Potenza aggregata: Migliaia di chip Trainium2 collegati per creare un’infrastruttura che può addestrare modelli AI con trilioni di parametri.

- Collaborazione con Anthropic: L’integrazione delle competenze di Anthropic nel design e nella gestione dei modelli garantisce un sistema altamente ottimizzato per sviluppare intelligenze artificiali responsabili e scalabili.

- Accesso su AWS: Trainium2 UltraCluster sarà reso disponibile tramite AWS, permettendo a ricercatori e aziende di accedere a una delle infrastrutture più potenti al mondo.

Con queste innovazioni, Amazon non solo accelera lo sviluppo dei modelli di machine learning, ma rafforza anche la propria posizione nel mercato dei servizi cloud, dove AWS è già un leader consolidato. La collaborazione con Anthropic suggerisce un approccio strategico volto a integrare hardware e software per creare soluzioni end-to-end che soddisfino le esigenze di settori come la sanità, la finanza, e l’intrattenimento.

Il Trainium3 e l’UltraCluster promettono di ridurre significativamente i tempi di addestramento e i costi operativi per le organizzazioni che puntano sull’AI, aprendo nuove opportunità per applicazioni come il natural language processing, la visione artificiale e i sistemi predittivi.