Un esperimento che ha simulato oltre 1000 persone reali utilizzando il modello di intelligenza artificiale dietro a ChatGPT ha avuto successo nel replicare con alta precisione i pensieri e le personalità uniche di questi individui, suscitando preoccupazioni etiche su come possano essere imitati gli esseri umani in questo modo. L’iniziativa, guidata da Joon Sung Park della Stanford University, in California, ha cercato di utilizzare gli strumenti di intelligenza artificiale generativa per modellare gli individui come un metodo per prevedere l’impatto di cambiamenti nelle politiche. Tradizionalmente, tentativi simili erano stati condotti utilizzando modelli statistici basati su regole, con risultati spesso limitati e poco realistici.

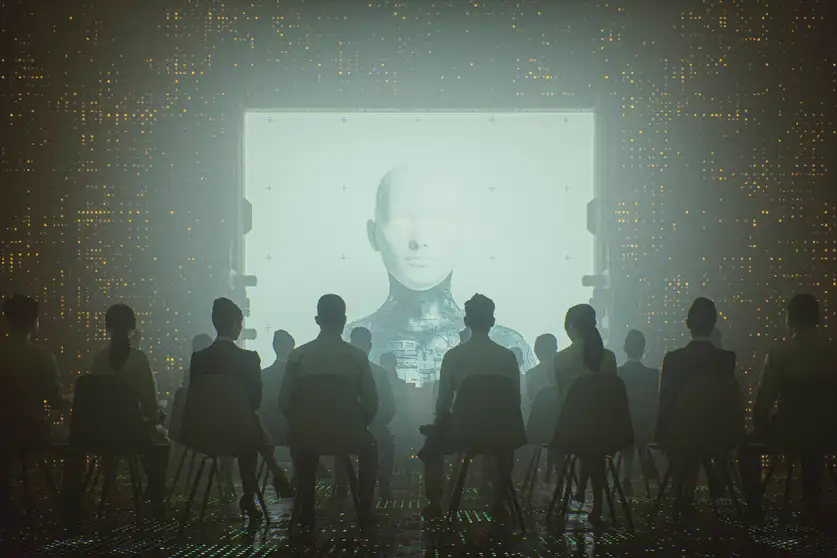

Un Esperimento su Più di 1000 Persone Reali e la Creazione di Personalità Artificiali: Un Passo Avanti o una Minaccia Etica?

L’innovativo approccio dell’équipe di Park ha sfruttato la potenza dei modelli di linguaggio avanzati, come quelli sviluppati da OpenAI, per replicare non solo le opinioni espresse, ma anche la complessità e la varietà delle risposte individuali, riflettendo così in modo più accurato i pensieri, le emozioni e le preferenze delle persone. In sostanza, gli scienziati sono riusciti a “mimare” la personalità e i comportamenti dei partecipanti all’esperimento, portando a interrogativi cruciali sull’uso delle tecnologie AI nel trattamento delle identità individuali.

La Riproduzione delle Identità Umane attraverso l’Intelligenza Artificiale

Tradizionalmente, le simulazioni di comportamento umano in contesti di previsione sociale ed economica si sono affidate a modelli statistici relativamente semplicistici. Questi tentativi, sebbene utili in alcuni ambiti, non erano in grado di catturare la complessità dei comportamenti individuali, limitandosi spesso a rappresentazioni generalizzate o stereotipate delle persone. L’introduzione dei modelli di linguaggio avanzati ha cambiato radicalmente questo scenario, permettendo una rappresentazione molto più ricca e dettagliata degli individui.

Il modello AI utilizzato nel progetto di Park ha mostrato di poter replicare con una sorprendente precisione le sfumature della personalità e dei pensieri individuali, raccogliendo enormi volumi di dati e utilizzandoli per generare risposte simili a quelle che una persona reale potrebbe dare in una conversazione. Questo è stato possibile grazie all’addestramento del modello su un vasto insieme di dati che comprendeva non solo opinioni, ma anche emozioni, atteggiamenti e inclinazioni cognitive, permettendo così di costruire una “personalità digitale” che rispecchia quella dell’individuo reale.

Implicazioni Etiche della Mimicry Personale

Sebbene i risultati di questo esperimento siano impressionanti dal punto di vista tecnologico, le implicazioni etiche sollevano preoccupazioni significative. La capacità di replicare con così alta precisione i pensieri e le emozioni di una persona solleva interrogativi sul consenso e sul controllo che gli individui potrebbero avere su queste versioni digitali delle loro personalità. Inoltre, la possibilità di utilizzare questi modelli per prevedere comportamenti o prendere decisioni politiche potrebbe avere un impatto diretto sulla privacy e sull’autonomia delle persone.

Uno dei principali rischi etici riguarda l’uso delle simulazioni AI per scopi manipolativi. Se i governi o le organizzazioni private possono riprodurre e manipolare le opinioni individuali con un grado di precisione così elevato, potrebbero influenzare la formazione di opinioni pubbliche o decisioni politiche in modo più sottile ma estremamente potente. Ciò potrebbe portare a una distorsione della democrazia e a una gestione dei dati delle persone che va ben oltre l’immaginazione di un sistema di sorveglianza tradizionale.

Un altro aspetto problematico è la questione della privacy. Anche se i dati utilizzati per allenare i modelli sono anonimizzati, la capacità di ricreare personalità digitali potrebbe comportare il rischio che una persona venga “replicata” senza il suo consenso esplicito, facendo sì che una versione artificiale della sua identità venga usata in contesti in cui potrebbe non essere appropriato o desiderato. Questo potrebbe minare il concetto stesso di identità personale e di controllo sui propri dati.

Il Futuro delle Politiche Sociali e l’Intelligenza Artificiale

Il progetto di Stanford si inserisce in un contesto più ampio di utilizzo dell’AI per modellare la società e migliorare le politiche pubbliche. L’idea di prevedere gli effetti delle politiche sociali ed economiche attraverso simulazioni basate su modelli AI potrebbe rivoluzionare la pianificazione e l’implementazione di politiche. Tuttavia, affinché questi strumenti siano utilizzati in modo etico e responsabile, è necessario sviluppare linee guida chiare e rigide per garantire che il modello rispetti i diritti e la dignità degli individui.

Al di là delle preoccupazioni etiche, l’applicazione di intelligenza artificiale generativa in ambito politico potrebbe aprire nuove porte per la gestione delle crisi o per la comprensione delle dinamiche sociali, ma solo se verranno stabiliti dei principi di trasparenza, responsabilità e consenso. La sfida sarà quella di bilanciare le opportunità offerte da questi potenti strumenti con la protezione dei diritti fondamentali delle persone.