La decisione di Richard Ngo di lasciare OpenAI rappresenta un ulteriore tassello nella crescente serie di dimissioni di figure chiave dal settore della sicurezza interna all’azienda, mettendo in luce una preoccupante dissonanza tra la missione dichiarata di OpenAI e le sue recenti scelte operative. Ngo, noto ricercatore nel campo della governance dell’IA e co-autore di studi fondamentali sul problema dell’allineamento dell’IA, ha spiegato le sue dimissioni come una scelta maturata gradualmente a fronte di “domande senza risposta” su come OpenAI stia perseguendo la propria missione di “fare sì che l’AGI vada bene” (go well).

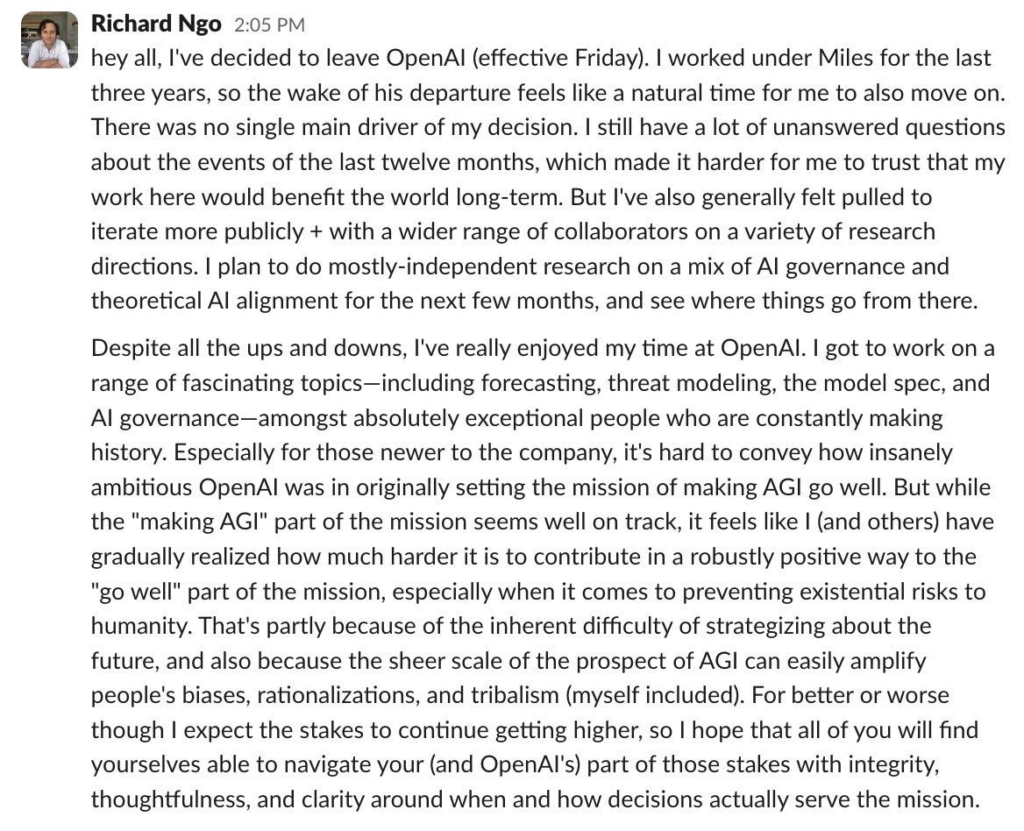

In un messaggio ai suoi colleghi, Ngo ha manifestato dubbi profondi sul valore a lungo termine del suo contributo alla missione di OpenAI, specialmente alla luce degli sviluppi degli ultimi dodici mesi. Questi timori sembrano rispecchiare un clima aziendale in cui, come molti dipendenti prima di lui hanno già sottolineato, gli aspetti di sicurezza e le procedure di allineamento sono spesso trascurati a favore del rilascio di nuovi prodotti e funzionalità.

Un’Emorragia di Talenti nella Sicurezza dell’IA

Ngo non è il solo ad avere dubbi sul futuro dell’azienda in termini di sicurezza. Nel corso dell’ultimo anno, OpenAI ha visto la partenza di altre figure chiave nella gestione dei rischi dell’IA. Tra questi Lilian Weng, VP della ricerca e della sicurezza, e Miles Brundage, consulente senior per la prontezza dell’AGI. Entrambi sono stati accompagnati da un crescente numero di esperti, come Ilya Sutskever e Jan Leike, che hanno lasciato per preoccupazioni simili riguardanti una cultura della sicurezza che, secondo loro, avrebbe “ceduto il passo a prodotti scintillanti”.

La crescente lista di dimissioni di dipendenti orientati alla sicurezza suggerisce che a OpenAI possa mancare una chiara strategia per integrare gli obiettivi di sicurezza e allineamento con la sua visione di innovazione. Se l’azienda è oggi percepita come disallineata rispetto alla sua stessa missione di rendere l’AGI un bene per l’umanità, le dimissioni di Ngo e di altri possono considerarsi una conferma della necessità di un ripensamento strategico.

Ngo e l’Allineamento dell’IA: Un Percorso Fondamentale per la Sicurezza

Richard Ngo è una figura di grande rilievo nella comunità della sicurezza dell’IA, non solo per i suoi contributi scientifici, ma anche per la sua influenza sulla consapevolezza pubblica riguardo ai rischi dell’intelligenza artificiale. Il suo lavoro si concentra sulla “governance dell’IA” e sull’allineamento, ossia sullo sviluppo di sistemi che mantengano obiettivi e comportamenti compatibili con gli interessi umani. Questo approccio è sempre più centrale, dato che i modelli di intelligenza artificiale avanzano verso livelli di autonomia e capacità di apprendimento superiore. Ngo, in un periodo in cui la sicurezza e l’allineamento dell’IA sono diventati argomenti di massima importanza globale, lascia un vuoto che potrebbe essere difficile da colmare.

La decisione di Ngo di dedicarsi a progetti di ricerca indipendenti incentrati sulla governance e l’allineamento dell’IA è una scelta che probabilmente riflette il suo desiderio di lavorare in un contesto che dia maggiore priorità alla sicurezza rispetto al ritmo del mercato. Sebbene abbia parlato positivamente della sua esperienza a OpenAI, la sua nota di commiato mette in evidenza la necessità di “integrità, riflessione e chiarezza” nelle decisioni dell’azienda per poter raggiungere l’obiettivo dichiarato di rendere l’AGI un bene comune.

OpenAI: la Sfida di un Equilibrio tra Innovazione e Sicurezza

Le dimissioni di Ngo, e prima di lui di numerosi altri esperti, pongono un dilemma chiave per OpenAI: come bilanciare la pressione verso la crescita e l’innovazione con l’imperativo etico della sicurezza e dell’allineamento? Mentre la domanda di applicazioni di intelligenza artificiale cresce e il mercato spinge per soluzioni sempre più potenti e avanzate, OpenAI sembra essere di fronte a una scelta critica.

Se la cultura della sicurezza continua a “passare in secondo piano”, come ha detto Leike, l’azienda potrebbe perdere non solo la fiducia dei suoi esperti interni, ma anche quella del pubblico e delle istituzioni che monitorano l’evoluzione dell’IA avanzata. Ngo, con la sua uscita, ha dato voce a molti dubbi che circolano nel settore e che potrebbero diventare una sfida crescente per OpenAI e le altre aziende che operano in ambiti simili.