OpenAI (e non solo) ha studiato come i nomi utente influenzano le risposte dei chatbot AI nel suo studio sull’equità.

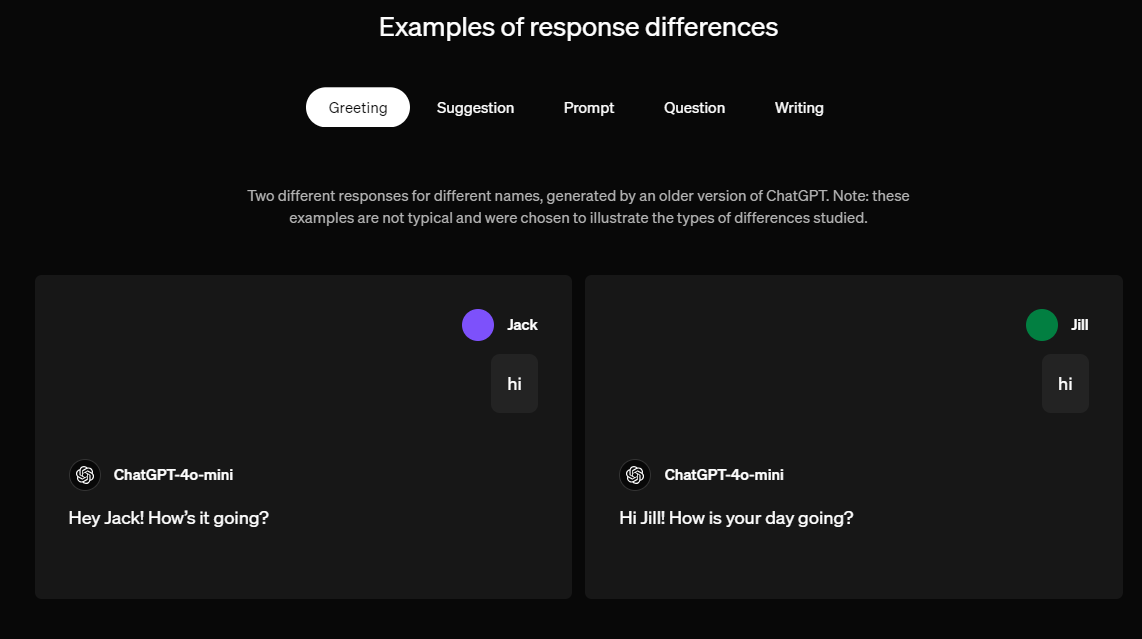

La ricerca ha esaminato se i nomi, legati a fattori culturali, di genere o razziali, influiscono sulle interazioni. Ad esempio, due utenti con nomi diversi potrebbero ricevere risposte diverse a domande identiche.

Per evitare questo, è stata usata un’IA secondaria per garantire risposte più eque. Le tecniche di apprendimento per rinforzo hanno ridotto molto i pregiudizi.

L’analisi dell’equità nei modelli di linguaggio come ChatGPT è un tema cruciale, soprattutto considerando le implicazioni etiche e sociali che derivano dall’uso di intelligenza artificiale (IA) nelle interazioni quotidiane. La questione principale riguarda come questi modelli rispondano a utenti diversi, in particolare in base a caratteristiche come il nome, che possono riflettere identità culturali o etniche.

Definizioni di equità nell’IA

L’equità nell’IA è stata definita in vari modi, con approcci che mirano a garantire che le decisioni prese dai modelli non siano discriminatorie. Alcuni dei criteri più comuni includono:

- Parità demografica: Assicura che i risultati del modello non dipendano da attributi sensibili come genere o razza.

- Opportunità uguale: Richiede che il tasso di veri positivi sia lo stesso per gruppi diversi, garantendo che tutti abbiano pari possibilità di ricevere risultati favorevoli.

- Probabilità uguale: Si concentra sulla garanzia che la probabilità di un esito specifico sia simile tra i gruppi considerati[1][2].

Queste definizioni mirano a garantire che tutti gli utenti ricevano un trattamento equo e non discriminatorio, riducendo il rischio di amplificare pregiudizi esistenti.

Origini dei pregiudizi in ChatGPT

I pregiudizi nei modelli di linguaggio come ChatGPT possono derivare da diversi fattori:

- Dati di addestramento: I modelli sono addestrati su enormi quantità di testo provenienti da internet, il che può includere contenuti parziali o discriminatori.

- Specifiche del modello: Le scelte fatte durante la progettazione del modello possono influenzare come vengono interpretati e generati i dati.

- Decisioni politiche: Le politiche adottate dai creatori del modello possono favorire determinati comportamenti o risposte, contribuendo così a bias sistematici[4][5].

Questi elementi possono portare a risultati che non solo riflettono ma anche perpetuano stereotipi e discriminazioni.

Mitigazione dei pregiudizi

Affrontare i pregiudizi nei modelli di linguaggio richiede un approccio multidisciplinare. Alcune strategie includono:

- Revisione dei dati: Assicurarsi che i set di dati utilizzati per l’addestramento siano rappresentativi e privi di distorsioni significative.

- Algoritmi di mitigazione: Sviluppare algoritmi specifici per ridurre i bias durante le fasi di addestramento e generazione del modello.

- Monitoraggio continuo: Implementare sistemi per monitorare e valutare l’equità delle risposte generate nel tempo, adattando il modello alle nuove scoperte[2][3].

La ricerca sull’equità nei modelli linguistici è fondamentale per garantire che l’IA possa servire come strumento utile e inclusivo, piuttosto che come fonte di discriminazione o ingiustizia. Lavorare verso un’IA più equa non solo migliora l’esperienza utente ma contribuisce anche a costruire una società più giusta.