HPE ha presentato le basi per calcolo e connettività per i prossimi investimenti nell’IA durante l’AI Day. L’obiettivo era mostrare tutte le capacità che HPE offre alle imprese per i data center, sia on-premise che nel cloud. Questo include la nuova tecnologia di raffreddamento a liquido diretto senza ventole di HPE e la sua rete di interconnessione tra GPU e CPU.

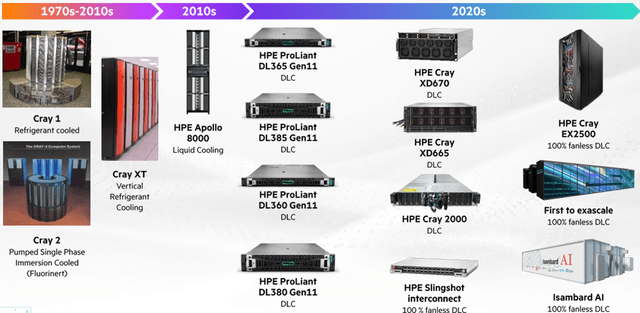

HPE ha introdotto i nuovi sistemi di raffreddamento a liquido, progettati per soddisfare le esigenze dell’IA ad alte prestazioni.

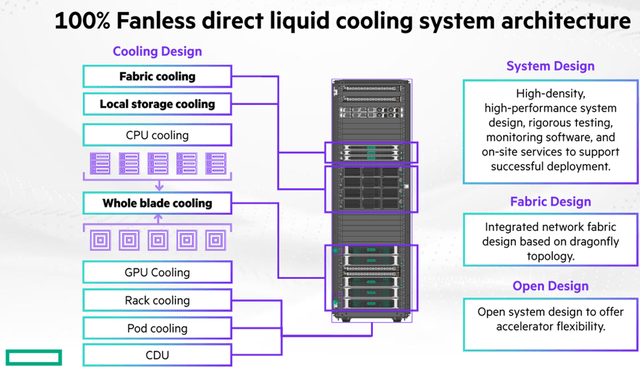

“Questa architettura di raffreddamento a liquido diretto comporta una riduzione del 90% nel consumo di energia per il raffreddamento rispetto ai sistemi tradizionali raffreddati ad aria.”, Antonio Neri, Presidente e CEO, HPE

Con il crescente bisogno di server, migliorare le capacità di raffreddamento è essenziale. Nel 2017, i server operavano con 330 watt di potenza, mentre oggi superano i 10KW e si prevede che questa cifra raddoppi entro il 2025. In un data center con 10.000 server, la domanda di energia arriva a 100MW, con il raffreddamento ad aria che consuma ulteriori 80MW. Il nuovo sistema di raffreddamento a liquido diretto senza ventole di HPE richiede solo il 10% della potenza rispetto al raffreddamento ad aria.

Guardando al futuro, data center come quelli di Oracle Corporation, che raggiungeranno oltre 1GW, beneficeranno significativamente di questo sistema.

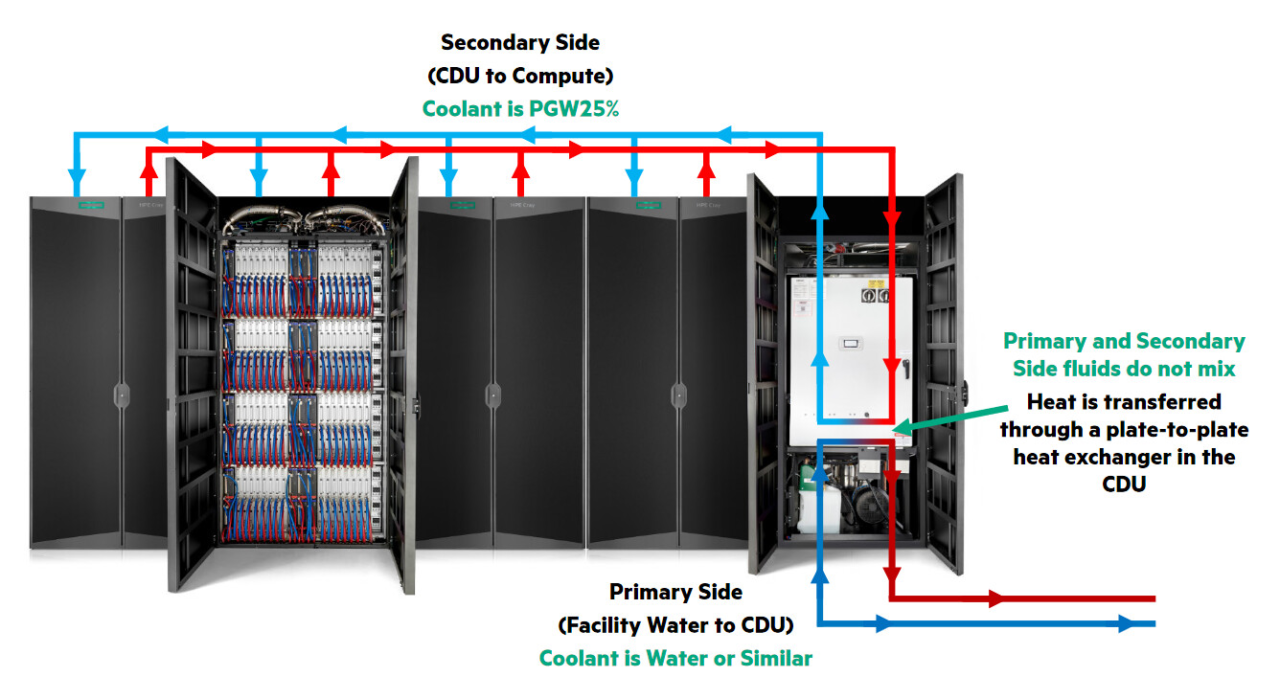

Il DLC senza ventole permette al refrigerante di fluire attraverso tubi e piastre fredde, estraendo calore direttamente da tutti i componenti del rack del server, inclusi CPU, GPU, archiviazione e rete.

HPE ha fornito dettagli sulla prossima generazione di connettività di rete nei data center, migliorando le prestazioni per le applicazioni AI.

La rete può presentare sfide per le aziende poiché dispositivi, applicazioni, dati e sicurezza devono essere considerati per una connettività ottimale. Con le acquisizioni di Aruba e Juniper,

HPE ha ampliato le sue capacità di rete e sicurezza, offrendo una connettività AI-native per l’addestramento e l’inferenza AI. Questa soluzione integrata permette a HPE di offrire ai clienti uno stack di rete sicuro. Tutto questo supporta l’iniziativa globale di HPE, Green Lake.

HPE lancerà il suo cloud privato AI in sette sedi Equinix a livello globale per supportare le esigenze regionali e sovrane dei data center.

HPE integrerà le GPU di Nvidia e il software AI di Nvidia nei server HPE per un’ottimale addestramento e inferenza. I clienti potranno usare questo stack tecnologico sia nei loro data center privati che nel cloud privato di HPE.

Inoltre, HPE ha collaborato con CrowdStrike per automatizzare la sicurezza su tutto lo stack. L’acquisizione di Morpheus da parte di HPE nell’agosto 2024 consente alle aziende di operare senza problemi tra data center privati e piattaforme multi-cloud.

Abbinato a OpsRamp, le aziende possono facilmente tracciare i loro asset IT e automatizzare le operazioni. La gestione ha anche menzionato l’uso interno delle funzionalità GenAI per ottimizzare le operazioni riducendo i costi.

HPE ha implementato GenAI per creare bot che svolgono attività del helpdesk, come reimpostazioni di password e analisi delle cause principali. L’azienda sta anche usando CoPilot per il team di sviluppo software per aiutare nello sviluppo, debugging e risoluzione dei rischi di sicurezza.

HPE sta distribuendo l’AI nei suoi prodotti per migliorare la sicurezza, l’analisi predittiva e la risoluzione proattiva dei problemi.

L’obiettivo per le aziende è semplificare la distribuzione delle applicazioni AI. La proposta “3 clic per distribuire” ridurrà significativamente i tempi di distribuzione. Questa distribuzione includerà la suite software Nvidia AI enterprise pronta all’uso, permettendo installazioni rapide e modulari.

Dal punto di vista dei costi, l’AI del cloud privato di HPE è fino al 75% meno costosa rispetto alle offerte del cloud pubblico.