Meta ha svelato il suo ultimo modello di linguaggio di grandi dimensioni, Llama 3.2, durante l’evento Meta Connect 2024. Questo rilascio include diverse dimensioni di modelli ottimizzati per dispositivi edge e mobili, segnando un significativo progresso nelle capacità dell’IA on-device.

Un aspetto interessante è che alcune versioni si possono installare sullo smartphone senza perdita di qualità. Questo permette di avere interazioni, app e personalizzazioni IA locali e private senza inviare dati a server esterni.

Sono in grado di svolgere compiti complessi come l’analisi di grafici, la didascalia di immagini e l’individuazione di oggetti nelle immagini basandosi su descrizioni in linguaggio naturale. Llama 3.2 è stato rilasciato la stessa settimana di Molmo dell’Allen Institute, di cui abbiamo parlato in un precedente post. Molmo si è affermato come il miglior LLM open source per la visione multimodale nei benchmark sintetici, e nei nostri test ha dimostrato prestazioni comparabili a GPT-4, Claude 3.5 Sonnet e Reka Core.

Caratteristiche Chiave di Llama 3.2

- Varianti di Modello: Llama 3.2 è disponibile in diverse configurazioni:

- Modelli Solo Testo: I modelli da 1B e 3B sono progettati per applicazioni leggere, supportando una lunghezza di contesto di 128.000 token. Questi modelli eccellono in compiti come la sintesi, il seguire istruzioni e la riscrittura direttamente sui dispositivi senza dipendere dal cloud.

- Modelli Multimodali: I modelli più grandi da 11B e 90B incorporano capacità di elaborazione delle immagini, permettendo loro di gestire compiti che richiedono comprensione sia del testo che degli input visivi.

- Elaborazione On-Device: I modelli leggeri sono specificamente ottimizzati per l’hardware Qualcomm e MediaTek, sfruttando l’architettura Arm che alimenta la stragrande maggioranza dei dispositivi mobili. Questa scelta progettuale migliora la privacy e la reattività poiché l’elaborazione avviene localmente anziché nel cloud.

- Focus per Sviluppatori: Meta sottolinea che Llama 3.2 è l’iterazione più centrata sugli sviluppatori fino ad oggi, consentendo la creazione di applicazioni personalizzate che mantengono la privacy degli utenti tenendo i dati sul dispositivo. Ad esempio, gli sviluppatori possono costruire applicazioni che riassumono messaggi o gestiscono inviti al calendario senza inviare informazioni sensibili a server esterni.

- Prestazioni e Compatibilità: I nuovi modelli sono riportati come competitivi rispetto ai modelli di IA esistenti in compiti come il riconoscimento delle immagini e la generazione di testo. Sono progettati per integrarsi senza problemi in varie applicazioni, promuovendo l’innovazione nelle soluzioni IA locali.

Implicazioni

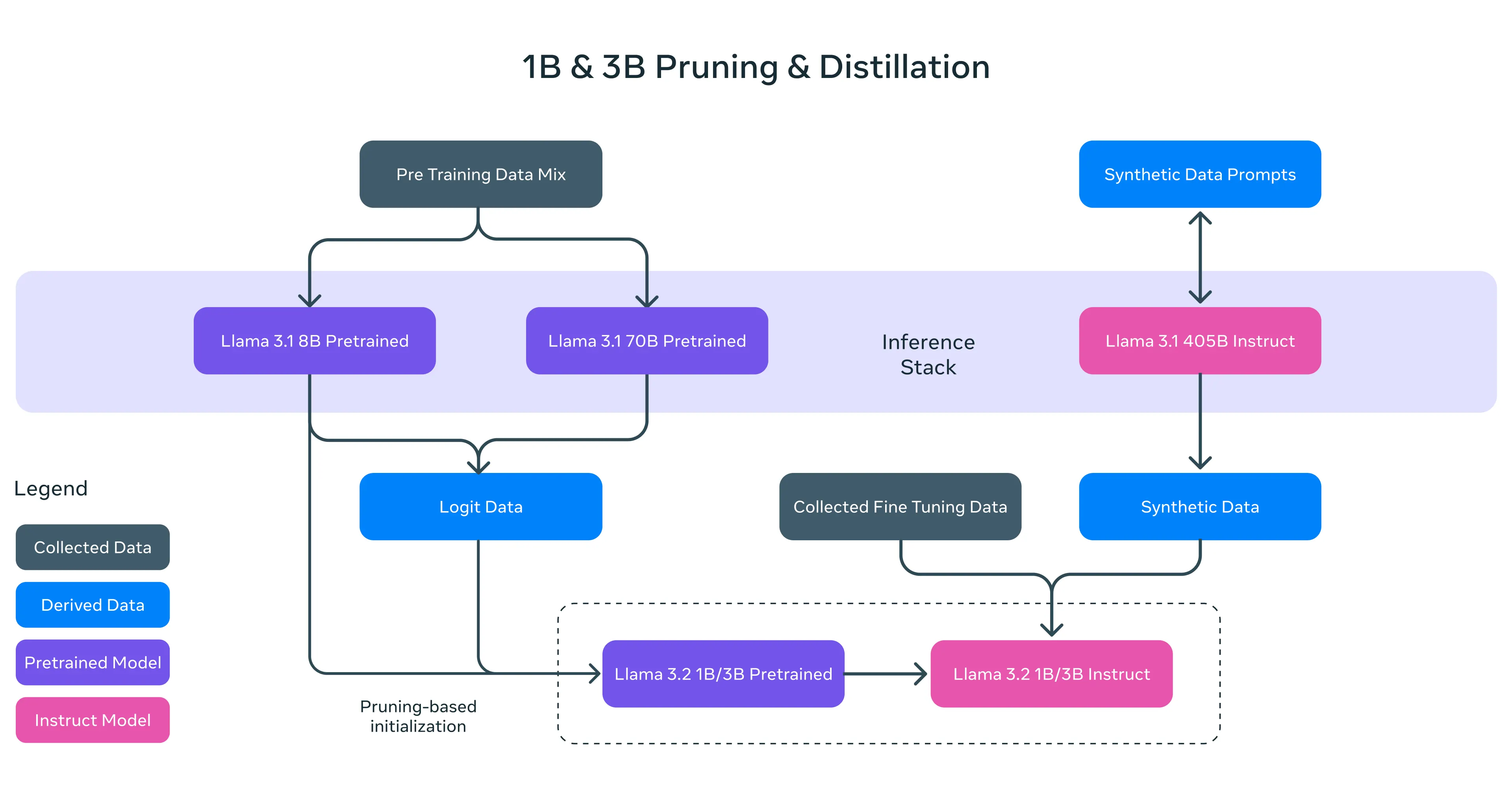

META ha introdotto due nuovi campioni dei pesi mosca: una coppia di modelli con parametri di 1B e 3B, progettati per efficienza, velocità e attività limitate ma ripetitive che non richiedono troppi calcoli.

Questi modelli compatti sono esperti di testo multilingue con una predisposizione per il “tool-calling“, il che significa che possono integrarsi meglio con gli strumenti di programmazione. Nonostante le loro dimensioni ridotte, vantano un’impressionante finestra di contesto token da 128K, la stessa di GPT-4 e altri potenti modelli, rendendoli ideali per riepilogo sul dispositivo, rispetto delle istruzioni e attività di riscrittura.

Il risultato è stato un insieme di modelli compatti che hanno superato i concorrenti nella loro categoria di peso, battendo modelli come Gemma 2 2.6B di Google e Phi-2 2.7B di Microsoft in vari benchmark.

Meta si impegna intensamente a migliorare l’intelligenza artificiale sui dispositivi. Ha stretto collaborazioni strategiche con colossi dell’hardware come Qualcomm, MediaTek e Arm, assicurando che Llama 3.2 sia ottimizzato per funzionare perfettamente con i chip mobili fin dal primo giorno. Anche i leader del cloud computing non sono stati esclusi: AWS, Google Cloud, Microsoft Azure e molti altri offrono accesso immediato ai nuovi modelli sulle loro piattaforme.

La versione Llama 3.2 è open source, almeno secondo gli standard di Meta. Meta permette di scaricare i modelli da Llama.com e Hugging Face, oltre che attraverso il loro ampio ecosistema di partner. Chi è interessato a eseguirlo sul cloud può utilizzare il Google Collab Notebook o Groq per interazioni basate su testo, generando circa 5000 token in meno di 3 secondi.

L’introduzione di Llama 3.2 da parte di Meta evidenzia una crescente tendenza verso l’IA on-device, che non riguarda solo il miglioramento delle prestazioni, ma anche la garanzia della privacy degli utenti e della sicurezza dei dati. Altri colossi tecnologici come Google e Apple stanno avanzando in quest’area con le loro rispettive soluzioni IA integrate nei dispositivi mobili.

Llama 3.2 rappresenta un significativo passo avanti nel rendere l’IA potente accessibile direttamente su dispositivi mobili e edge, rispondendo sia alle esigenze degli sviluppatori per strumenti robusti sia alle richieste degli utenti per privacy e velocità.