Gli Small Language Models (SLM) stanno guadagnando popolarità nel campo del Natural Language Processing (NLP) grazie alla loro efficienza e capacità di operare con risorse limitate. Questi modelli, caratterizzati da un numero di parametri significativamente inferiore rispetto ai Large Language Models (LLM), offrono prestazioni competitive in vari compiti di elaborazione del linguaggio naturale, pur mantenendo un consumo energetico e computazionale ridotto.

Cosa sono gli Small Language Models?

Gli SLM sono versioni più piccole e leggere degli LLM, con un numero di parametri che può variare da pochi milioni a qualche miliardo, rispetto ai centinaia di miliardi di parametri degli LLM come GPT-4. Questa riduzione consente agli SLM di essere implementati in ambienti con risorse limitate, come dispositivi mobili o applicazioni web leggere, rendendoli ideali per scenari in cui non è necessario un modello di grandi dimensioni.

Esempi di Small Language Models

Alcuni esempi di SLM includono:

- Modelli Phi di Microsoft: progettati per offrire prestazioni efficienti in compiti specifici di NLP.

- Gemini 2B di Google: un modello con un numero di parametri ridotto, ottimizzato per applicazioni pratiche.

- Modelli open-source su Hugging Face: che presentano parametri inferiori a un miliardo, rendendoli accessibili per sviluppatori e ricercatori.

Benchmark e Prestazioni

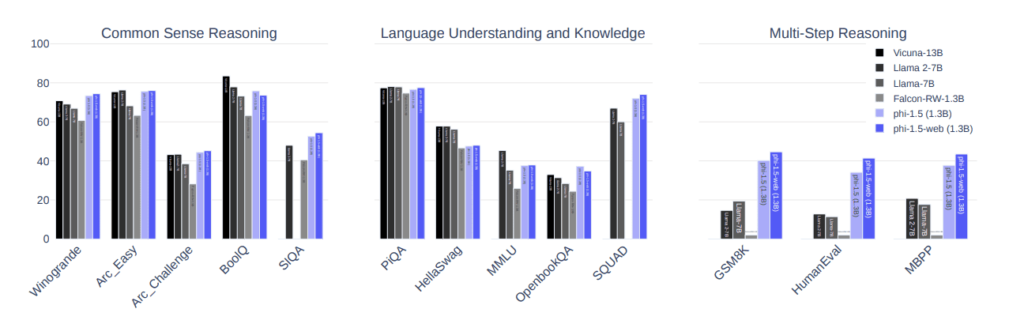

Quando si confrontano SLM e LLM, è fondamentale considerare i benchmark di prestazione. Gli SLM, pur essendo più leggeri, non raggiungono generalmente il livello di accuratezza degli LLM in compiti complessi, ma offrono comunque prestazioni accettabili per applicazioni specifiche. Ad esempio, un modello SLM potrebbe eseguire bene in compiti di classificazione del testo o generazione di risposte in contesti limitati, mentre gli LLM eccellono in compiti che richiedono una comprensione profonda del linguaggio e una vasta conoscenza.

Benchmark Comparativi

| Modello | Numero di Parametri | Tipologia di Task | Performance |

|---|---|---|---|

| GPT-4 | 1 trilione | Conversazione complessa | Eccellente |

| Phi di Microsoft | < 7 miliardi | Compiti specifici di NLP | Buona, ma limitata |

| Gemini 2B | 2 miliardi | Generazione di testo semplice | Competitiva |

| Modelli Hugging Face | < 1 miliardo | Classificazione, risposte brevi | Accettabile, ma non ottimale |

Vantaggi e Limiti degli SLM

Vantaggi:

- Efficienza: Richiedono meno risorse computazionali, rendendoli più accessibili.

- Rapidità di implementazione: Possono essere addestrati e messi in produzione più rapidamente.

- Flessibilità: Possono essere adattati a compiti specifici senza la necessità di enormi set di dati.

Limiti:

- Accuratezza: Non raggiungono i livelli di precisione degli LLM, soprattutto in compiti complessi.

- Capacità di generalizzazione: Possono avere difficoltà a gestire situazioni che richiedono una comprensione profonda del linguaggio.

Influenza dei Dati Sintetici sugli SLM

1. Creazione di Dataset di Alta Qualità

Gli SLM possono essere addestrati su dataset più piccoli ma di alta qualità, generati attraverso tecniche di sintesi. Ad esempio, Microsoft ha sviluppato i modelli Phi-3 utilizzando un approccio che parte da un insieme limitato di parole, creando storie e frasi attraverso l’uso di un Large Language Model (LLM) per generare contenuti coerenti e grammaticalmente corretti. Questo metodo ha dimostrato di migliorare notevolmente la qualità dei dati di addestramento, consentendo agli SLM di eccellere in compiti specifici.

2. Efficienza nell’Addestramento

L’addestramento di SLM su dati sintetici permette di ridurre il tempo e le risorse necessarie rispetto all’addestramento su enormi set di dati reali. Utilizzando dati sintetici, è possibile generare rapidamente un gran numero di esempi di addestramento, facilitando un processo di apprendimento più veloce e meno costoso. Questo è particolarmente vantaggioso per le organizzazioni con risorse limitate.

3. Specializzazione in Nicchie Specifiche

Gli SLM possono essere adattati per eccellere in settori specifici, come quello legale o medico, grazie all’addestramento su dati sintetici progettati per riflettere il linguaggio e le terminologie di questi ambiti. Questo approccio consente di ottenere modelli più precisi e pertinenti, senza la necessità di grandi quantità di dati reali.

4. Mitigazione dei Bias

L’uso di dati sintetici può anche aiutare a mitigare i bias presenti nei set di dati di addestramento. Creando dati sintetici con una rappresentazione bilanciata delle diverse categorie e contesti, è possibile ridurre il rischio di perpetuare stereotipi o pregiudizi nei modelli.