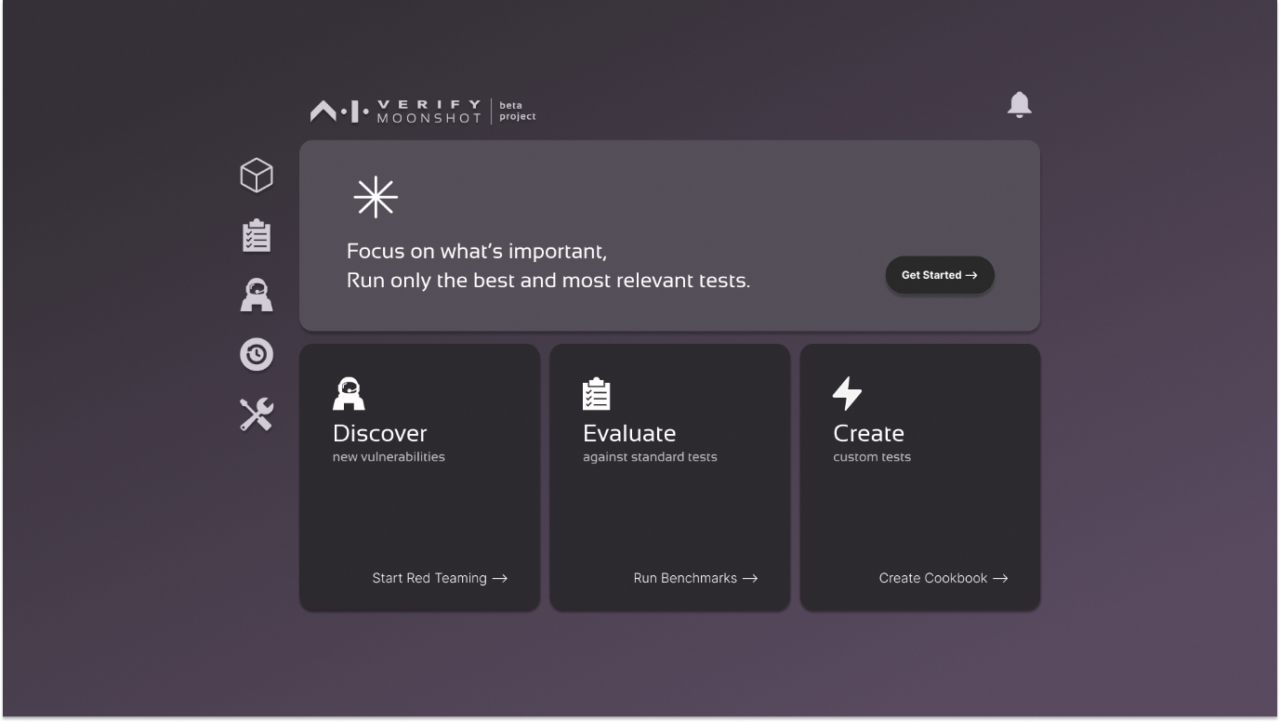

Allo Asia Tech x Singapore (ATxSG) 2024, il Ministro per le Comunicazioni e l’Informazione di Singapore, Mrs. Josephine Teo, ha presentato il Progetto Moonshot, un’iniziativa significativa volta ad affrontare le sfide di sicurezza e protezione associate ai modelli di linguaggio di grandi dimensioni (LLM). Questo toolkit, che è uno dei primi strumenti open-source del suo genere, integra red-teaming, benchmarking e test di base in un’interfaccia user-friendly, rendendolo accessibile anche a utenti non tecnici.

Il Progetto Moonshot è attualmente in beta aperta, progettato per fornire valutazioni intuitive della qualità e della sicurezza di modelli e applicazioni AI. È stato sviluppato in collaborazione con partner del settore come DataRobot, IBM, Singtel e Temasek, assicurando che soddisfi le esigenze pratiche di sviluppatori e scienziati dei dati.

L’iniziativa fa parte di un movimento più ampio verso l’istituzione di standard di test globali per la sicurezza dell’AI. L’AI Verify Foundation (AIVF) e MLCommons hanno firmato un memorandum d’intesa per creare un comune pacchetto di benchmark di sicurezza, migliorando la credibilità e l’utilità del toolkit nell’arena internazionale.

IBM e DataRobot hanno espresso il loro supporto per il Progetto Moonshot, evidenziando il suo potenziale per accelerare l’adozione dell’AI fornendo agli sviluppatori gli strumenti necessari per testare le loro applicazioni rispetto a benchmark di sicurezza stabiliti. Questa collaborazione riflette un impegno per uno sviluppo responsabile dell’AI e l’importanza di standard aperti nel settore.

Il lancio del Progetto Moonshot coincide con il primo anniversario dell’AI Verify Foundation, che ha visto crescere significativamente la sua adesione e ha ampliato il suo focus da strumenti di test AI allo sviluppo di prodotti completi per la sicurezza dell’AI. Questo include l’allineamento con standard internazionali come l’ISO 42001 e l’integrazione con framework esistenti come il toolkit Veritas della Monetary Authority of Singapore.

Il Progetto Moonshot esemplifica l’approccio proattivo di Singapore nella gestione dei rischi legati all’AI attraverso sforzi collaborativi e strumenti innovativi. Sfruttando la comunità open-source globale e promuovendo partnership con aziende tecnologiche leader, Singapore mira a garantire l’uso sicuro e responsabile delle tecnologie AI, stabilendo un precedente per altre nazioni da seguire nel campo della governance e degli standard di sicurezza dell’AI.