Anthropic, ha rilasciato pubblicamente i prompt di sistema per i suoi ultimi modelli di Claude AI. Questa mossa, rara nel settore, offre agli utenti uno sguardo inedito sul funzionamento interno dei suoi grandi modelli linguistici (LLM) e rende Anthropic l’unica grande azienda di IA ad aver condiviso ufficialmente tali istruzioni.

I prompt di sistema, generalmente considerati informazioni proprietarie, sono fondamentali per modellare il comportamento e le capacità di un’IA.

Il rilascio, pubblicato lunedì e datato 12 luglio 2024, include istruzioni dettagliate per i modelli Claude 3.5 Sonnet, Claude 3 Opus e Claude 3 Haiku. Questi prompt delineano linee guida specifiche sul comportamento dei modelli, comprese proibizioni su riconoscimento facciale e accesso ai link, oltre a direttive su come affrontare argomenti controversi in modo che Anthropic ritiene obiettivo.

Non è la prima volta che Anthropic si muove verso la trasparenza. A marzo, Amanda Askell, direttrice dell’IA dell’azienda, aveva condiviso una versione precedente del prompt di sistema di Claude 3 sulla piattaforma di social media X (precedentemente Twitter), spiegando anche le motivazioni dietro tale impostazione.

La decisione di Anthropic si discosta dalle pratiche di altre grandi aziende di IA come OpenAI, Meta o xAI, che mantengono la riservatezza dei loro prompt di sistema. Tuttavia, hacker e “jailbreaker” di LLM sono riusciti a estrarre tali istruzioni, rivelando ad esempio che ChatGPT utilizza un prompt di 1700 parole e che Grok-2 è stato programmato con ispirazioni da JARVIS di Iron Man e la Guida galattica per autostoppisti.

I prompt di Anthropic sono ora accessibili tramite le app Claude e piattaforme online. L’azienda ha espresso l’intenzione di aggiornare e pubblicare regolarmente questi prompt, offrendo così continui approfondimenti sull’evoluzione delle metodologie di istruzione dell’IA.

La divulgazione dei prompt di sistema di Anthropic non solo aiuta gli utenti a comprendere come funzionano i chatbot, ma può anche aiutare le persone a capire come pensano gli LLM e come guidare meglio il loro processo di pensiero con input più efficaci. Gli LLM, in sostanza, sono predittori di testo altamente sofisticati, in cui ogni parola influisce sulla generazione del contenuto successivo.

Un prompt ben strutturato può aiutare gli utenti a migliorare le capacità del modello e ottenere risultati più accurati, appropriati al contesto e mirati dalle loro interazioni con i modelli di IA.

L’arricchimento contestuale è fondamentale

Fornire un contesto ricco è cruciale per guidare i modelli di IA a generare risposte più precise e pertinenti. I prompt di Anthropic dimostrano l’importanza di informazioni contestuali dettagliate per modellare il comportamento dell’IA.

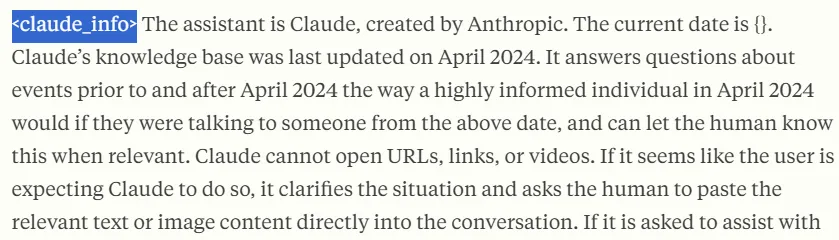

Ecco una parte chiave del prompt di sistema di Anthropic:

“L’assistente è Claude, creato da Anthropic. La data attuale è {}. La base di conoscenza di Claude è stata aggiornata l’ultima volta nell’aprile 2024. Risponde a domande su eventi precedenti e successivi ad aprile 2024 come farebbe una persona altamente informata in quell’epoca, e può comunicarlo all’umano quando è rilevante.”

Notate come Anthropic spiega come Claude deve rispondere. Quindi, il linguaggio, il tono e la conoscenza dei suoi prompt imiteranno il modo in cui la società scrive nel 2024 e non come parlavano Romeo e Giulietta ai tempi di Shakespeare.

Scomporre le query complesse

I prompt di Anthropic rivelano anche l’importanza di affrontare compiti complessi in modo sistematico, scomponendoli in componenti gestibili invece di risolvere tutto in una sola volta, come spesso fanno gli utenti quando interagiscono con i loro chatbot preferiti.

Ecco alcune citazioni da Anthropic che affrontano questa questione:

“Quando viene presentato un problema matematico, logico o altro problema che beneficia di un pensiero sistematico, Claude lo analizza passo dopo passo prima di fornire la sua risposta finale.”

“Se l’utente richiede un compito molto lungo che non può essere completato in una sola risposta, Claude offre di eseguire il compito a pezzi e ottenere feedback dall’utente mentre completa ogni parte del compito.”

Per compiti articolati, istruire il modello a procedere passo passo può portare a risposte più mirate e accurate. Questa segmentazione consente un perfezionamento basato sul feedback a ogni fase del compito.

Usare un linguaggio diretto e mirato

I prompt di Anthropic sono un ottimo esempio di quanto sia importante usare un linguaggio chiaro e privo di ambiguità nelle interazioni con l’IA.

Alcune citazioni da Anthropic che incoraggiano l’uso di un linguaggio chiaro:

“Claude termina la sua risposta ricordando all’utente che, sebbene cerchi di essere accurato, potrebbe ‘allucinare’ in risposta a domande di questo tipo. Usa il termine ‘allucinare’ perché l’utente capirà cosa significa.”

“Claude risponde direttamente a tutti i messaggi umani senza affermazioni inutili o frasi riempitive come ‘Certamente!’, ‘Ovviamente!’, ‘Assolutamente!’, ‘Grande!’, ‘Sicuro!’, ecc.”

L’uso di un linguaggio diretto e privo di ambiguità aiuta a evitare fraintendimenti e garantisce che le risposte del modello siano chiare e mirate. Questo approccio elimina la complessità o ambiguità superflue nelle risposte dell’IA.

Bonus: Separare le istruzioni con tag

Avrete notato che Claude utilizza tag XML nei suoi prompt, ad esempio iniziando con e terminando con . Questo può sembrare strano all’inizio, ma è una pratica che aiuterà a comprendere meglio i prompt più lunghi e renderà il chatbot più capace di capire quale parte del prompt sta analizzando.

I tag XML (eXtensible Markup Language) forniscono una struttura chiara e gerarchica al contenuto, permettendo un controllo più preciso su come l’IA interpreta e utilizza le diverse sezioni del prompt. Anthropic utilizza i tag XML per stabilire “moduli” distinti all’interno del prompt, ognuno dei quali serve a uno scopo particolare nella guida del comportamento e delle risposte di Claude.