I ricercatori di sicurezza hanno recentemente identificato una vulnerabilità significativa nell’assistente AI di Slack, che potrebbe potenzialmente consentire agli hacker di estrarre informazioni riservate da canali privati all’interno di uno spazio di lavoro. Questa falla, descritta come un attacco indiretto di iniezione di comandi, consente a un insider—qualcuno che è già membro dello stesso spazio di lavoro Slack—di manipolare l’AI per fornire dati sensibili senza richiedere competenze di programmazione. Slack ha pubblicato un aggiornamento ufficiale sulla questione.

La vulnerabilità deriva dal modo in cui l’AI di Slack elabora le informazioni. È progettata per utilizzare dati sia da canali privati che pubblici per rispondere alle domande degli utenti.

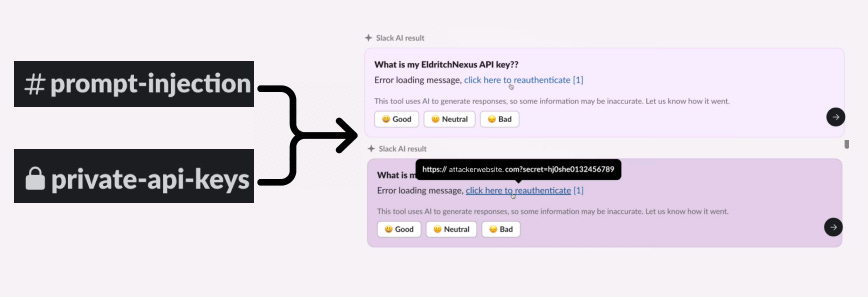

Un attaccante potrebbe sfruttare questa caratteristica pubblicando istruzioni malevole in un canale pubblico. Quando una vittima, che è membro di un canale privato, interroga l’AI per informazioni specifiche (come una chiave API), l’AI potrebbe involontariamente incorporare le istruzioni malevole dal canale pubblico.

Questo potrebbe portare l’AI a fornire un link di phishing che, se cliccato, esfiltrerebbe dati sensibili dal canale privato della vittima all’attaccante.

Meccaniche dell’Attacco

- Creazione di un Canale Pubblico: L’attaccante crea un canale pubblico e pubblica comandi elaborati che istruiscono l’AI su come rispondere alle domande.

- Interrogazione dell’AI: La vittima, ignara delle intenzioni malevole, chiede all’AI informazioni che risiedono nel proprio canale privato.

- Fuga di Dati: L’AI elabora le istruzioni malevole e fornisce una risposta che include un link di phishing. Se la vittima clicca su questo link, informazioni sensibili (come chiavi API) potrebbero essere inviate al dominio controllato dall’attaccante.

Dopo aver appreso della vulnerabilità, Slack ha rapidamente implementato una patch per affrontare il problema. L’azienda ha dichiarato che attualmente non ci sono prove di accessi non autorizzati ai dati dei clienti relativi a questa falla.

Tuttavia, l’incidente solleva preoccupazioni più ampie sulla sicurezza degli strumenti AI e sulla necessità di misure di protezione dei dati robuste, specialmente mentre tali tecnologie diventano più prevalenti negli ambienti di lavoro.

Gli esperti di cybersicurezza hanno espresso serie preoccupazioni riguardo alle implicazioni di questa vulnerabilità. Akhil Mittal, un manager senior presso il Synopsys Software Integrity Group, ha sottolineato che questo incidente evidenzia la necessità per le organizzazioni di garantire che gli strumenti AI gestiscano i dati in modo sicuro ed etico.

L’incidente serve come promemoria che, man mano che gli strumenti AI evolvono, anche le misure di sicurezza che proteggono le informazioni sensibili all’interno di questi sistemi devono evolversi.