Anthropic ha recentemente lanciato una nuova funzionalità chiamata prompt caching, disponibile in versione beta pubblica per i modelli Claude 3.5 Sonnet e Claude 3 Haiku.

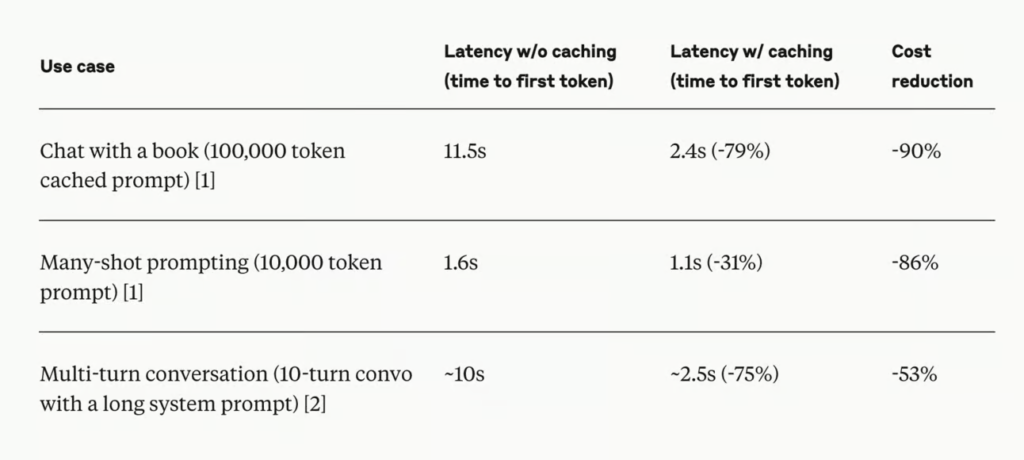

Questa innovazione consente agli sviluppatori di memorizzare contesti frequentemente utilizzati tra le chiamate API, con l’obiettivo di ridurre i costi fino al 90% e la latenza fino all’85% per i prompt lunghi.

Vantaggi del Prompt Caching

La funzionalità di prompt caching è particolarmente utile in diverse applicazioni:

- Agenti Conversazionali: Riduce i costi e la latenza per conversazioni prolungate, specialmente quando si utilizzano istruzioni lunghe o documenti caricati.

- Assistenti di Codifica: Migliora l’autocompletamento e le domande e risposte sui codici mantenendo una versione riassunta del codice nel prompt.

- Elaborazione di Documenti Lunghi: Permette di incorporare materiali di lunga durata, come libri o articoli, senza aumentare i tempi di risposta.

- Set di Istruzioni Dettagliate: Consente di condividere liste estese di istruzioni e esempi per affinare le risposte di Claude.

- Utilizzo di Strumenti Agenti: Migliora le prestazioni in scenari che richiedono più chiamate a strumenti e modifiche iterative.

Funzionamento

Quando un prompt viene inviato con il caching attivato, il sistema verifica se il prefisso del prompt è già memorizzato da una query recente. Se trovato, utilizza la versione memorizzata, riducendo il tempo di elaborazione e i costi. Altrimenti, elabora il prompt completo e memorizza il prefisso per usi futuri. La cache ha una durata di cinque minuti e viene aggiornata ad ogni utilizzo, rendendola ideale per conversazioni lunghe o compiti complessi che richiedono più chiamate API.

Struttura dei Costi

Il costo della scrittura nella cache è superiore del 25% rispetto al prezzo base dei token di input, mentre l’utilizzo del contenuto memorizzato è significativamente ridotto, costando solo il 10% del prezzo base dei token di input. Questo approccio rende l’integrazione dell’AI più accessibile ed economicamente sostenibile per sviluppatori e aziende.

Con il lancio del prompt caching, Anthropic si propone di ottimizzare l’uso delle API e ridurre i costi, facilitando applicazioni AI più sofisticate in vari settori. Questa funzionalità è già stata integrata da clienti come Notion, migliorando l’esperienza utente e le operazioni interne grazie a una maggiore velocità e riduzione dei costi.