L’affective computing, una disciplina che combina l’informatica con la psicologia per creare sistemi in grado di riconoscere e rispondere alle emozioni umane, ha suscitato un dibattito globale.

L’affective computing è una tecnologia emergente che combina informatica, psicologia e scienze cognitive.

Rosalind Picard ha introdotto questo concetto nel suo paper del 1995 sull’affective computing, mirato a simulare l’empatia. Nell’ambito dell’affective computing, una macchina dovrebbe essere in grado di interpretare gli stati emotivi degli esseri umani e adattare il proprio comportamento di conseguenza, rispondendo in modo appropriato a tali emozioni.

Investimenti : Microsoft VIBE, Kairos, CrowdEmotion, Affectiva, Beyond Verbal, PointGrab, nViso, Eyeris, Intel RealSense, Realeyes, the Affective Computing Company, Elliptic Labs, SoftKinetic, Sension, Gestigon sono alcune delle principali aziende di Affective Computing.

Nonostante le sue promettenti applicazioni, come il miglioramento delle interazioni uomo-macchina e l’assistenza sanitaria, ci sono significative preoccupazioni e critiche da parte di ricercatori, eticisti e il pubblico in generale.

Privacy e Sicurezza dei Dati

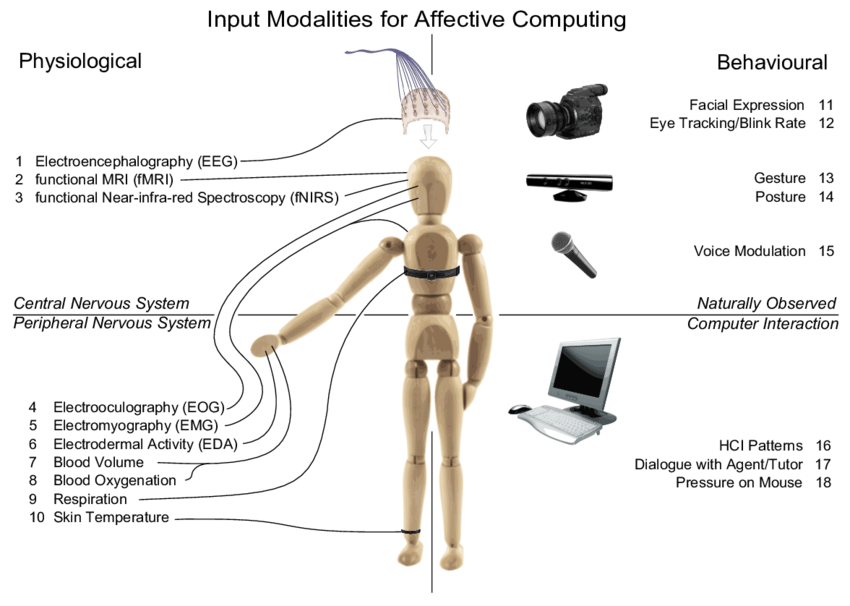

La privacy è una delle principali preoccupazioni quando si parla di affective computing. Il trattamento delle emozioni umane richiede la raccolta di dati sensibili, come espressioni facciali, tono di voce e comportamento. Questi dati, se non gestiti correttamente, possono essere vulnerabili a violazioni e abusi.

Secondo Shoshana Zuboff nel suo libro “The Age of Surveillance Capitalism” (2019), la raccolta e l’analisi dei dati emotivi possono portare a un livello senza precedenti di sorveglianza e controllo sugli individui. Zuboff sottolinea che “la sorveglianza e la manipolazione del comportamento umano non sono semplicemente una questione di privacy; minacciano la libertà individuale e collettiva”.

Un esperimento condotto da Michal Kosinski e Yilun Wang, pubblicato su Journal of Personality and Social Psychology (2017), ha dimostrato che algoritmi basati sul riconoscimento facciale possono determinare l’orientamento sessuale degli individui con un’accuratezza sorprendente. Questo solleva interrogativi etici su come i dati emotivi possano essere utilizzati per fare inferenze su aspetti profondamente personali della vita degli individui.

Affidabilità e Accuratezza

L’affidabilità degli algoritmi di riconoscimento delle emozioni è un’altra area di critica. Questi sistemi possono fare errori significativi, con conseguenze potenzialmente dannose. Gli errori nel riconoscimento delle emozioni possono portare a malintesi e risposte inappropriate.

Rosalind Picard, pioniera dell’affective computing, ha riconosciuto che “anche con algoritmi avanzati, il riconoscimento delle emozioni non è infallibile e può essere influenzato da vari fattori contestuali e personali” (Affective Computing, 1997). Questo limita l’affidabilità di tali sistemi, soprattutto in contesti critici come l’assistenza sanitaria e la sicurezza.

In uno studio del 2019 condotto da Barrett et al., pubblicato su Nature, è stato dimostrato che le emozioni sono complesse e culturalmente specifiche. Gli algoritmi di riconoscimento emotivo, addestrati su dati raccolti in contesti culturali specifici, possono non essere accurati quando applicati a individui di culture diverse, sottolineando la difficoltà di creare sistemi universali di riconoscimento delle emozioni.

Bias e Discriminazione

Gli algoritmi di intelligenza artificiale, inclusi quelli utilizzati nell’affective computing, possono incorporare bias presenti nei dati di addestramento. Questi bias possono portare a discriminazioni nei confronti di determinati gruppi di persone.

Joy Buolamwini e Timnit Gebru hanno evidenziato questo problema nel loro studio “Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification” (2018). Hanno scoperto che i sistemi di riconoscimento facciale di alcune delle principali aziende tecnologiche avevano tassi di errore significativamente più alti per le donne di colore rispetto agli uomini bianchi. Questo tipo di bias può avere conseguenze gravi se applicato al riconoscimento delle emozioni, portando a trattamenti iniqui e discriminatori.

Manipolazione delle Emozioni

Un’altra critica rilevante riguarda la possibilità che l’affective computing possa essere utilizzato per manipolare le emozioni degli individui. Questo potrebbe essere particolarmente problematico nel contesto della pubblicità e del marketing.

Nel libro “Weapons of Math Destruction” (2016), Cathy O’Neil avverte che “gli algoritmi che influenzano il nostro comportamento possono essere sfruttati per manipolare le nostre decisioni, spesso senza che ce ne rendiamo conto”. Questo può portare a una perdita di autonomia personale e a un aumento della manipolazione commerciale.

Un esempio concreto di questa preoccupazione è l’esperimento di Facebook del 2012, in cui l’azienda ha manipolato i feed di notizie di circa 700.000 utenti per studiare l’effetto delle emozioni. I risultati, pubblicati su PNAS (2014), hanno mostrato che le emozioni possono essere contagiose attraverso i social media. Questo esperimento ha sollevato importanti questioni etiche riguardo alla manipolazione delle emozioni senza il consenso informato degli utenti.

L’affective computing rappresenta una frontiera emozionante della tecnologia, con potenziali benefici significativi in vari settori. Tuttavia, le critiche riguardanti la privacy, l’affidabilità, i bias e la manipolazione delle emozioni non possono essere ignorate. È essenziale che lo sviluppo e l’implementazione di queste tecnologie siano guidati da rigorosi standard etici e da una forte considerazione delle implicazioni sociali e culturali. Solo così possiamo garantire che l’affective computing venga utilizzato in modo responsabile e benefico per tutti.

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale. Iscriviti alla newsletter di Rivista.AI e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

Lascia un commento

Devi essere connesso per inviare un commento.