DeepSeek-Coder-V2 è un modello di linguaggio di codifica open source basato su una Mixture-of-Experts (MoE), che raggiunge prestazioni paragonabili a GPT4-Turbo nei compiti specifici del codice.

Il modello è stato ulteriormente pre-addestrato a partire da DeepSeek-Coder-V2-Base con 6 trilioni di token provenienti da un corpus di alta qualità e multi-sorgente.

Grazie a questo ulteriore pre-addestramento, DeepSeek-Coder-V2 migliora sostanzialmente le capacità di codifica e ragionamento matematico rispetto a DeepSeek-Coder-V2-Base, mantenendo prestazioni comparabili nei compiti di linguaggio generale.

Rispetto alla versione precedente DeepSeek-Coder, DeepSeek-Coder-V2 dimostra progressi significativi in vari aspetti dei compiti relativi al codice, oltre che nelle capacità di ragionamento e generali. DeepSeek-Coder-V2 espande il supporto per i linguaggi di programmazione da 86 a 338 e aumenta la lunghezza del contesto da 16K a 128K.

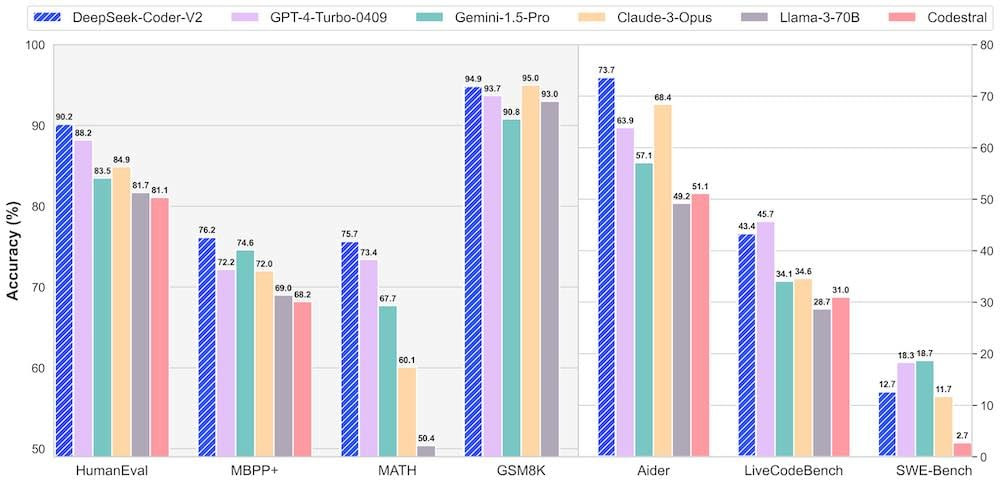

Nelle valutazioni standard dei benchmark, DeepSeek-Coder-V2 raggiunge prestazioni superiori rispetto a modelli closed-source come GPT4-Turbo, Claude 3 Opus e Gemini 1.5 Pro nei benchmark di codifica e matematica

Le principali differenze tra DeepSeek-Coder-V2 e GPT4-Turbo sono:

1. Licensing and Accessibility

- DeepSeek-Coder-V2: Open-source model con licenza dual, garantendo accesso aperto e responsabilità. Questo modello è disponibile per uso commerciale e ricerca, senza restrizioni.

- GPT4-Turbo: Modello closed-source con licenza restrittiva, limitando l’accesso e l’utilizzo in ambienti commerciali e di ricerca.

2. Performance and Benchmarks

- DeepSeek-Coder-V2: Ha raggiunto prestazioni superiori a GPT4-Turbo in vari benchmark di codifica e ragionamento matematico, dimostrando una maggiore capacità di comprensione e generazione di codice.

- GPT4-Turbo: Ha prestazioni elevate in compiti di codifica e ragionamento matematico, ma non è disponibile per l’utilizzo aperto e commerciale.

3. Dataset and Training

- DeepSeek-Coder-V2: Utilizza un dataset di 10.2 trilioni di token, comprensivo di codice, matematica e linguaggio naturale, che gli consente di comprendere e generare codice in diversi linguaggi.

- GPT4-Turbo: Utilizza un dataset più limitato, focalizzato sulla codifica e ragionamento matematico, ma non è disponibile per l’utilizzo aperto e commerciale.

4. Variants and Scalability

- DeepSeek-Coder-V2: Disponibile in due varianti: DeepSeek-Coder-V2-Lite (16B parametri) e DeepSeek-Coder-V2 (236B parametri), che offrono prestazioni diverse e scalabilità per diverse esigenze.

- GPT4-Turbo: Non ha varianti specifiche per prestazioni diverse, ma è disponibile in diverse versioni, come gpt-4o e gpt-4-turbo-2024-04-09, che offrono prestazioni diverse.

5. Integration and Compatibility

- DeepSeek-Coder-V2: È progettato per essere integrato in ambienti di sviluppo e di produzione, supportando diversi linguaggi di programmazione e offrendo una maggiore flessibilità.

- GPT4-Turbo: È disponibile per l’utilizzo in ambienti di sviluppo e di produzione, ma non supporta l’integrazione con altri strumenti e servizi come DeepSeek-Coder-V2.

Lascia un commento

Devi essere connesso per inviare un commento.