Un’intervista recente su Noema con Eric Schmidt, ex CEO di Google, ha stimolato riflessioni importanti sul futuro dell’intelligenza artificiale (IA).

Schmidt prevede che ci troviamo in un momento di rapida evoluzione tecnologica, con nuovi modelli che emergono ogni 12-18 mesi. Secondo lui, nei prossimi tre o quattro anni assisteremo a cambiamenti sostanziali, grazie a una scala di capacità in continua crescita.

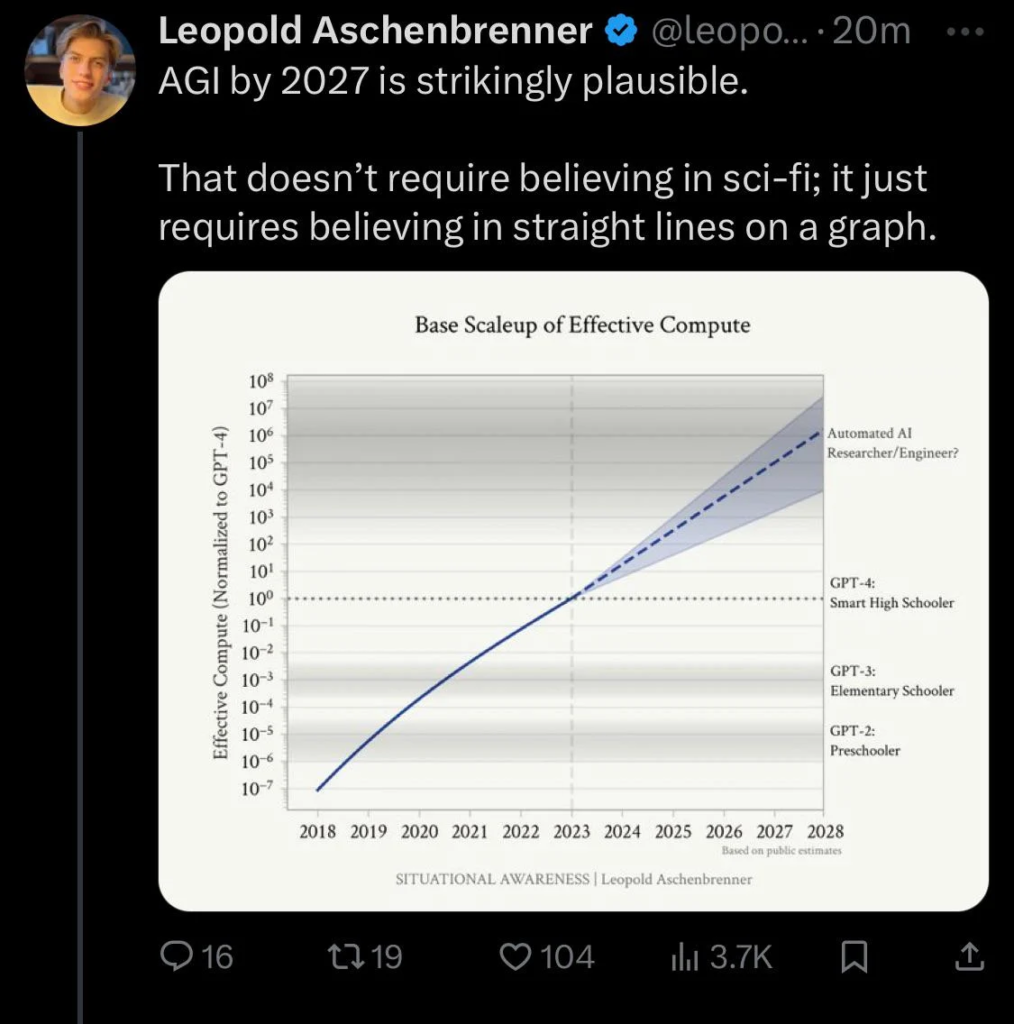

Parallelamente, Leopold Aschenbrenner, ex membro del team di sicurezza di OpenAI, ha pubblicato un esteso post di 165 pagine sul futuro dell’IA.

Questo documento, sebbene controverso, fornisce una visione dettagliata sulla geopolitica, la sicurezza e l’uso dell’energia nel contesto dell’IA. In particolare, Aschenbrenner sottolinea come i costi e le dimensioni dei cluster computazionali stiano aumentando esponenzialmente, con prospettive di miliardi di dollari in investimenti e risorse energetiche sempre più contese.

Le Proiezioni di Aschenbrenner e la Visione di Schmidt

Aschenbrenner suggerisce che entro il 2027 i modelli di IA potrebbero svolgere il lavoro di ricercatori e ingegneri specializzati. Questa idea trova eco nelle dichiarazioni di Kevin Scott, CTO di Microsoft, che prevede che GPT-5 sarà in grado di superare esami di qualificazione a livello di dottorato.

Entrambi gli esperti concordano sul fatto che i miglioramenti delle capacità dell’IA derivano dal ridimensionamento dei modelli, ovvero l’aggiunta di maggior potenza computazionale e dati. Questi modelli più grandi sono non solo migliori nell’analisi e nella comprensione del linguaggio, ma anche più abili nel mantenere il contesto su periodi prolungati, risultando in informazioni più fattuali e accurate.

La Scalabilità dei Modelli di IA

Accettando le leggi di scala, possiamo prevedere che i futuri modelli come GPT-5 offriranno miglioramenti radicali rispetto ai loro predecessori. Ad esempio, GPT-3 eccelle in compiti che richiedono pochi secondi, mentre GPT-4 si distingue in attività che richiedono fino a cinque minuti. Si prevede che GPT-5 possa affrontare compiti della durata di diverse ore, ampliando notevolmente le sue applicazioni pratiche.

Implicazioni nel Mondo Reale

Il passaggio da attività di breve durata a compiti più complessi avrà un impatto significativo. Schmidt prevede che queste macchine saranno in grado di eseguire compiti con migliaia di passaggi discreti nei prossimi cinque anni. Questo include la capacità di scrivere saggi completi, condurre analisi dettagliate, e persino gestire operazioni complesse come le dichiarazioni fiscali.

L’Esperienza Personale con l’IA

La mia esperienza con strumenti di IA, come GPT-4 e Claude, dimostra l’efficacia di questi modelli in compiti complessi. Ad esempio, ho utilizzato GPT-4 per analizzare discorsi famosi e migliorare il mio discorso per la conferenza AI For Good a Ginevra. Questo processo iterativo di feedback e revisione ha permesso di ottenere un risultato significativamente migliore, evidenziando come l’accesso a potenti assistenti IA possa elevare le ambizioni e le aspettative personali.

Il Futuro: GPT-5 e Oltre

Guardando avanti, l’integrazione di assistenti IA sempre più avanzati promette di rivoluzionare molti aspetti della nostra vita quotidiana e professionale. Le aziende e gli individui potranno sfruttare dozzine di assistenti virtuali, aumentando l’efficienza e la produttività in modi prima inimmaginabili.

La questione centrale resta: cosa significherà avere accesso a software in grado di svolgere compiti complessi in maniera efficiente e a basso costo?

Commento di Rivista.AI

L’intelligenza artificiale ha la capacità di apprendere giochi e logiche, permettendo un’esperienza di gioco personale infinita. Tuttavia, è noto che la logica è incompleta e non è possibile comprendere il mondo solo attraverso postulati fissi.

I sistemi attuali utilizzano praticamente tutti i dati disponibili, raggiungendo quello che viene definito “muro dei dati”.

Un esempio chiave è rappresentato dai sistemi AlphaGo e AlphaZero. Mentre il primo ha imparato dai giochi umani, AlphaZero non necessita di dati umani: può apprendere esclusivamente dalle regole e migliorare giocando contro se stesso, raggiungendo livelli sovrumani.

Può persino generare nuove partite mai viste prima. Allo stesso modo, i modelli di linguaggio di grandi dimensioni (LLM) possono produrre pensieri originali dialogando con se stessi.

Qui entra in gioco l’importanza di Chomsky, nonostante il suo scetticismo nei confronti della semantica statistica. Il linguaggio è un sistema combinatorio discreto e produttivo con un potenziale infinito, molto simile agli scacchi o al go.

Lo scorso fine settimana, il Wall Street Journal ha pubblicato un articolo di uno dei loro editorialisti tecnologici, intitolato “L’intelligenza artificiale sovrastimata”. L’articolo evidenziava che i 50 miliardi di dollari investiti in chip AI hanno generato solo 3 miliardi di vendite.

Sebbene siamo ancora agli inizi e probabilmente sul lato sinistro della curva di crescita a S, ci sono segnali che stiamo raggiungendo i limiti di ciò che può essere ottenuto da Internet.

L’autore ha lasciato in sospeso la questione se l’intelligenza artificiale abbia “gambe” per andare avanti o se siamo semplicemente in una bolla. Ha anche sottolineato che il costo di gestione degli LLM superava il costo di costruzione. (Su scala globale). E che finora, certamente all’inizio, l’investitore razionale non poteva giustificare un investimento in tali titoli.

Questa è una domanda cruciale che determinerà l’evoluzione e l’impatto dell’intelligenza artificiale nel prossimo futuro.

Sono passati alcuni anni, quindi ripropongo un vecchio adagio sulle fasi della gestione del progetto:

1. Entusiasmo sfrenato 2. Disillusione strisciante 3. Panico ad occhi spalancati 4. Ricerca del colpevole 5. Punizione dell’innocente 6. Lodi e onori per i non partecipanti.

Lascia un commento

Devi essere connesso per inviare un commento.