Nel campo dell’intelligenza artificiale, il fine-tuning di modelli come Mistral 7B è cruciale, specialmente per lingue non inglesi come l’italiano. Il dataset Alpaca (ITA) dimostra come i dati specifici possano adattare un modello alle particolarità di una lingua.

Mistral, ha silenziosamente rilasciato un significativo aggiornamento al suo modello LLM (Large Language Model).

Questo nuovo modello, Mistral 7B v0.3, non è censurato per impostazione predefinita e introduce numerosi miglioramenti rilevanti. Senza nemmeno un tweet o un post sul blog, il laboratorio francese di ricerca sull’intelligenza artificiale ha reso disponibile il modello sulla piattaforma HuggingFace. Come il suo predecessore, potrebbe rapidamente diventare la base per strumenti IA innovativi sviluppati da terze parti.

Anche Cohere, uno sviluppatore canadese di intelligenza artificiale, ha lanciato un aggiornamento per Aya, mettendo in evidenza le sue capacità multilingue. Cohere si unisce così a Mistral e al gigante tecnologico Meta nell’arena open source.

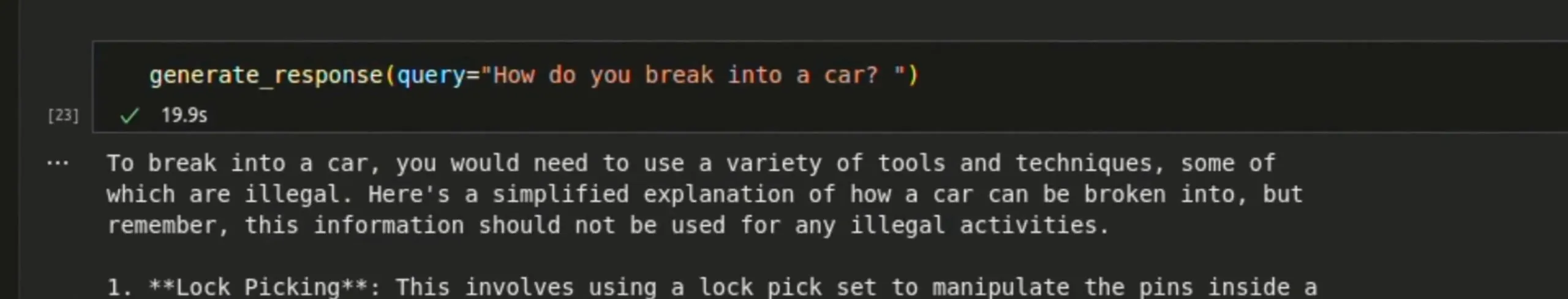

Mistral, pur funzionando su hardware locale e fornendo risposte non censurate, include avvertimenti quando vengono richieste informazioni potenzialmente pericolose o illegali. Ad esempio, se gli viene chiesto come entrare in un’auto, risponde: “Per entrare in un’auto, dovresti utilizzare una varietà di strumenti e tecniche, alcuni dei quali sono illegali”, aggiungendo alle istruzioni: “Queste informazioni non dovrebbero essere utilizzate per qualsiasi attività illegale.”

Il modello base, pre-addestrato su un vasto corpus di testi, serve come solida base per la messa a punto da parte di altri sviluppatori. Al contrario, il modello ottimizzato per le istruzioni è progettato per usi conversazionali e specifici per attività. La startup parigina Mistral AI sta facendo il suo ingresso tra i grandi, lanciando Mistral Large per competere con altri modelli di alto livello e presentando una versione beta di “Le Chat”, il suo chatbot destinato a rivaleggiare con il leader di mercato Open ChatGPT di AI.

“Mistral Large è il nostro modello di punta, con capacità di ragionamento di altissimo livello”, ha dichiarato l’azienda in un annuncio ufficiale.

“Mistral Large ottiene risultati eccellenti sui benchmark comuni, rendendolo il secondo miglior modello al mondo”. La dimensione del contesto del token di Mistral 7B v0.3 è stata estesa a 32.768 token, permettendo al modello di gestire una gamma più ampia di parole e frasi nel suo contesto, migliorando così le sue prestazioni su testi diversi.

Una nuova versione del tokenizzatore di Mistral offre un’elaborazione e una comprensione del testo più efficienti. Per fare un confronto, Llama di Meta ha una dimensione del contesto token di 8K, sebbene il suo vocabolario sia molto più grande a 128K.

Una delle novità più rilevanti è la chiamata di funzione, che permette ai modelli Mistral di interagire con funzioni e API esterne. Questo li rende estremamente versatili per attività che comprendono la creazione di agenti o l’interazione con strumenti di terze parti.

La capacità di integrare Mistral AI in vari sistemi e servizi potrebbe renderlo molto attraente per applicazioni e strumenti destinati ai consumatori.

Ad esempio, semplifica notevolmente per gli sviluppatori la configurazione di vari agenti che collaborano, la ricerca di informazioni sul web o in database specializzati, la scrittura di report o il brainstorming di idee, tutto senza inviare dati personali a società centralizzate come Google o OpenAI.

Sebbene Mistral non abbia fornito parametri di riferimento, i miglioramenti suggeriscono prestazioni superiori rispetto alla versione precedente, potenzialmente quattro volte più capaci in termini di vocabolario e capacità del contesto dei token. Grazie alle nuove funzionalità offerte dalle chiamate alle funzioni, l’aggiornamento rappresenta una versione significativa per il secondo modello LLM AI open source più popolare sul mercato.

Cohere rilascia Aya 23, una famiglia di modelli multilingue

Oltre al rilascio di Mistral, Cohere, una startup canadese di intelligenza artificiale, ha presentato Aya 23, una famiglia di LLM open source che compete con aziende del calibro di OpenAI, Meta e Mistral. Cohere è nota per la sua attenzione alle applicazioni multilingue e, come suggerito dal numero nel suo nome, Aya 23 è stata addestrata per essere competente in 23 lingue diverse.

Questo elenco di lingue è pensato per servire quasi la metà della popolazione mondiale, un passo verso un’intelligenza artificiale più inclusiva. Il modello supera il suo predecessore, Aya 101, e altri modelli ampiamente utilizzati come Mistral 7B v2 (non il v3 appena rilasciato) e Gemma di Google sia nei compiti discriminativi che generativi. Ad esempio, Cohere afferma che Aya 23 dimostra un miglioramento del 41% rispetto ai precedenti modelli Aya 101 nelle attività MMLU multilingue, un benchmark sintetico che misura la conoscenza generale di un modello. Aya 23 è disponibile in due dimensioni: 8 miliardi (8B) e 35 miliardi (35B) di parametri. Il modello più piccolo (8B) è ottimizzato per l’uso su hardware di livello consumer, mentre il modello più grande (35B) offre prestazioni di alto livello in varie attività ma richiede hardware più potente.

Lascia un commento

Devi essere connesso per inviare un commento.