I recenti cambiamenti di leadership all’interno di OpenAI, inclusi le partenze del co-fondatore e del Chief Scientist Ilya Sutskever e dell’ex esecutivo per la sicurezza Jan Leike, hanno sollevato preoccupazioni sulla priorità e sul impegno della società per la sicurezza nel sviluppo dell’intelligenza artificiale generale.

Sutskever, che aveva giocato un ruolo chiave nell’ouster del CEO Sam Altman l’anno scorso, ha annunciato la sua dimissioni il 14 maggio, citando la sua voglia di concentrarsi su un nuovo progetto.

Leike, che era stato un critico vocale delle priorità di OpenAI, ha lasciato la società il 17 maggio, esprimendo preoccupazioni sulla mancanza di enfasi sulla sicurezza e sui rischi potenziali associati all’AGI.

In un suo post su X del 17 maggio, Leike ha affermato : “Sono stato in disaccordo con la leadership di OpenAI riguardo alle priorità fondamentali dell’azienda per un bel po’ di tempo, finché non abbiamo finalmente raggiunto un punto di rottura”.

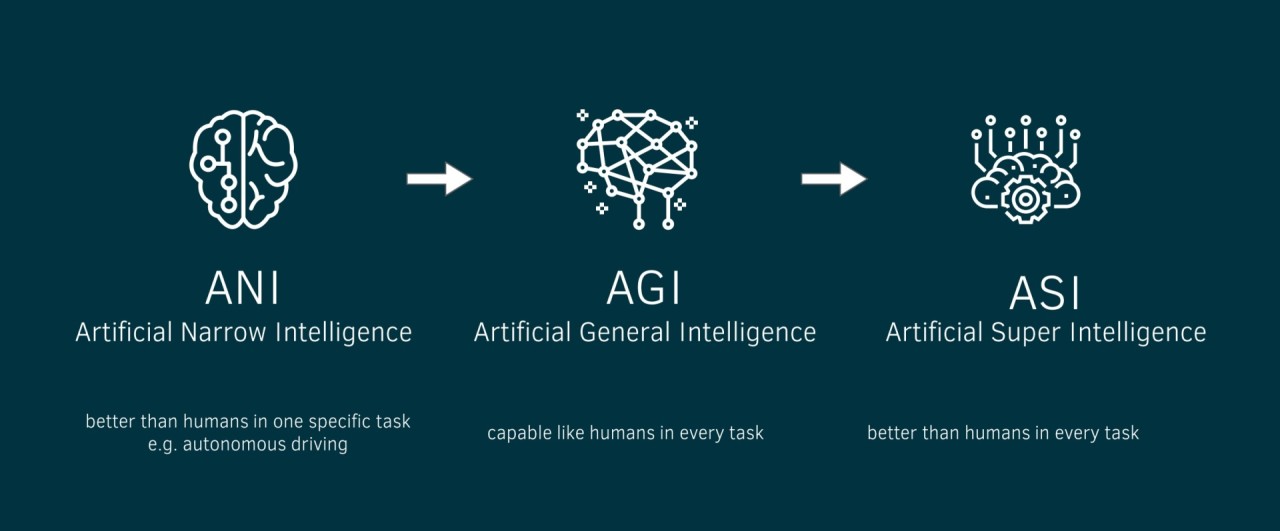

Alla cultura e ai processi della sicurezza non è stata data la priorità necessaria, soprattutto per quanto riguarda l’intelligenza artificiale generale, un tipo di intelligenza artificiale che può potenzialmente superare le capacità umane in un’ampia varietà di compiti.

“Siamo attesi da tempo nel prendere incredibilmente sul serio le implicazioni dell’AGI”, “OpenAI deve diventare un’azienda AGI che mette al primo posto la sicurezza”

Lake

In un post firmato sabato da Altman e Stockman hanno riconosciuto i rischi e i benefici dell’AGI e hanno sottolineato il loro impegno a concentrarsi i benefici potenziali mentre mitigano i rischi. Hanno anche evidenziato i loro sforzi per sviluppare una maggiore comprensione delle implicazioni dell’AGI e per informare il percorso futuro attraverso la ricerca empirica.

“Abbiamo ripetutamente dimostrato le incredibili possibilità derivanti dall’incremento del deep learning e ne abbiamo analizzato le implicazioni; abbiamo chiesto una governance internazionale dell’AGI prima che tali appelli diventassero popolari; e abbiamo contribuito a fare da pionieri nella scienza della valutazione dei sistemi di intelligenza artificiale per rischi catastrofici”

Altman e Stockman

Le partenze di Sutskever e Leike avvengono in un momento in cui OpenAI sta spingendo i confini delle capacità AI, compresa la recente pubblicazione del modello GPT-4. La missione della società è assicurare la creazione di un’AGI che benefici la umanità, e i recenti cambiamenti di leadership possono segnalare una svolta nella priorità e nell’approccio della società per raggiungere questo obiettivo.

“Non esiste una guida comprovata su come percorrere il percorso verso l’AGI”, . “Riteniamo che la comprensione empirica possa aiutare a definire la via da seguire. Crediamo sia nella necessità di ottenere enormi risultati positivi sia nel lavorare per mitigare i gravi rischi; prendiamo molto sul serio il nostro ruolo qui e valutiamo attentamente il feedback sulle nostre azioni

hanno aggiunto Altman e Stockman

L’investimento continuo di Microsoft in OpenAI, annunciato nel gennaio 2023, sottolinea la stabilità strategica e finanziaria della società. Tuttavia, le recenti partenze e le preoccupazioni sulla sicurezza possono sollevare domande sulla longevità del mission di OpenAI e sulla capacità della società di navigare il complesso e rapidamente evolvente panorama della ricerca e dello sviluppo AI.

Nel contesto del panorama AI più ampio, le partenze all’interno di OpenAI evidenziano i continui sfidi e le controversie che circondano lo sviluppo dell’AGI. Mentre le capacità AI continuano a evolvere, la necessità di una considerazione attenta dei rischi e dei benefici diventa sempre più pressante. Gli eventi recenti all’interno di OpenAI servono come rammemorazione dell’importanza di priorizzare la sicurezza e lo sviluppo responsabile nella ricerca di avanzamenti AI.

I recenti cambiamenti di leadership all’interno di OpenAI, inclusi le partenze di Sutskever e Leike, hanno sollevato preoccupazioni sulla priorità e sull’impegno della società per la sicurezza nel sviluppo dell’AGI. Mentre Altman e Brockman hanno sottolineato il loro impegno a consegnare i benefici potenziali dell’AGI mentre mitigano i rischi, gli eventi recenti evidenziano i continui sfidi e le controversie che circondano lo sviluppo dell’AGI.

Articoli Correlati :

Il cofondatore e capo scienziato di OpenAI Ilya Sutskever lascia l’azienda

Lascia un commento

Devi essere connesso per inviare un commento.