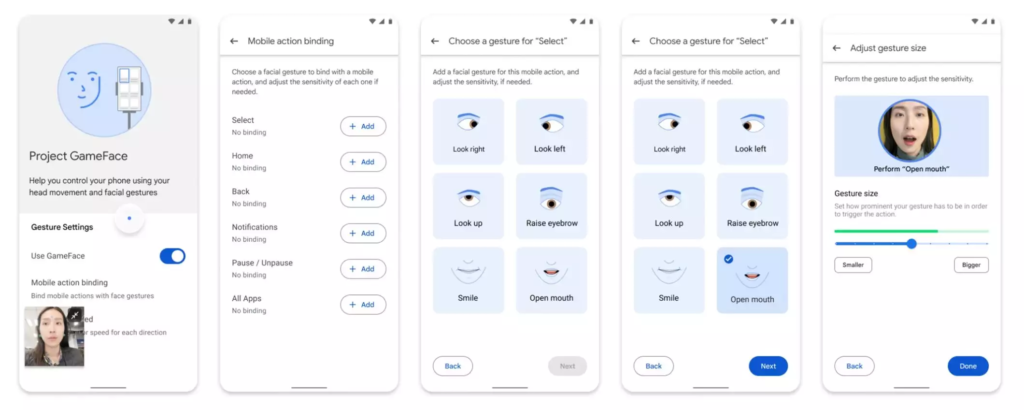

All’I/O 2023 Google ha lanciato Project Gameface , un “mouse” da gioco open source a mani libere che consente alle persone di controllare il cursore di un computer utilizzando il movimento della testa e i gesti facciali. Le persone possono alzare le sopracciglia per fare clic e trascinare o aprire la bocca per spostare il cursore, rendendo il gioco più accessibile.

il Videocita la collaborazione con Incluzza, società indiana che supporta persone con disabilità, insieme stanno studiando come il progetto possa essere esteso a contesti educativi e lavorativi.

Questo rappresenta un avanzamento significativo nell’integrazione delle funzionalità di accessibilità all’interno delle app. Permette a persone come lo streamer quadriplegico Lance Carr, e non solo, di controllare il cursore del PC con il movimento della testa e di eseguire azioni tramite espressioni facciali.

Per le persone che hanno difficoltà ad utilizzare una tastiera, sia fisica che virtuale, Google ha introdotto una nuova modalità non testuale che si chiama “look to speak” (guarda per parlare). Questa funzione consente di selezionare e inviare emoji semplicemente con lo sguardo, senza la necessità di digitare o scrivere.

Google ha creato diversi strumenti per aiutare le persone con problemi di vista. Questi strumenti usano la fotocamera del telefono per riconoscere oggetti, luoghi e persone, e fornire descrizioni immediate. Ora è possibile aggiungere il riconoscimento di oggetti o luoghi personalizzati, così le descrizioni sono più precise.

La funzione Eye Tracking, basata sull’intelligenza artificiale, sarà inclusa di serie e permetterà di controllare iPad e iPhone usando soltanto gli occhi. È stata sviluppata pensando a chi ha una disabilità fisica, e usa la fotocamera frontale per completare in pochi secondi la configurazione e la calibrazione. Inoltre, grazie al machine learning on-device, tutti i dati utilizzati per configurare e controllare questa funzione restano al sicuro sul dispositivo e non vengono condivisi con Apple. Anche Apple e Microsoft hanno rilasciato funzioni simili, mostrando l’impegno del settore tecnologico verso l’accessibilità e l’inclusività.

La funzione Eye Tracking, basata sull’intelligenza artificiale, sarà inclusa di serie e permetterà di controllare iPad e iPhone usando soltanto gli occhi. È stata sviluppata pensando a chi ha una disabilità fisica, e usa la fotocamera frontale per completare in pochi secondi la configurazione e la calibrazione. Inoltre, grazie al machine learning on-device, tutti i dati utilizzati per configurare e controllare questa funzione restano al sicuro sul dispositivo e non vengono condivisi con Apple.

Music Haptics consente alle persone sorde o ipoudenti di “sentire” la musica su iPhone in un modo nuovo. Quando attivata, il Taptic Engine di iPhone riproduce colpi, texture sonore e vibrazioni sottili di una canzone. È compatibile con milioni di brani di Apple Music e sarà disponibile come API per rendere la musica più accessibile nelle app.

Google ha confermato che Project Gameface ora è diventato open source e può essere utilizzato per controllare lo smartphone col viso.

Inoltre

Newsletter – Non perderti le ultime novità sul mondo dell’Intelligenza Artificiale. Iscriviti alla newsletter di Rivista.AI e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

Lascia un commento

Devi essere connesso per inviare un commento.