Nonostante tutti i suoi vantaggi potenzialmente trasformativi, l’intelligenza artificiale generativa comporta anche rischi significativamente diversi da quelli che vediamo con il software tradizionale. Questi documenti guida non solo informeranno i creatori di software su questi rischi unici, ma li aiuteranno anche a sviluppare modi per mitigare i rischi sostenendo al contempo l’innovazione

Sottosegretario al Commercio per gli standard e la tecnologia e direttore del NIST Laurie E. Locascio

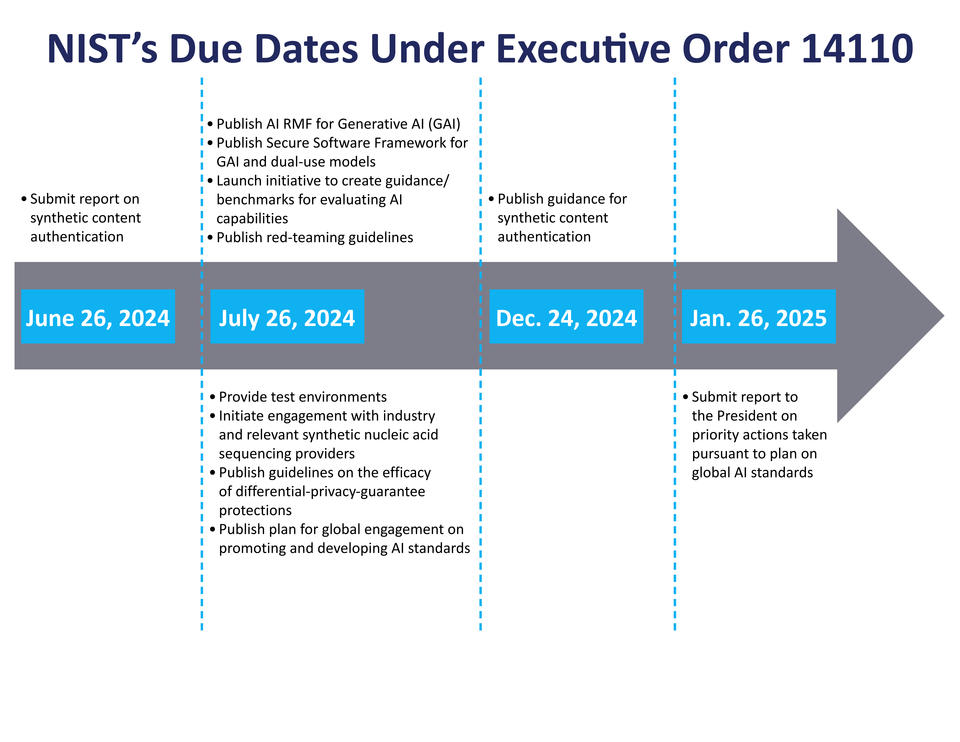

Il Dipartimento del Commercio degli Stati Uniti ha annunciato, dopo 180 giorni dall’Ordine Esecutivo (EO) del Presidente Biden sullo sviluppo sicuro e affidabile dell’IA , diversi nuovi annunci relativi all’EO. Il National Institute of Standards and Technology (NIST) del dipartimento ha pubblicato quattro bozze di pubblicazioni destinate a contribuire a migliorare la sicurezza, la protezione e l’affidabilità dei sistemi di intelligenza artificiale (AI).

l NIST ha inoltre lanciato una serie di sfide che supporteranno lo sviluppo di metodi per distinguere tra contenuti prodotti da esseri umani e contenuti prodotti dall’intelligenza artificiale.

Oltre alle pubblicazioni del NIST, l’Ufficio brevetti e marchi degli Stati Uniti (USPTO) del commercio sta pubblicando una richiesta di commento pubblico (RFC) per chiedere feedback su come l’intelligenza artificiale potrebbe influenzare le valutazioni di come il livello delle competenze ordinarie nelle arti viene effettuato per determinare se un’invenzione è brevettabile ai sensi della legge statunitense e all’inizio di quest’anno ha pubblicato linee guida sulla brevettabilità delle invenzioni assistite dall’intelligenza artificiale.

Le pubblicazioni del NIST coprono vari aspetti della tecnologia dell’intelligenza artificiale:

i primi due sono documenti di orientamento progettati per aiutare a gestire i rischi dell’intelligenza artificiale generativa (la tecnologia che abilita chatbot e strumenti per la creazione di immagini e video basati su testo) e servono come risorse complementari all’AI Risk del NIST. Management Framework (AI RMF) e Secure Software Development Framework (SSDF) , rispettivamente.

Il rapporto del NIST sulla “ Riduzione dei rischi posti dai contenuti sintetici ” fornisce una panoramica degli approcci tecnici alla “trasparenza dei contenuti digitali” o al processo di documentazione e accesso alle informazioni sull’origine e la storia dei contenuti digitali.

Di gran lunga il rapporto più lungo, adotta un approccio su quattro fronti per gestire e ridurre i rischi dei contenuti sintetici, tra cui:

- Attestare che un particolare sistema ha prodotto un contenuto

- Affermazione della proprietà dei contenuti

- Fornire strumenti per etichettare e identificare i contenuti generati dall’intelligenza artificiale

- Mitigare la produzione e la diffusione di materiale pedopornografico (CSAM) e di immagini intime non consensuali (NCII) generate dall’intelligenza artificiale di individui reali.

il quarto propone Il “ Piano per l’impegno globale sugli standard di intelligenza artificiale ” richiede uno sforzo coordinato per collaborare con i principali alleati e partner internazionali e con le organizzazioni che sviluppano standard per creare e implementare standard di consenso relativi all’intelligenza artificiale. Il Piano spiega che gli standard sono cruciali sia nello sviluppo che nell’adozione di tecnologie nuove ed emergenti, in particolare nel campo dell’intelligenza artificiale, dove gli attori internazionali guardano all’ecosistema degli standard come guida. Il NIST ritiene che il suo ruolo, almeno in questa fase, sia quello di affrontare le attività prima, durante e dopo la creazione di uno standard formale.

Tecnologia dell’informazione , intelligenza artificiale , misurazione e valutazione dell’intelligenza artificiale e intelligenza artificiale affidabile e responsabile

Lascia un commento

Devi essere connesso per inviare un commento.