Come dico da decenni sebbene non disponga di una sfera di cristallo per prevedere il futuro con assoluta certezza, posso fornire approfondimenti e analisi basati sulle tendenze e sugli sviluppi attuali nel campo dell’intelligenza artificiale.

Pubblichiamo in un articolo quanto apparso nel nostro white paper nel caso non lo aveste letto.

Mentre ci avviciniamo alla fine dei primi quattro mesi del 2024, è probabile che alcune macrotendenze continuino ad accelerare il ritmo del cambiamento nell’IA applicata. Sono:

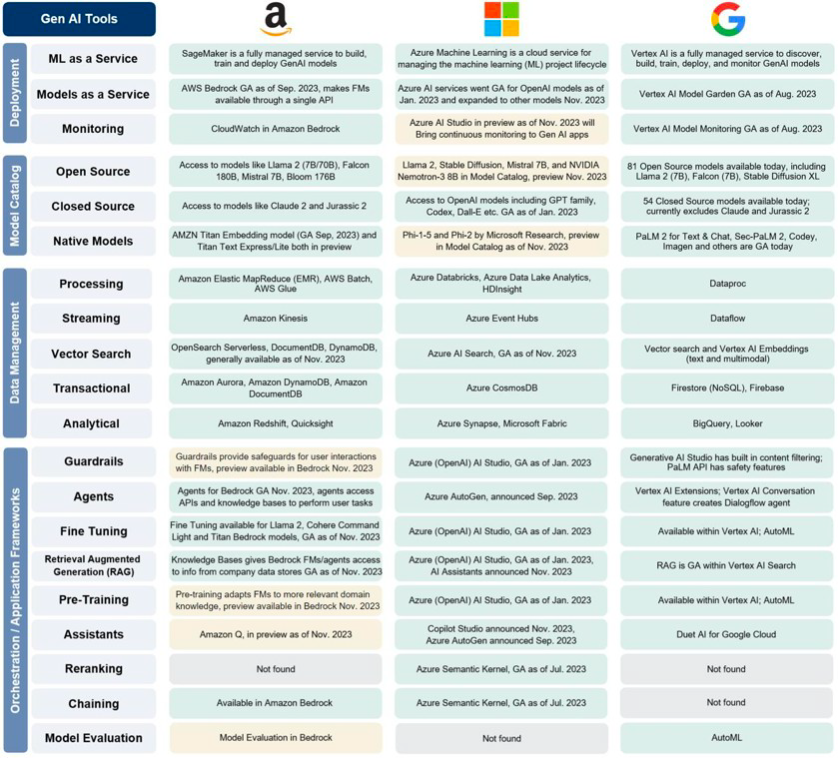

Oltre alle più ampie piattaforme di modelli come servizio, RAG, LoRA, il prompt engineering e altre forme di personalizzazione e personalizzazione dei modelli stanno diventando comuni. Ci saranno molte variazioni su questi strumenti nel prossimo anno.

I creatori di applicazioni stanno realizzando prototipi tramite prompt su modelli all’avanguardia ma costosi di OpenAI, quindi effettuando la messa a punto e le integrazioni su un modello a costo inferiore (spesso open source).

Vediamo anche l’evoluzione del prompt engineering verso una piattaforma per sviluppatori. Nello specifico, gli sviluppatori programmeranno in modo dichiarativo e le funzioni simili al compilatore tradurranno queste attività, SLA e garanzie I/O in prompt ottimizzati.

Models-as-a-Service presentata da Microsoft e simile ad AWS Bedrock. All’inizio dell’anno, abbiamo posto la nostra fiducia nella vastità dei modelli, in particolare quelli Open Source, nell’emergere del “middleware” di intelligenza artificiale e nella possibilità per le aziende storiche di software SAAS di potenziare rapidamente i loro prodotti con GenAI. Queste aspettative hanno trovato conferma nel mondo degli affari. Innovazioni chiave come LoRA, RAG e l’ingegneria dei prompt, che all’epoca erano appena comprese dal punto di vista commerciale, hanno guadagnato terreno. Oltre a questi grandi player del cloud, ci aspettiamo che Nvidia e aziende emergenti come HuggingFace e OctoML svolgano ruoli sempre più strategici nell’orchestrare i livelli dello stack AI per potenziare le applicazioni intelligenti.

Il cloud continua ad espandersi : Credo che la quota di mercato dell’infrastruttura cloud sia molto importante nell’intelligenza artificiale generativa, perché gli algoritmi di apprendimento automatico per l’intelligenza artificiale genuina non creano informazioni dal nulla. Invece, la qualità dell’intelligenza artificiale generativa si sviluppa in larga misura dal numero di diversi scenari di addestramento e iterazioni che l’algoritmo di apprendimento automatico deve affrontare. Detto questo, AWS detiene una quota di mercato quasi tre volte maggiore di Google Cloud, significa che gli algoritmi di machine learning di Amazon hanno accesso a set di dati quasi tre volte più grandi. Lo stesso vale per il confronto con Azure di Microsoft, con una quota di mercato due volte superiore a quella di Google Cloud.

ChatGPT di OpenAI (supportato da Microsoft) è un’apparente superstar dell’intelligenza artificiale generativa e di gran lunga il chatbot più utilizzato . Ciò che è importante qui è che ora funziona come un effetto valanga: più utenti con argomenti diversi interagiscono con il chatbot, più a fondo vengono addestrati i suoi algoritmi e migliore diventa nel tempo la qualità delle risposte del chatbot. È simile alla regola delle 10mila ore per qualcuno che padroneggia un’abilità, e OpenAI sembra essere lo studente più laborioso della classe. Circolano voci secondo cui nei prossimi mesi potrebbe essere rilasciata la nuova versione GPT-5 del chatbot, il che significa che probabilmente verranno introdotte nuove funzionalità sofisticate. Tutti questi sviluppi positivi con ChatGPT migliorano il potenziale tecnologico di tutte le offerte di Microsoft, e in particolare delle soluzioni cloud. Essendo uno dei primi investitori in OpenAI, Microsoft ha accesso esclusivo al codice GPT ed è in grado di integrare le funzionalità del chatbot con i suoi servizi.

L’adozione globale dell’intelligenza artificiale generativa è ancora agli inizi, con solo una piccola percentuale di aziende attualmente in fase di espansione (Lo studio “BCG AI Radar: From Potential to Profit with GenAI”).

Ciò è dovuto a vari fattori, tra cui la complessità della tecnologia, considerazioni etiche e di sicurezza e implicazioni sulla forza lavoro i costi e una workforce non digitale. Le aziende stanno adottando un approccio cauto, studiando la tecnologia e il suo impatto da tutti gli angoli prima di effettuare investimenti significativi .

I grandi produttori di software applicativi come Microsoft, Salesforce e Adobe hanno gia’ iniziato a incorporare l’AI generativa nelle loro soluzioni software (ad esempio Microsoft Copilot, Adobe Firefly e Einstein GPT di Salesforce). Sulla base delle funzionalita’ aggiuntive offerte dall’AI generativa, Microsoft ha posto il prezzo di 365 Copilot a 30 dollari al mese per utente, mentre Adobe ha aumentato la tariffa per il suo Creative Cloud di circa l’8%.

Ci sono stati progressi significativi nei modelli di intelligenza artificiale, con aziende come Anthropic che hanno rilasciato Claude1, Claude2 e Claude3 e OpenAI che si prepara a lanciare GPT5.

Questi modelli rappresentano un significativo passo avanti nelle capacità dell’intelligenza artificiale, offrendo prestazioni e funzionalità migliorate. Notevoli sono anche le offerte di Google Gemini 1.5 Pro e Meta AI.

Questi sviluppi evidenziano il rapido ritmo dell’innovazione nel campo dell’intelligenza artificiale. Interesante l’evoluzione del prompt engineering verso un Tranlator prompt engineering per essere utilizzato con piu’ modelli disponibili.

Maggiore attenzione all’etica e alla regolamentazione: man mano che l’intelligenza artificiale diventa sempre più diffusa, cresce l’attenzione sulle implicazioni etiche dell’intelligenza artificiale e sulla necessità di regolamentazione. Ciò include questioni come i pregiudizi negli algoritmi di intelligenza artificiale, le preoccupazioni sulla privacy e l’impatto dell’intelligenza artificiale sui posti di lavoro. Gli organismi di regolamentazione stanno lavorando per stabilire quadri per affrontare questi problemi.

Nell’articolo “L’urgenza di un’algoretica” di P. Benanti, l’autore sottolinea l’importanza di affrontare le sfide etiche poste dall’intelligenza artificiale e dagli algoritmi. L’articolo discute l’urgente necessità di un quadro che possa guidare lo sviluppo e la diffusione dell’intelligenza artificiale in modo etico, giusto e rispettoso dei diritti umani.

P. Benanti sostiene che, man mano che l’intelligenza artificiale diventa sempre più integrata in vari aspetti della società, è fondamentale garantire che sia progettata e utilizzata in modo da promuovere il bene comune e non esacerbare le disuguaglianze esistenti o crearne di nuove.

Ascensione dell’AI-as-a-Service: l’AI-as-a-Service (AIaaS) è diventata una tendenza popolare, con le aziende che offrono funzionalità di intelligenza artificiale in base al pagamento in base all’uso. Ciò consente alle aziende di sfruttare l’intelligenza artificiale senza la necessità di investimenti iniziali significativi o competenze interne.

Costi e BM. Data la complessità di stimare l’impatto iniziale dei casi d’uso su larga scala a causa del modello di utilizzo basato su token, le aziende dovranno considerare attentamente quando utilizzare il pagamento aziendale -soluzioni utente rispetto a quelle basate su token. Questa decisione dipenderà da vari fattori, tra cui l’adozione prevista e il caso d’uso.

Questo argomento è particolarmente rilevante poiché la maggior parte degli utenti trova difficile prevedere e programmare il modello di utilizzo basato su token.

Nel 2024, è probabile che emerga una “gerarchia dei dati” in cui i dati Internet saranno ampiamente accessibili, i dati specifici del dominio saranno monetizzabili direttamente o indirettamente e i dati dell’azienda/cliente saranno sfruttati per un uso su misura e personalizzato.I

l mondo dell’intelligenza artificiale applicata si sta evolvendo così rapidamente che identificare il modello di business vincente richiederà curiosità, iterazione e agilità Per dare un’idea dei costi e collegarlo al tema delle performance, il costo delle chiamate ad Anthropic varia da 0,25$ a 15$ per MTok. GPT-4 si aggira intorno ai 10$ per MTok, mentre Claude3 Opus promette prestazioni più avanzate.

Man mano che gli operatori storici combinano l’intelligenza artificiale con il software esistente e i clienti richiedono un ROI chiaro per i dollari incrementali che stanno pagando per l’intelligenza artificiale per migliorare i processi aziendali o la produttività del team si avra’ un po di Tensione.

C’e’ un Interessante Articolo sulla Computer Vision da parte del MIT (Beyond AI Exposure: Which Tasks are Cost-Effective to Automate with

Computer Vision?) su quali Tasks meriterebbero una Automazione.

Integrazione dell’intelligenza artificiale nei processi aziendali: sempre più aziende stanno integrando l’intelligenza artificiale nei propri processi aziendali, utilizzandola per automatizzare le attività, migliorare il processo decisionale e migliorare l’esperienza dei clienti. Ciò ha portato ad una maggiore efficienza e competitività.

Vendors Lock-In. Data la rapida evoluzione della tecnologia dell’intelligenza artificiale, è fondamentale per le aziende evitare di legare la propria architettura a un unico modello linguistico di grandi dimensioni (LLM) o a soluzioni specifiche. La configurazione ottimale di una soluzione di intelligenza artificiale generativa dipenderà da vari fattori, tra cui il caso d’uso specifico, le prestazioni previste e i costi. Le aziende dovrebbero puntare alla flessibilità nella loro architettura AI per accogliere progressi e cambiamenti futuri.

All’improvviso, “open source” è l’ultima parola d’ordine nei circoli dell’intelligenza artificiale. Meta si è impegnata a creare un’intelligenza generale artificiale open source. Ed Elon Musk sta facendo causa a OpenAI per la sua mancanza di modelli di intelligenza artificiale open source.

Nel frattempo, un numero crescente di leader e aziende tecnologiche si stanno affermando come campioni dell’open source. Ma c’è un problema fondamentale: nessuno è d’accordo su cosa significhi “AI open source”.

Lo scorso luglio, Meta ha reso disponibile gratuitamente il suo modello Llama 2, che ha definito open source, e ha una lunga esperienza nel rilascio pubblico di tecnologie di intelligenza artificiale. “Sosteniamo lo sforzo dell’OSI per definire l’IA open source e non vediamo l’ora di continuare a partecipare al loro processo a beneficio della comunità open source in tutto il mondo”, Jonathan Torres, consulente generale associato di Meta per AI, open source e licenze ci ha detto.

Ciò è in netto contrasto con il rivale OpenAI, che nel corso degli anni ha condiviso sempre meno dettagli sui suoi modelli di punta, citando problemi di sicurezza. “Renderiamo open source potenti modelli di intelligenza artificiale solo dopo aver valutato attentamente i vantaggi e i rischi, inclusi l’uso improprio e l’accelerazione”, ha affermato un portavoce.

Anche altre importanti società di intelligenza artificiale, come Stability AI e Aleph Alpha, hanno rilasciato modelli descritti come open source e Hugging Face ospita un’ampia libreria di modelli di intelligenza artificiale disponibili gratuitamente.

Mentre Google ha adottato un approccio più bloccato con i suoi modelli più potenti, come Gemini e PaLM 2, i modelli Gemma rilasciati il mese scorso sono liberamente accessibili e progettati per confrontarsi con Llama 2, anche se la società li ha descritti come “aperto” piuttosto che “open source”.

Ma c’è un notevole disaccordo sul fatto che qualcuno di questi modelli possa davvero essere descritto come open source. Tanto per cominciare, sia Llama 2 che Gemma sono dotati di licenze che limitano ciò che gli utenti possono fare con i modelli. Questo è un anatema per i principi open source: una delle clausole chiave della Open Source Definition vieta l’imposizione di qualsiasi restrizione basata sui casi d’uso.

I traduttori svolgeranno un ruolo cruciale nel convertire le richieste per adattarle a diversi LLM senza perdere la logica aziendale integrata. Ciò consentirà alle aziende di passare da un LLM all’altro secondo necessità, a seconda dei requisiti specifici del loro caso d’uso.

Grounding Sarà essenziale tenere traccia di come ciascun LLM è stato modificato e con quali set di dati, in particolare durante la messa a terra. Un ulteriore passo sarà lo sviluppo di strumenti in grado di rilevare se i processi di prompt o di inferenza compromettono l’integrità del LLM originale, fungendo da sorta di filtro guardiano.

Monitorare come ciascun LLM è stato modificato e con quali set di dati è un’altra considerazione importante, soprattutto quando si tratta di messa a terra. Il grounding si riferisce alla capacità di un modello di basare le proprie risposte o azioni su informazioni concrete, verificabili e rilevanti. Esistono molti modi per ottenere il grounding e le aziende dovranno decidere quando e come implementarlo in base alle loro esigenze e requisiti specifici. Poiché esistono numerosi modi per raggiungere il grounding, sarà necessario decidere quando e come implementarlo, ad esempio se fermarsi al RAG o andare oltre.

Sicurezza. L’integrazione di Large Language Models (LLM) nelle piattaforme online rappresenta un’arma a doppio taglio, offrendo esperienze utente migliorate ma introducendo anche vulnerabilità di sicurezza. La gestione non sicura degli output è una preoccupazione importante, in quanto una validazione o sanificazione insufficiente degli output LLM può portare a una serie di exploit come cross-site scripting (XSS) e cross-site request forgery (CSRF).

Il prompt injection indiretto aggrava ulteriormente questi rischi, consentendo agli aggressori di manipolare le risposte LLM attraverso fonti esterne come dati di training o chiamate API, compromettendo potenzialmente le interazioni degli utenti e l’integrità del sistema. Inoltre, l’avvelenamento dei dati di addestramento rappresenta una minaccia significativa, poiché i dati compromessi utilizzati nell’addestramento dei modelli possono comportare la diffusione di informazioni inaccurate o sensibili, minando la fiducia e la sicurezza. Quindi ulteriore avanzamento sara’ la presenza di Tools Guadiani in grado di intercettare il Prompting.

Altro “guardiano” dove si sta’ investendo e’ quello dell’inferenza sicura che mira ad aggiungere un livello di protezione alle conversazioni riservate con i modelli di intelligenza artificiale. Consideralo un canale di comunicazione sicuro, garantendo che solo le parti autorizzate possano ascoltare i tuoi sussurri e la risposta della modella. Le tecniche sono quelle della Crittografia omomorfa, Secure Multi-Party Computing (SMPC) ,Privacy differenziale.

L’ imminente introduzione dell’AIACT (legge sull’intelligenza artificiale) nell’UE potrebbe avere implicazioni significative per l’adozione e l’uso della tecnologia dell’intelligenza artificiale. La legge mira a stabilire un quadro giuridico per l’intelligenza artificiale, affrontando questioni quali sicurezza, trasparenza e responsabilità. Le aziende dovranno garantire il rispetto delle nuove normative, che potrebbero influenzare le loro strategie e i loro investimenti in intelligenza artificiale.

In conclusione, il panorama dell’intelligenza artificiale generativa è in rapida evoluzione e le aziende devono affrontarlo con flessibilità e una comprensione completa degli impatti della tecnologia. Dovrebbero inoltre considerare attentamente la scelta delle soluzioni di intelligenza artificiale e dei modelli di prezzo in relazione ai loro casi d’uso specifici e agli scenari di adozione.

Newsletter AI – non perderti le ultime novità sul mondo dell’Intelligenza Artificiale, i consigli sui tool da provare, i prompt e i corsi di formazione. Iscriviti alla newsletter settimanale e accedi a un mondo di contenuti esclusivi direttamente nella tua casella di posta!

Lascia un commento

Devi essere connesso per inviare un commento.