Gli analisti continuano a esprimere un crescente ottimismo riguardo alle opportunità di sicurezza offerte da Microsoft Copilot.

Questo si deve principalmente alla percezione di una forte adattabilità dell’intelligenza artificiale generativa nel contesto della sicurezza informatica. Le capacità di generazione di codice, riconoscimento di modelli e riparazione automatizzata di Copilot sono state individuate come elementi chiave che lo distinguono nel mercato della sicurezza. Inoltre, la capacità di apprendimento continuo e di adattamento alle minacce emergenti sta rafforzando ulteriormente la fiducia degli analisti nel potenziale di Copilot per migliorare la resilienza e l’efficacia delle difese digitali

A questo proposito J.P. Morgan ha affermato che il chatbot di intelligenza artificiale Copilot for Security di Microsoft sta determinando un cambio di paradigma nelle capacità di sicurezza del colosso tecnologico, riportamo il Transcript :

“Consideriamo la profondità dell’attenzione e della discussione sull’intelligenza artificiale durante l’evento di punta sulla sicurezza di Microsoft come un chiaro messaggio sul livello di impatto che questa tendenza tecnologica potrebbe avere sull’avanzamento della differenziazione di Microsoft nel mercato, con chiare opportunità di beneficiare del consolidamento dei fornitori IT mentre incorpora questi strumenti in tutto il suo stack tecnologico”, ha affermato un team di analisti guidati da Mark Murphy.

Gli analisti hanno sottolineato che la monetizzazione di questi prodotti, simile ad altri strumenti Copilot, seguirà un modello graduale nelle prime fasi, ma si prevede che subirà un significativo aumento nell’adozione in futuro.

La sede di Microsoft a Redmond, nello stato di Washington, ha annunciato mercoledì che lo strumento Copilot for Security sarà disponibile in versione “generale” a partire dal 1° aprile, con una serie di nuove funzionalità. Questo servizio consentirà ai professionisti della sicurezza informatica di sfruttare l’intelligenza artificiale generativa per svolgere attività come il riepilogo degli incidenti, l’analisi delle vulnerabilità e la condivisione delle informazioni sensibili.

Secondo un rapporto di Verge, l’azienda addebiterà alle aziende un costo di 4 dollari all’ora di utilizzo come parte di un modello di consumo aaS.

Questo approccio tariffario potrebbe favorire una maggiore adozione, permettendo alle aziende di pagare solo per l’uso effettivo del servizio, senza investimenti iniziali eccessivi.

Sempre in questi giorni Microsoft ha confermato che il modello linguistico di grandi dimensioni (LLM)

GPT-4 Turbo di OpenAI è ora disponibile per gli utenti gratuiti di Copilot, il suo assistente basato sull’IA

Le novita’ :

GPT-4 Turbo è più capace e ha conoscenze sugli eventi mondiali fino ad aprile 2023. Ha una finestra di contesto di 128k, quindi può contenere l’equivalente di più di 300 pagine di testo in un’unica richiesta. Ottimizzato le sue prestazioni, a un prezzo tre volte più basso per i token di input e a un prezzo due volte più basso per i token di output rispetto a GPT-4.

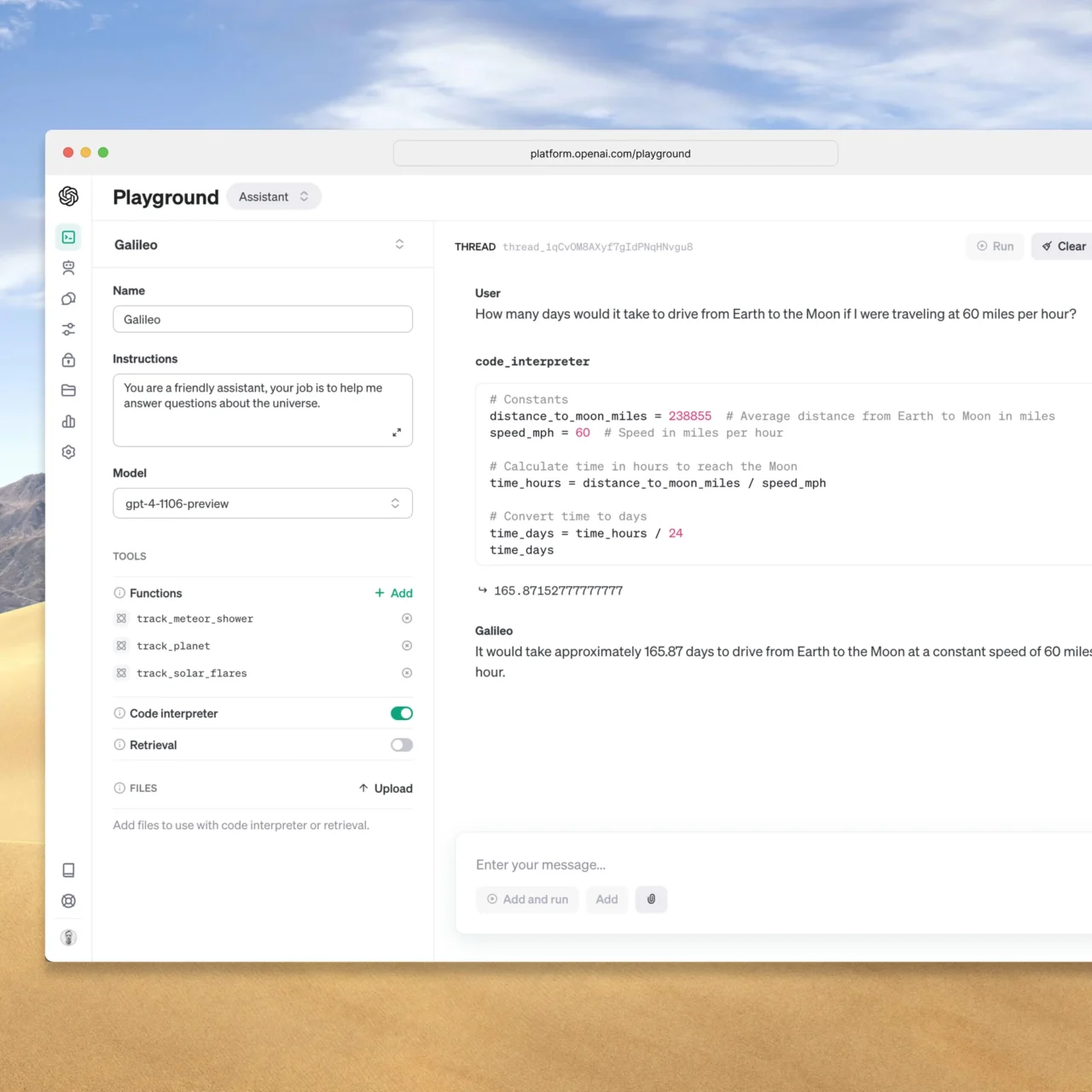

GPT-4 Turbo è disponibile per tutti gli sviluppatori paganti da provare passando gpt-4-1106-preview nell’API e MSFT prevede di rilasciare il modello stabile pronto per la produzione nelle prossime settimane.

Aggiornamenti per la chiamata di funzioni

La chiamata di funzioni consente di descrivere le funzioni della tua app o delle API esterne ai modelli e di far scegliere al modello in modo intelligente di restituire un oggetto JSON contenente gli argomenti per chiamare quelle funzioni.

Con diversi miglioramenti oggi, tra cui la possibilità di chiamare più funzioni in un’unica richiesta: gli utenti possono inviare un’unica richiesta per più azioni, come ad esempio “aprire il finestrino dell’auto e spegnere l’aria condizionata”, che prima richiederebbe più interazioni con il modello. Stiamo inoltre migliorando l’accuratezza della chiamata di funzioni: GPT-4 Turbo è più propenso a restituire i giusti parametri delle funzioni.

Miglioramento nell’ eseguire le istruzioni e JSON Mode

GPT-4 Turbo funziona meglio dei modelli precedenti nei compiti che richiedono la rigorosa esecuzione delle istruzioni, come generare formati specifici (ad esempio “rispondere sempre in XML”).

Supporta la nostra nuova modalità JSON, che garantisce che il modello risponderà con un JSON valido. Il nuovo parametro dell’API response_format consente al modello di limitare la sua output per generare un oggetto JSON sintatticamente corretto.

La modalità JSON è utile per gli sviluppatori che generano JSON nell’API Completions API al di fuori della chiamata di funzioni.

Output riproducibili e log probability

Il nuovo parametro seed consente output riproducibili rendendo il modello restituire completamenti consistenti nella maggior parte dei casi. Questa funzione beta è utile per casi d’uso come riprodurre richieste per il debug, scrivere test di unità più completi e avere generalmente un maggiore controllo sul comportamento del modello.

MSFT sta anche lanciando una funzione per restituire le probabilità di log per i token di output più probabili generati da GPT-4 Turbo e GPT-3.5 Turbo nelle prossime settimane, il che sarà utile per creare funzionalità come l’autocompletamento in un’esperienza di ricerca.

Lascia un commento

Devi essere connesso per inviare un commento.