A differenza di Microsoft , che consideriamo leader nell’intelligenza artificiale per software e servizi con una partnership esclusiva con OpenAI, a vantaggio delle opportunità di integrazione GPT-4 LLM e dell’infusione diffusa delle sue capacità di intelligenza artificiale nell’intero stack di prodotti, in particolare software di produttività e cloud , vediamo che Apple è relativamente in ritardo negli sviluppi dell’intelligenza artificiale e sembra che stia cercando di mettersi al passo con i concorrenti.

Ad esempio, OpenAI sviluppa il suo GPT LLM dal 2019. Microsoft ha sviluppato Copilot nel 2022 su GitHub e ha rilasciato altri Copilot per altri prodotti nel corso del 2023.

Inoltre, in passato Apple non ha fornito dettagli significativi sui suoi sviluppi legati all’intelligenza artificiale. Tuttavia, nel suo ultimo briefing sugli utili, il CEO Tim Cook ha dichiarato di ritenere che esista “un’enorme opportunità per Apple con GenAI e AI”.

Inoltre, il management ha sottolineato che si sta concentrando sullo sviluppo interno di prodotti sull’intelligenza artificiale generativa e prevede di ricevere ulteriori annunci entro la fine dell’anno dopo il lancio di Apple Vision Pro.

Sviluppi generali dei prodotti IA

Di seguito abbiamo spiegato alcune delle funzionalità dell’intelligenza artificiale lanciate da Apple e che sono in fase di sviluppo.

Apple Music: l’azienda ha introdotto Apple Discovery Station che sfrutta algoritmi di apprendimento automatico per identificare i modelli di ascolto dell’utente e generare una raccomandazione di playlist musicale personalizzata compilata per l’utente.

Deep Fusion: gli ultimi modelli di iPhone di Apple includono funzionalità come Deep Fusion, uno strumento che sfrutta l’apprendimento automatico per l’elaborazione dei pixel e l’ottimizzazione delle texture per migliorare la qualità delle foto. Funziona eseguendo 9 scatti multipli quando l’utente scatta una foto e il motore neurale di Apple analizza ogni scatto e seleziona ciascun pixel individualmente ottimizzato per dettagli più elevati e basso rumore, creando un’immagine di qualità superiore.

Ricerca visiva: inoltre, Apple dispone anche della funzione Ricerca visiva che rileva oggetti utilizzando le fotocamere dell’iPhone sfruttando le tecnologie di riconoscimento degli oggetti che raccolgono le caratteristiche di un oggetto che vengono estratte e recuperando informazioni da un database di caratteristiche simili per identificare l’oggetto e fornire approfondimenti su di esso.

Apple Watch: le funzionalità dello smartwatch Apple includono il rilevamento delle cadute e il rilevamento degli urti che utilizzano una serie di sensori, microfono e GPS installati nel dispositivo per dedurre la velocità e il posizionamento di chi lo indossa sulla base dei dati raccolti dai test condotti da Apple.

Siri: il noto assistente vocale Siri di Apple che dispone di tecnologie di riconoscimento vocale che utilizzano reti neurali profonde per convertire i modelli vocali della voce dell’utente e confrontarli con il suo database di suoni vocali per rilevare il discorso dell’utente.

Correzione automatica: Apple ha introdotto aggiornamenti alla sua funzione di correzione automatica che è più personalizzata poiché è alimentata da un modello Transformer AI che apprende gli schemi di testo dell’utente e prevede le parole o le frasi successive che ciascun utente potrebbe utilizzare.

Nel complesso, Apple ha introdotto e, secondo quanto riferito, sta sviluppando una gamma di funzionalità utilizzando l’intelligenza artificiale. Tuttavia, in base alla nostra raccolta di queste funzionalità, scopriamo che molti degli sviluppi dell’intelligenza artificiale di Apple sono stati l’integrazione dell’intelligenza artificiale di base nei loro prodotti, come funzionalità che consigliano consigli musicali, miglioramento della qualità delle foto, assistenti vocali, correzione automatica, rilevamento di incidenti e rilevamento di cadute.

Tutte queste funzionalità fanno parte dei prodotti sottostanti di Apple come iPhone, Mac e Apple Watch. Ad esempio, le funzionalità Deep Fusion e Visual Lookup di Apple nella fotocamera dell’iPhone, le funzionalità di rilevamento di incidenti e cadute di Apple Watch, la funzionalità di Apple Discovery Station per Apple Music e la correzione automatica e Siri su iPhone, Mac e iPad. Inoltre, il management di Apple ha anche sottolineato che l’azienda considera queste funzionalità di intelligenza artificiale come “parte integrante di praticamente ogni prodotto”.

Pertanto, riteniamo che ciò evidenzi che gli sviluppi di Apple sono stati mirati a migliorare in modo incrementale la propria offerta di prodotti piuttosto che a creare nuovi prodotti innovativi e rivoluzionari.

Ad esempio, Deep Fusion e Visual Lookup di Apple migliorano le capacità della fotocamera dell’iPhone, il rilevamento di incidenti e cadute come funzionalità di Apple Watch fornisce valore agli utenti per un migliore monitoraggio della sicurezza e della salute e Apple Discovery Station migliora l’esperienza dell’utente in Apple Music.

Crediamo che tutte queste innovazioni Apple siano generali e imitabili dai concorrenti. Ad esempio, Spotify ha già una funzionalità simile chiamata Spotify AI DJ per consigli musicali personalizzati per ciascun utente. I concorrenti di smartphone come Samsung dispongono anche di funzionalità AI per le foto, comprese tecnologie di deep learning per l’elaborazione multi-frame per migliorare la qualità dell’immagine e Scene Optimizer che ha la capacità di rilevamento degli oggetti.

Anche altri smartwatch Garmin (GRMN) e Samsung hanno funzionalità simili di rilevamento di urti e cadute. Pertanto, riteniamo che ciò supporti ulteriormente la nostra convinzione che queste funzionalità siano destinate a migliorare la sua attuale offerta di prodotti piuttosto che innovazioni reali.

Sviluppi innovativi di prodotti IA

Abbiamo esaminato alcune delle innovazioni AI uniche che l’azienda ha lanciato e che si dice abbia in fase di sviluppo, come Vision Pro e Xcode AI.

Nel gennaio 2024, Apple ha lanciato i suoi visori per realtà virtuale Vision Pro negli Stati Uniti e prevede un lancio internazionale quest’anno. Sulla base del briefing sugli utili dell’azienda, il management ha evidenziato due componenti di Vision Pro guidati dall’intelligenza artificiale: gli aspetti di mappatura e tracciamento delle mani del dispositivo.

In termini di mappatura, Apple pubblicizza Vision Pro come un “computer spaziale” e ha introdotto il calcolo spaziale, che consente ai dispositivi di apprendere e interagire con l’ambiente fisico.

Un concetto chiave in questo senso è la mappatura spaziale, un processo di ricostruzione 3D di una mappa dell’ambiente fisico. Questo processo prevede la raccolta di dati dall’ambiente fisico proiettando punti sugli oggetti utilizzando una sofisticata tecnologia di rilevamento della profondità che include sensori, fotocamere e LiDAR di cui è dotato Vision Pro.

I dati e le immagini vengono elaborati con algoritmi di visione artificiale in motori neurali dedicati nel chip M2 con capacità di accelerazione del calcolo della rete neurale che consentono un’elaborazione più rapida per il rilevamento di oggetti e immagini in tempo reale per creare una rappresentazione dell’ambiente fisico e l’analisi facciale del utente.

Inoltre, Vision Pro di Apple consente anche funzionalità di tracciamento delle mani e degli occhi che funzionano raccogliendo dati di input (gesti delle mani dell’utente) dalle fotocamere laterali, anteriori e inferiori dei dispositivi che catturano i gesti delle mani dell’utente e dai sensori a infrarossi che proiettano la luce. modelli sugli occhi e utilizza algoritmi di apprendimento automatico per elaborare i dati nel chip R1, consentendo la manipolazione e l’interazione con l’ambiente virtuale da parte dell’utente.

Sia le tecnologie di mappatura spaziale che quelle di tracciamento manuale e oculare consentono a Vison Pro di eseguire il rendering dell’ambiente fisico e di abilitare ulteriormente funzionalità come la modalità passthrough che sovrappone la realtà virtuale al mondo fisico, consentendo all’utente di interagire con entrambi senza problemi.

Secondo Bloomberg, Apple starebbe sviluppando strumenti di intelligenza artificiale nel suo software di programmazione, Xcode, che è lo strumento di sviluppo software ufficiale di Apple utilizzato “per creare app (progettare, sviluppare e pubblicare) per tutte le piattaforme Apple: iOS, iPadOS, tvOS, watchOS, e macOS”.

I presunti sviluppi dell’intelligenza artificiale in Xcode potrebbero aiutare gli sviluppatori di software nella codifica prevedendo e suggerendo righe di codice e convertendo codice da diversi linguaggi di programmazione, il che potrebbe consentire agli sviluppatori di terze parti di risparmiare tempo. Si dice che lo strumento condivida somiglianze nelle funzionalità di Microsoft GitHub Copilot, che abbiamo precedentemente trattato nella nostra analisi Microsoft come assistente AI che aiuta i programmatori a risparmiare tempo e aumentare la produttività, quindi crediamo che Apple stia cercando di fare qualcosa di simile al Copilot di Microsoft che aveva è stato lanciato nel 2022 con oltre 1 miliardo di utenti paganti nel 2023 e abbiamo stimato che genererà un’opportunità di entrate di 6,6 miliardi di dollari entro il 2028.

Tuttavia, il modello di entrate di Xcode è diverso in quanto è una piattaforma open source gratuita per sviluppatori di software e non genera entrate direttamente per Apple. Tuttavia, gli sviluppatori possono aderire all’Apple Developer Program che fornisce strumenti e risorse aggiuntivi per creare app nell’ecosistema Apple e che prevede una tariffa annuale di $ 99 all’anno.

Pertanto, riteniamo che gli sviluppi dell’intelligenza artificiale non genererebbero entrate direttamente per Apple ma potrebbero aumentare la competitività dell’Apple Developer Program. Riteniamo che potrebbe anche aiutare gli sviluppatori a ridurre il tempo necessario per sviluppare app sull’ecosistema Apple, avvantaggiando Apple con una maggiore ampiezza dell’AppStore, aumentando così gli acquisti sull’App Store per generare maggiori entrate da commissioni per Apple.

Nel complesso, riteniamo che Apple stia sfruttando l’intelligenza artificiale principalmente per migliorare le capacità generali dei suoi prodotti e servizi esistenti. Abbiamo evidenziato i suoi sviluppi sull’intelligenza artificiale che riteniamo siano solo sviluppi generali sull’intelligenza artificiale per migliorare le attuali offerte di prodotti dell’azienda in una misura che potrebbe mantenere l’azienda al passo con i concorrenti, come le funzionalità di intelligenza artificiale nella fotocamera dell’iPhone, i consigli sulle playlist musicali, le funzionalità di rilevamento di sicurezza in caso di incidente e caduta. , correzione automatica e assistenti vocali migliorati.

Ciononostante, abbiamo anche identificato diverse innovazioni chiave relative all’intelligenza artificiale, vale a dire il visore Vision Pro lanciato di recente e le funzionalità AI di Xcode, secondo quanto riferito, in fase di sviluppo. Inoltre, secondo quanto riferito, Apple avrebbe sviluppato anche altri strumenti di intelligenza artificiale generativa come “Apple GPT”, un chatbot AI che potrebbe essere simile a quello di Microsoft Copilot (Bing Chat) e Google Gemini.

Tuttavia, Apple non ha ancora annunciato ulteriori dettagli sullo sviluppo di questo prodotto e ha tenuto solo un vertice sull’intelligenza artificiale nel febbraio 2023 per informare i dipendenti del suo LLM in sviluppo. Inoltre, si credeva che Apple stesse sviluppando un’auto a guida autonoma dal 2014, ma secondo quanto riferito Bloomberg l’ha cancellata, supportando così ulteriormente la nostra opinione secondo cui gli sviluppi dell’intelligenza artificiale di Apple sono più incentrati sul miglioramento della sua attuale offerta di prodotti piuttosto che su nuovi prodotti innovativi.

Fattori che potrebbero supportare il successo di Apple nell’intelligenza artificiale

A questo punto, esaminiamo se Apple potrebbe essere in grado di sfruttare i propri punti di forza nei suoi sviluppi innovativi di intelligenza artificiale esaminando fattori come gli sviluppi del modello di intelligenza artificiale, la base installata e l’ecosistema, la fedeltà dei clienti, il potere dei prezzi e Apple Silicon.

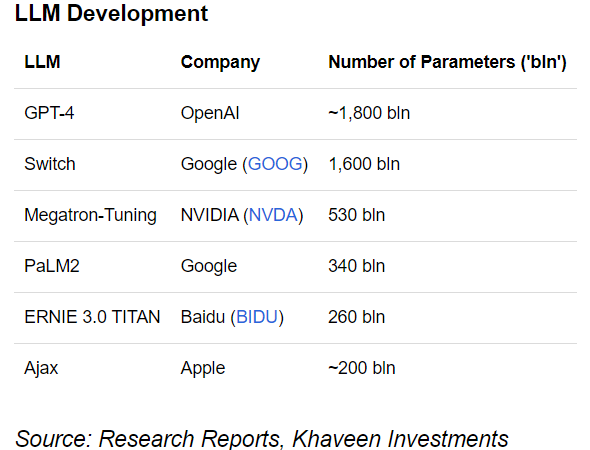

Secondo The Information, Apple sta sviluppando un proprio LLM addestrato con 200 miliardi di parametri. In confronto, abbiamo precedentemente evidenziato che i modelli GPT3.5 di OpenAI hanno 175 miliardi di parametri. Tuttavia, il nuovo modello GPT-4 di OpenAI lo supera con oltre un trilione di parametri e ha il punteggio benchmark MMLU più alto.

Inoltre, anche gli LLM Switch e PaLM2 di Google sono più grandi, rispettivamente con parametri di 1,6 tln e 340 mld. Inoltre, NVIDIA e Baidu hanno anche LLM con parametri più grandi di 340 milioni e 260 milioni. Pertanto, i parametri dichiarati da Apple di 200 miliardi impallidiscono rispetto a quelli della concorrenza, il che potrebbe indicare uno svantaggio, anche se Apple deve ancora fare un annuncio ufficiale.

Detto questo, gli sviluppi LLM di Apple coincidono con gli sviluppi dell’intelligenza artificiale generativa segnalati da Apple. Ad esempio, secondo quanto riferito, Apple sta sviluppando miglioramenti nelle funzionalità di Spotlight in iOS, uno strumento di ricerca integrato che consente agli utenti di navigare in diverse app e individuare documenti nonché eseguire ricerche online, con l’integrazione con LLM per generare risultati di ricerca più complessi e personalizzati. .

Secondo quanto riferito, Apple sta pianificando di migliorare Siri integrandolo con un LLM. Inoltre, Apple potrebbe sviluppare strumenti di intelligenza artificiale generativa in Keynote come immagini generate dall’intelligenza artificiale e diapositive di presentazione. Oltre a ciò, Apple ha anche rilasciato vari altri modelli di intelligenza artificiale come MLX che consente agli sviluppatori di addestrare modelli di intelligenza artificiale utilizzando i chip Apple Silicon e il suo modello di intelligenza artificiale da testo a immagine MGIE.

Nel complesso, riteniamo che lo sviluppo LLM di Apple potrebbe essere svantaggiato rispetto ai concorrenti sulla base dei parametri riportati del suo modello poiché è inferiore a quello di altri 5 LLM. Ciò è dovuto alla maggiore potenza computazionale dell’LLM dei suoi concorrenti in base al numero di parametri che abbiamo spiegato in precedenza si riferisce ai valori appresi dal modello AI durante la formazione e richiede risorse computazionali più elevate per LLM più grandi.

Inoltre, abbiamo evidenziato la tendenza all’aumento del fabbisogno di potenza di calcolo negli ultimi due decenni man mano che gli LLM diventano più grandi. Riteniamo che il più grande LLM, GPT-4, offra a Microsoft l’opportunità di sfruttarlo integrandosi con il suo stack di prodotti e servizi e aumentando la sua competitività. Inoltre, OpenAI sta già sviluppando il suo prossimo modello GPT-5 mentre Google ha recentemente rilasciato i suoi nuovi modelli Gemini.

Lascia un commento

Devi essere connesso per inviare un commento.