Si prevede che il mercato delle reti collettive di data center registrerà un CAGR di circa l’11–13% nei prossimi anni, diverse fonti (1, 2) suggeriscono che all’interno di questo mercato InfiniBand potrebbe crescere ad un CAGR di circa il 40% rispetto al suo valore attuale. dimensione attuale di pochi miliardi di dollari.

Esiste un altro pezzo importante del mercato degli acceleratori per data center, in cui la situazione competitiva è esattamente l’opposto di quanto discusso fino ad ora sulla strategia di Nvdia, ovvero le soluzioni di rete per data center.

In questo caso, Nvidia è la sfidante dell’attuale equilibrio e ha già dimostrato come si possa rapidamente sconvolgere un mercato.

Il protocollo universale originale per la rete di computer cablati è Ethernet, che è stato progettato per offrire un’interconnessione semplice, flessibile e scalabile nelle reti locali o nelle reti geografiche.

Con l’emergere dell’informatica ad alte prestazioni e dei data center su larga scala, le soluzioni di rete Ethernet hanno dovuto affrontare una nuova opportunità di mercato in espansione e hanno rapidamente stabilito un’elevata penetrazione grazie alla loro accettazione .

Tuttavia, è stato stabilito un nuovo standard, InfiniBand, progettato specificamente per connettere server, dispositivi di archiviazione e di rete in ambienti informatici ad alte prestazioni concentrandosi su bassa latenza, alte prestazioni, basso consumo energetico e affidabilità. Legetevi un bell ‘articolo su Linkedin.

Nel 2005, 10 dei 100 migliori supercomputer del mondo utilizzavano la tecnologia di rete InfiniBand, numero che è salito a 48 nel 2010 e si attesta attualmente a 61.

Il principale fornitore di apparecchiature di rete basate su InfiniBand era stata Mellanox, fondata da ex dirigenti Intel nel 1999 in Israele ed è nata come azienda di semiconduttori specializzata in tecnologie di rete di interconnessione per data center e calcolo ad alte prestazioni.

Nel 2019, c’è stata una vera e propria guerra di offerte tra Nvidia, Intel e Xilinx (acquisita da AMD) per acquisire l’azienda, dove Nvidia è riuscita a fornire l’offerta più generosa con 6,9 miliardi di dollari.

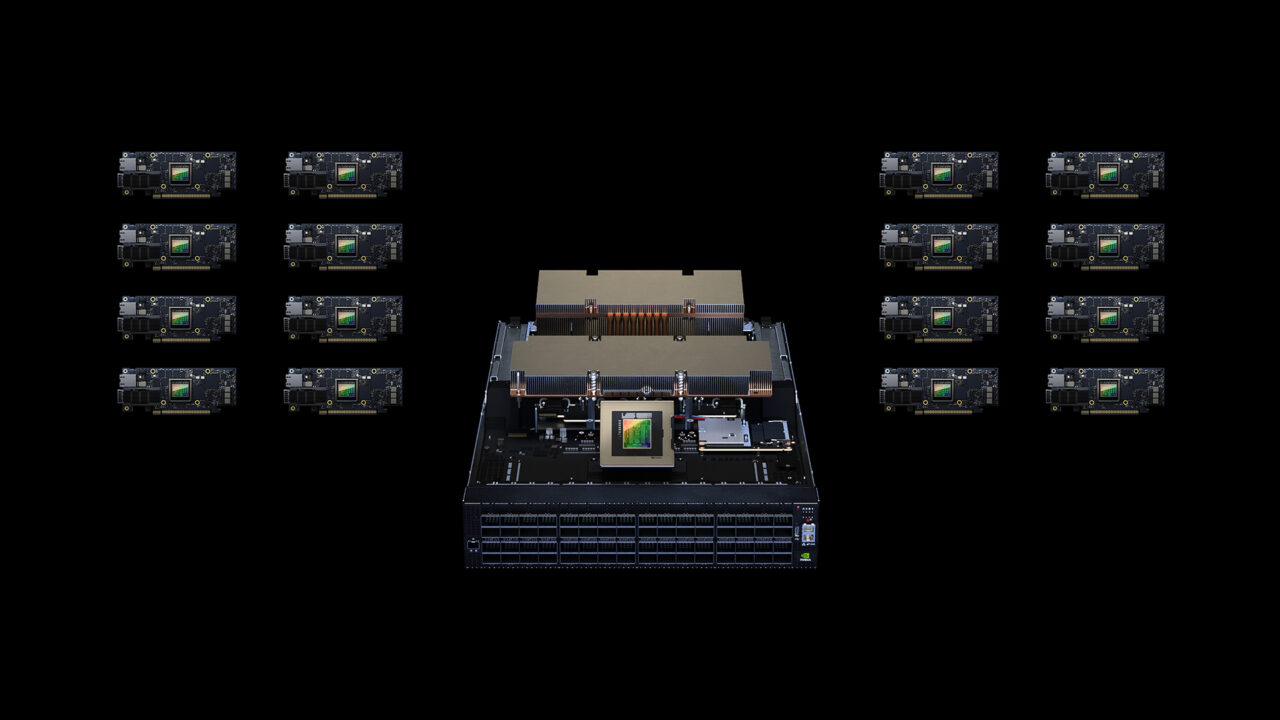

Questa acquisizione ha permesso l’ integrazione di rete e GPU e ha creato enormi miglioramenti delle prestazioni nei carichi di lavoro informatici come l’IA che richiedono larghezza di banda elevata e bassa latenza, offrendo una soluzione data center integrata che nessun concorrente nel campo delle GPU o della rete possiede. L’integrazione della rete di Mellanox con le GPU NVIDIA ha creato una soluzione di elaborazione e rete end-to-end innovativa che ha portato aal suo HGX HGX(8 GPU Nvidia con rete integrata). HGX è appositamente progettato per questi carichi di lavoro informatici altamente impegnativi, senza ostacoli da vincoli di rete.

Con questa acquisizione perfettamente tempestiva, hanno portato internamente la tecnologia di rete InfiniBand, che si è rivelata un enorme successo grazie alla rapida affermazione dell’intelligenza artificiale nel 2023. Questo dimostra che lo standard ha ottenuto un’ampia accettazione negli ambienti informatici ad alte prestazioni, dove risiedono le tecnologie di intelligenza artificiale.

Oltre ad acquisire il know-how InfiniBand di Mellanox, Nvidia ha guadagnato molto di più con l’acquisizione. Ciò può essere riassunto dalla seguente diapositiva tratta da una presentazione agli investitori di Mellanox dell’aprile 2020, l’ultima come società autonoma prima che Nvidia completasse l’acquisizione.

Oltre allo standard InfiniBand, Mellanox eccelleva anche nella produzione di dispositivi Ethernet di fascia alta, occupando una posizione leader negli adattatori, ma soprattutto anche negli switch Ethernet e nelle schede NIC (interfaccia di rete intelligente).

Sulla base di queste tecnologie Nvidia è stata anche in grado di offrire soluzioni di rete competitive per coloro che desiderano attenersi agli standard Ethernet.

La piattaforma Spectrum-X basata su Ethernet recentemente introdotta ne è un buon esempio, che secondo l’azienda fornisce prestazioni di rete 1,6 volte più veloci.

Dell , HPE e Lenovo hanno già annunciato che integreranno Spectrum-X nei propri server, aiutando i clienti che desiderano accelerare i carichi di lavoro AI.

Oltre alle tecnologie InfiniBand e Spectrum-X, che in genere collegano interi server GPU costituiti da 8 GPU Nvidia, Nvidia ha sviluppato l’interconnessione diretta GPU-to-GPU NVLink, che costituisce l’altra parte critica delle soluzioni di rete dei data center.

Questa tecnologia presenta anche numerosi vantaggi rispetto al protocollo bus PCIe standard utilizzato per collegare le GPU tra loro.

Tra gli altri, questi includono l’accesso diretto alla memoria eliminando la necessità del coinvolgimento della CPU o della memoria unificata che consente alle GPU di condividere un pool di memoria comune.

Le dimensioni del business networking di Nvidia hanno già superato la cifra di 10 miliardi di dollari nell’ultimo trimestre del terzo trimestre dell’anno fiscale 2024, quasi triplicando rispetto a un anno fa.

La combinazione delle GPU all’avanguardia di Nvidia con le sue soluzioni di rete avanzate nella piattaforma di supercalcolo HGX è stata un’eccellente mossa di vendita (per non parlare della linea di prodotti Grace CPU), creando essenzialmente l’architettura di riferimento per i carichi di lavoro AI.

La rapidità con cui questo mercato potrebbe evolversi nei prossimi anni è ciò di cui vorrei discutere nei prossimi articoli.

Il contenuto del presente articolo deve intendersi solo a scopo informativo e non costituisce una consulenza professionale. Le informazioni fornite sono ritenute accurate, ma possono contenere errori o imprecisioni e non possono essere prese in considerazione per eventuali investimenti personali.

Lascia un commento

Devi essere connesso per inviare un commento.